4月29日·阿里Qwen3开源,登顶全球开源模型王座

4月29日·周二 AI工具和资源推荐

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

阿里Qwen3开源,登顶全球开源模型王座

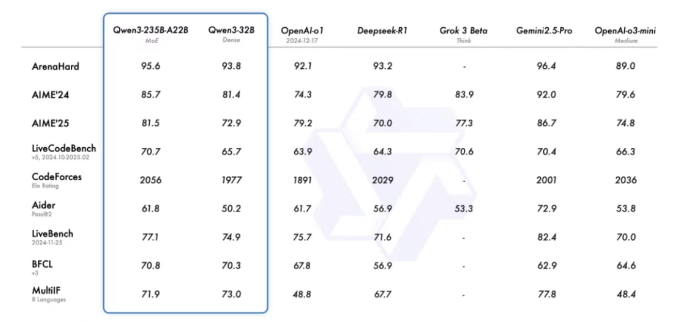

4月29日凌晨,阿里新一代通义千问模型Qwen3正式开源,并迅速登顶全球最强开源模型宝座。Qwen3采用混合专家(MoE)架构,总参数量达235B,激活仅需22B,预训练数据量高达36T。其性能全面超越DeepSeek-R1和OpenAI o1等顶尖模型,推理能力显著增强,在数学、代码生成和常识逻辑推理方面表现卓越。Qwen3支持119种语言和方言,部署成本大幅下降,仅需4张H20即可部署满血版。此次开源的Qwen3家族包含8款混合推理模型,全部免费商用,已在魔搭社区、Hugging Face、GitHub上线,个人用户可通过通义APP体验。来源:微信公众号【新智元】

无问芯穹开源三大推理加速神器,推动端云推理系统升级

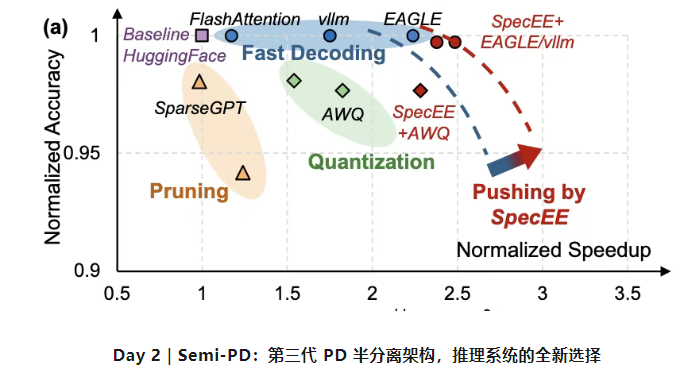

无问芯穹在终端和云端连续开源三项推理加速技术,助力新一代端云推理系统的发展。这三项技术分别是:SpecEE、Semi-PD和FlashOverlap。SpecEE通过基于推测的Early Exiting机制,显著提升了端侧推理速度,尤其在AI PC场景下,性能提升超过2倍。Semi-PD作为第三代PD半分离架构,采用“计算分离、存储融合”的设计理念,通过动态资源调整机制,最大化有效吞吐量。FlashOverlap提出了一种基于信号的计算通信重叠技术,可实现高达1.65倍的性能提升,尤其适用于低端消费卡。这些技术的开源旨在推动大模型在端侧和云侧的高效应用,降低通信开销,提升推理效率,加速AI技术的普惠与产业升级。来源:微信公众号【机器之心】

ISCA Fellow 2025公布,三位华人学者入选

近日,国际语音通讯协会(ISCA)公布了2025年ISCA Fellow入选名单,共有8位学者入选,其中包括三位华人:思必驰联合创始人、上海交通大学特聘教授俞凯,中国台湾大学教授李宏毅,以及新加坡科技研究局旗下资讯通信研究所生成式AI小组和AI for Education项目负责人Nancy Chen。ISCA Fellow旨在表彰在语音通信科学与技术领域做出杰出贡献的会员,每年新增人数不超过会员总数的千分之三。俞凯因其在语音识别、口语对话系统及口语技术部署方面的贡献入选;李宏毅在语音自监督学习及社区基准构建方面做出开创性贡献;Nancy Chen则在多语言语音处理、多模态人机通信和AI技术部署方面展现出卓越的技术领导力。此次入选体现了他们在语音领域的卓越成就和国际影响力。来源:微信公众号【机器之心】

UC伯克利研究发现:推理模型无需思考过程也能更高效

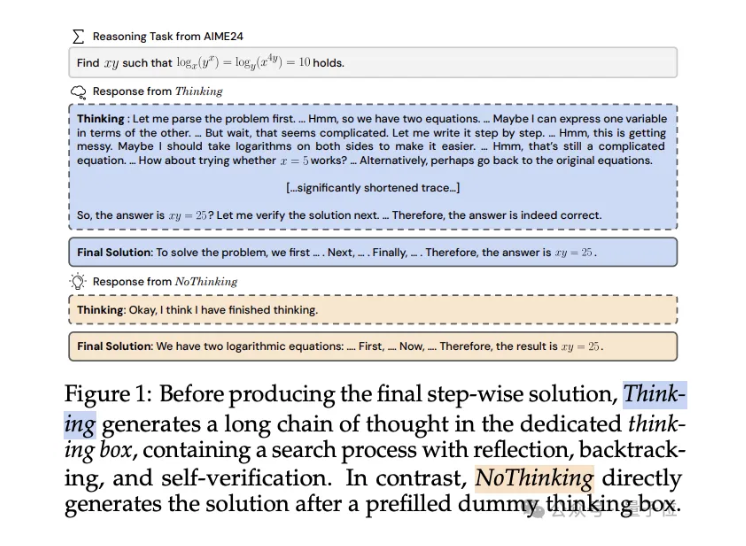

UC伯克利和艾伦实验室团队的最新研究提出了一种“无思考(NoThinking)”方法,表明推理模型在某些情况下跳过显式思考过程直接生成解决方案,可能比传统思考方式更有效。实验数据显示,在低资源(少token数量、少模型参数)或低延迟情况下,NoThinking方法在多个推理任务中的表现优于传统思考方法,尤其是在数学问题解决、形式定理证明和编程任务中。该研究还发现,NoThinking方法在并行扩展时展现出更高的效率,能够显著降低延迟和token使用量。这一发现挑战了传统观点,即推理模型需要详细思考过程才能有效工作,为推理模型的优化提供了新的方向。来源:微信公众号【量子位】

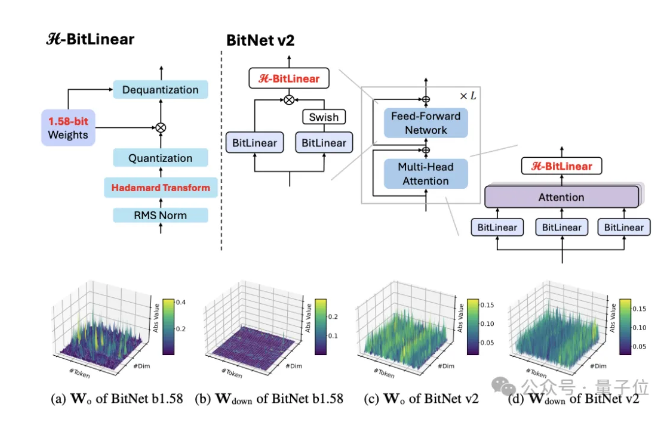

微软发布BitNet v2,实现1bit LLM的4bit激活值量化

微软最新研究推出了BitNet v2框架,为1bit LLM实现了原生4bit激活值量化,充分利用新一代GPU(如GB200)对4bit计算的原生支持能力,显著提升了计算效率并减少了内存带宽占用。BitNet v2通过引入H-BitLinear模块,在激活量化前应用Hadamard变换,将尖锐的激活分布重塑为更接近高斯分布的形式,减少了异常值数量,从而实现了4bit激活量化。实验结果显示,BitNet v2在不同模型规模上均表现出色,4bit激活版本相比8bit激活版本性能几乎不下降,且在低bit注意力状态实验中,其准确率与全精度版本相当。该研究为大模型的高效推理提供了新的技术路径。来源:微信公众号【量子位】