TesserAct:AI 4D具身世界模型,能预测3D场景的动态演变

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

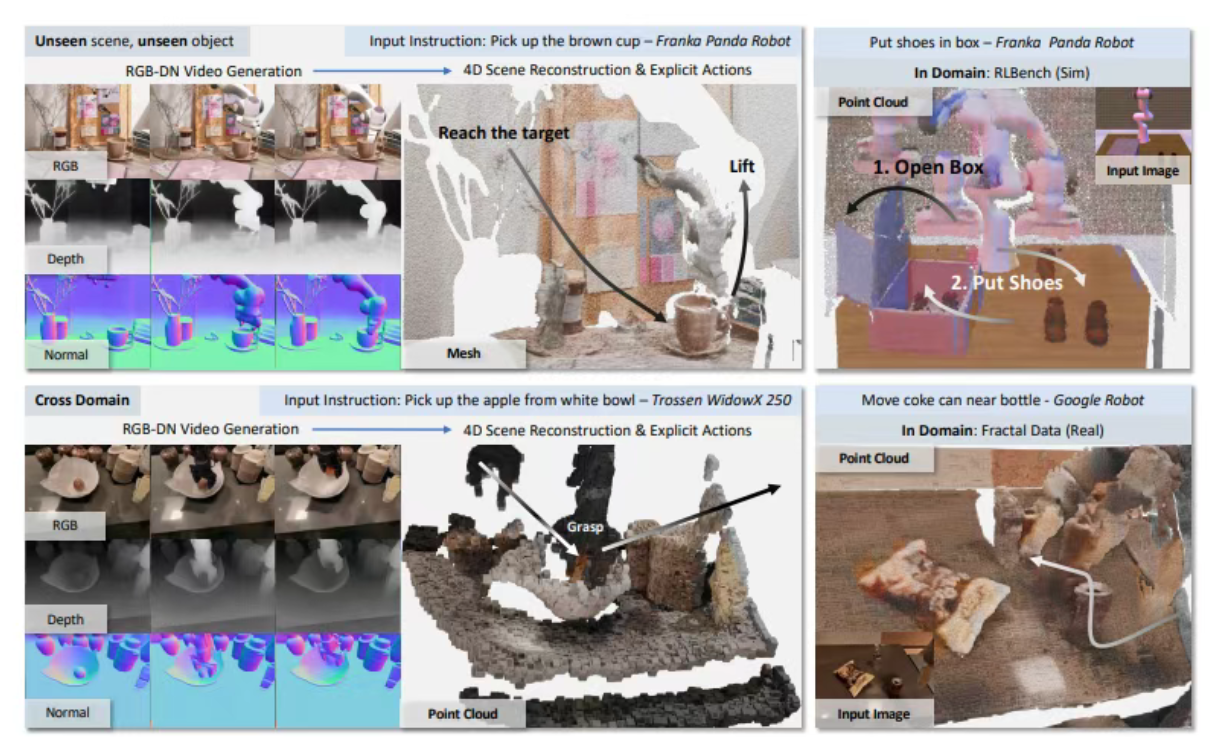

TesserAct是由香港科技大学、哈佛大学等团队联合提出的AI 4D具身世界模型,旨在通过预测3D场景随时间的动态演变,为具身智能体(如机器人)提供精确的环境感知与决策能力。该模型通过RGB-DN(RGB、深度和法线)视频训练,能够模拟4D世界(3D空间+时间),生成高质量的4D场景数据,支持智能体在复杂动态环境中的任务执行。TesserAct突破了传统2D模型的局限,能够捕捉场景的几何结构和时间变化,为机器人操作、自动驾驶等领域提供关键技术支持。

功能特点

- 4D场景预测

- 根据具身智能体的动作,预测3D场景随时间的动态演变,生成时空连贯的4D场景。

- RGB-DN视频生成

- 生成包含RGB图像、深度图和法线图的视频流,提供丰富的几何和外观信息。

- 高保真度与一致性

- 保证预测的4D场景在空间和时间上的连贯性,实现新视角合成和策略学习。

- 支持逆动力学建模

- 通过预测场景动态,帮助智能体学习精确的逆动力学模型,提升操作精度。

- 多模态数据融合

- 结合视觉、深度和法线信息,提供全面的环境感知能力。

优缺点

优点:

- 突破2D局限:能够模拟3D世界的动态变化,生成传统2D模型无法实现的逼真交互。

- 高精度预测:通过RGB-DN视频生成,提供详细的几何和外观信息,支持精确的环境感知。

- 时空连贯性:保证预测的4D场景在时间和空间上的一致性,适用于复杂任务。

- 支持逆动力学建模:帮助智能体学习精确的逆动力学模型,提升操作能力。

缺点:

- 计算成本高:4D场景的训练和学习需要大量计算资源,成本较高。

- 数据依赖性强:需要高质量的RGB-DN视频数据进行训练,数据获取和标注难度较大。

- 复杂场景适应性有限:在极端复杂或动态变化的场景中,预测精度可能下降。

如何使用

- 数据准备

- 收集或生成RGB-DN视频数据集,包含RGB图像、深度图和法线图。

- 模型训练

- 使用TesserAct提供的框架,在数据集上训练4D世界模型。

- 推理与预测

- 输入当前场景的RGB-DN视频和智能体的动作,模型输出预测的未来4D场景。

- 集成与应用

- 将预测的4D场景集成到机器人或自动驾驶系统中,支持决策与控制。

框架技术原理

- RGB-DN视频表示

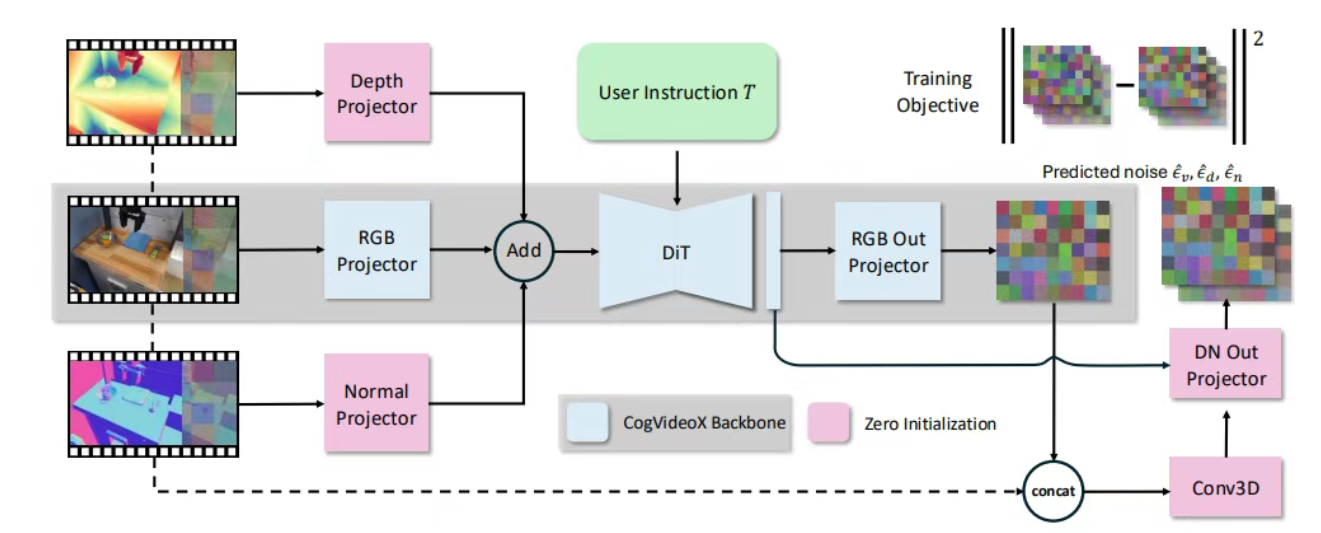

- 使用RGB图像、深度图和法线图表示4D场景,捕捉场景的外观和几何信息。

- 视频生成模型

- 基于预训练的CogVideoX模型,扩展输出端以预测完整的RGB-DN数据。

- 优化算法

- 利用法线图优化深度图,使用光流算法区分动态与静态区域,引入时空连续性约束。

- 扩散模型

- 通过正向过程向数据中添加噪声,训练去噪器从噪声状态恢复数据,生成高质量的RGB-DN视频。

创新点

- 4D场景建模

- 首次提出通过RGB-DN视频建模4D场景,支持时空连贯的预测。

- 高效表示方法

- 使用RGB-DN视频作为中间表示,兼顾计算效率和预测精度。

- 优化算法

- 提出将生成的RGB-DN视频转换为高质量4D场景的算法,保证场景的真实感。

- 支持语言条件控制

- 从当前帧和文本描述的智能体动作直接预测4D场景,增强交互能力。

评估标准

- 场景生成质量

- 评估预测的4D场景在几何和外观上的保真度。

- 时空连贯性

- 测量场景在时间和空间上的一致性,避免跳跃或不连续。

- 任务性能

- 在下游任务(如机器人操作、自动驾驶)中评估模型的实际表现。

- 计算效率

- 测量模型的训练和推理速度,评估资源占用情况。

应用领域

- 机器人操作

- 支持机器人在复杂环境中的精确操作,如抓取、装配等。

- 自动驾驶

- 预测道路场景的动态变化,支持安全决策与规划。

- 虚拟现实与增强现实

- 生成逼真的4D场景,提升用户体验。

- 仿真与训练

- 为智能体提供高质量的仿真环境,支持策略学习与优化。

项目地址

- 项目官网:https://tesseractworld.github.io/

- Github仓库:https://github.com/UMass-Embodied-AGI/TesserAct

- HuggingFace模型库:https://huggingface.co/anyeZHY/tesseract

- arXiv技术论文:https://arxiv.org/pdf/2504.20995

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...