Qwen2.5-Omni-3B : 阿里 Qwen 团队推出的轻量级多模态 AI 模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

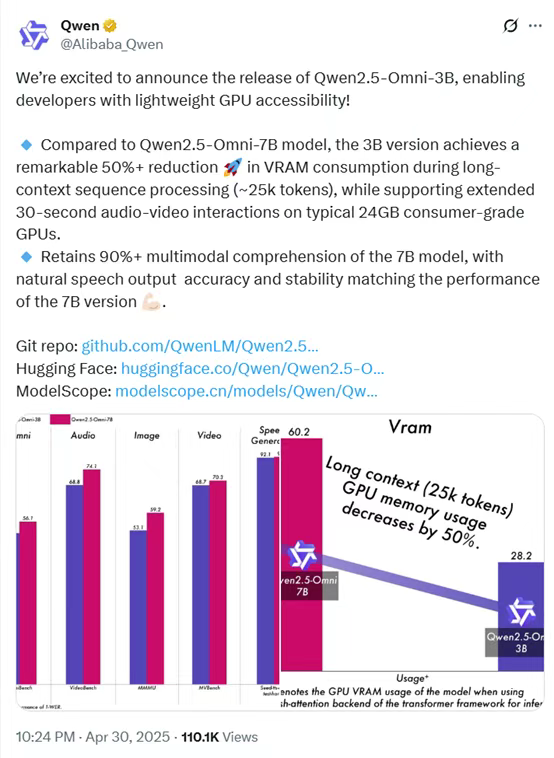

Qwen2.5-Omni-3B 是阿里巴巴 Qwen 团队于 2025 年 4 月 30 日发布的轻量级多模态 AI 模型,专为消费级 GPU 部署设计。该模型通过将参数规模缩减至 30 亿,同时保留接近 70 亿参数模型(Qwen2.5-Omni-7B)90%以上的多模态理解能力,显著降低了硬件门槛和资源消耗。其核心优势在于支持文本、图像、音频和视频的统一输入与处理,适用于边缘计算、实时交互系统和长上下文任务场景。模型已在 GitHub、Hugging Face 和 ModelScope 等平台开源,为开发者和研究者提供了高效、低成本的 AI 工具。

功能特点

- 多模态输入支持

- 支持文本、图像、音频和视频的统一输入,适用于复杂场景下的多模态任务。

- 低资源占用

- 在 24GB 显存的消费级 GPU(如 NVIDIA RTX 4090)上可运行,显存占用降低超 50%。

- 长上下文处理

- 可处理长达 25,000 个 token 的输入,适用于长文档推理、视频字幕理解和跨时间轴语义分析。

- 实时交互能力

- 支持最长 30 秒的语音和视频对话输入,保持低延迟和语义一致性。

- 高质量输出

- 语音清晰度与语调控制接近 7B 模型,适用于语音助手、智能客服等场景。

优缺点

优点:

- 硬件门槛低:可在消费级 GPU 上运行,适合教育机构、中小型企业及个人开发者。

- 性能优异:在多模态任务中的理解性能可达 7B 模型的 90%以上。

- 灵活部署:支持多种平台(GitHub、Hugging Face、ModelScope),便于集成与应用。

缺点:

- 参数规模限制:3B 参数在生成丰富度与高精度任务上略逊于 7B 模型。

- 商用限制:目前仅限研究用途,企业商用需单独获取许可。

如何使用

- 环境配置

- 安装 Git、Anaconda、PyTorch 和 ModelScope 库。

- 创建虚拟环境并激活,安装依赖项。

- 模型下载

- 使用 ModelScope 下载 Qwen2.5-Omni-3B 模型权重(约 12GB)。

- 运行示例

- 修改代码中的模型路径,运行

web_demo.py启动图形化界面。 - 支持 Online 模式(调用麦克风和摄像头)和 Offline 模式(上传本地文件)。

- 修改代码中的模型路径,运行

框架技术原理

- 模块化设计

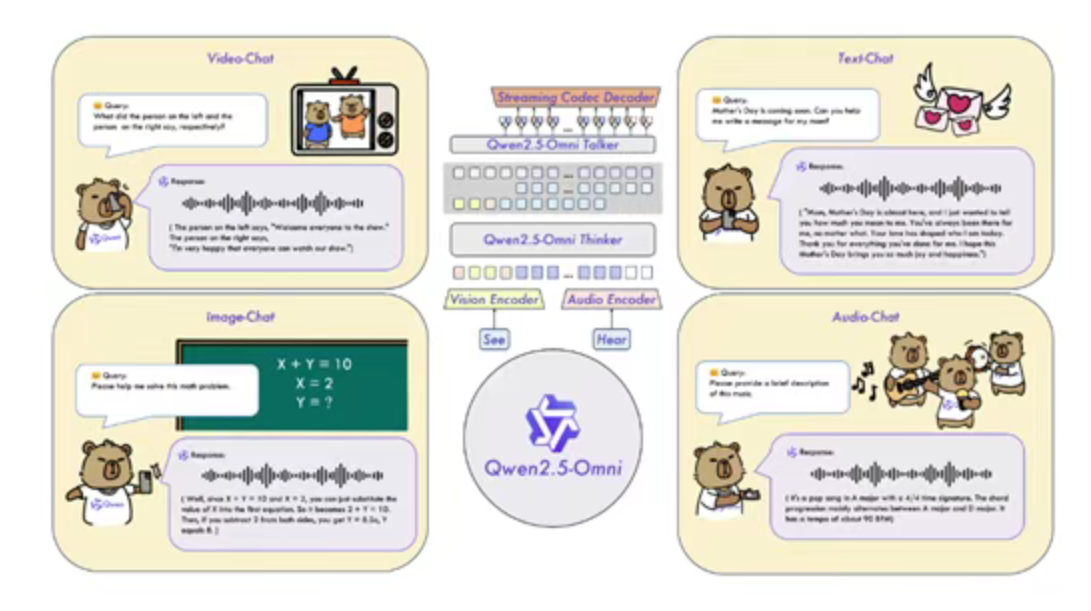

- 基于 Transformer 架构,采用模块化设计,不同模态通过专属编码器统一接入共享主干网络。

- 显存优化

- 通过 FlashAttention 2 和 BF16 精度优化,降低内存消耗并提升处理速度。

- Thinker-Talker 架构

- 采用创新的“Thinker-Talker”架构,通过时间对齐多模态 RoPE(Rotary Position Embedding)技术,实现视频与音频输入的高效同步。

创新点

- 轻量化与高性能兼得

- 在显著降低显存占用的同时,保留了接近 7B 模型的多模态理解能力。

- 统一多模态编码

- 通过单一模型架构实现文本、图像、音频和视频的深度融合,提升任务处理效率。

- 长上下文处理能力

- 支持超长序列输入,适用于法律文档、技术手册及多轮对话摘要等高上下文需求场景。

评估标准

- 多模态理解性能

- 在视觉问答(VQA)、音频描述生成、视频理解等任务中的表现。

- 资源效率

- 显存占用、推理速度和能耗等指标。

- 实际应用效果

- 在智能客服、语音助手、实时系统等场景中的表现。

应用领域

- 边缘计算

- 在资源受限的设备上部署多模态 AI 模型。

- 实时交互系统

- 支持智能客服、语音助手、视频聊天等场景。

- 长上下文任务

- 适用于法律文档分析、技术手册处理及多轮对话摘要等场景。

项目地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...