WorldPM : 阿里Qwen团队联合复旦推出的偏好建模模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

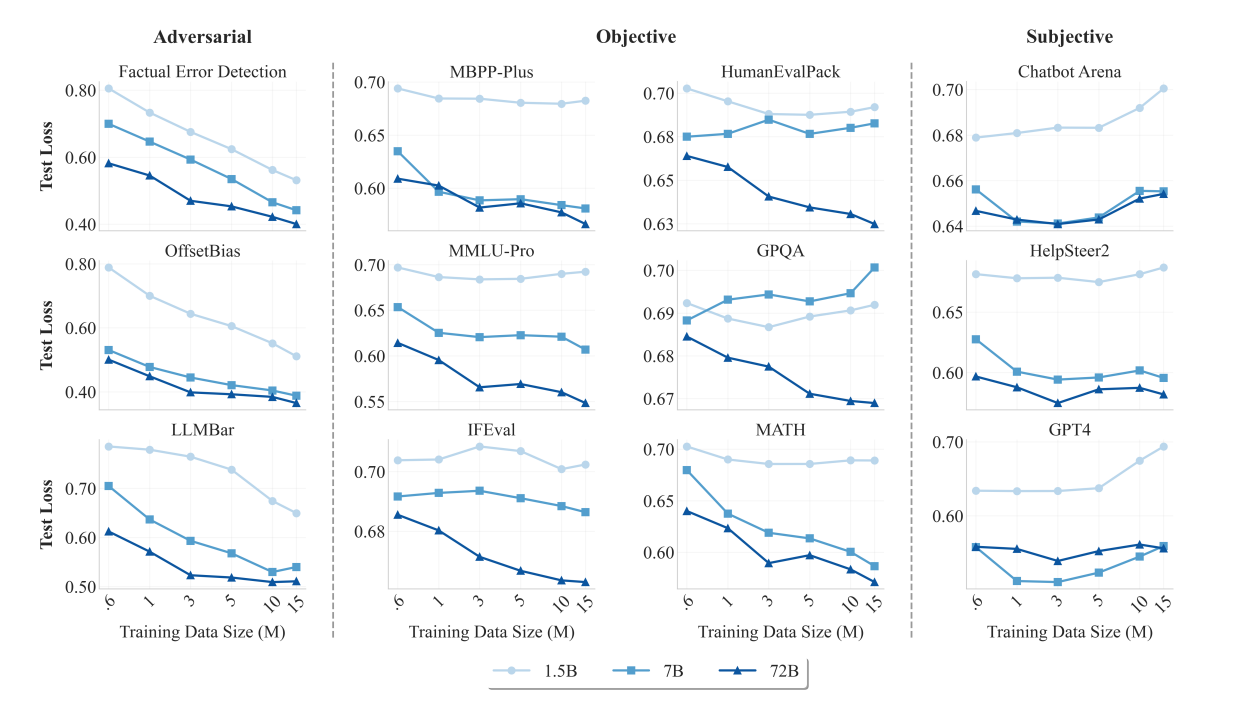

WorldPM(World Preference Modeling)是由阿里巴巴集团的Qwen团队与复旦大学联合推出的偏好建模模型系列,旨在通过大规模训练数据揭示偏好建模的规模化规律,提升模型在自然语言处理任务中的偏好理解与优化能力。该模型基于1500万条偏好数据进行训练,验证了偏好建模在客观领域遵循幂律下降趋势,而在主观领域因多维度特性难以呈现单一扩展趋势。WorldPM提供72B规模的基础模型及多个针对特定数据集微调的版本,支持开发者高效优化模型性能,尤其在对话系统、推荐系统等领域展现出强大潜力。

功能特点

- 大规模偏好建模:基于1500万条偏好数据进行训练,涵盖不同用户群体的投票数据,确保模型在多文化和语言背景下的适应性。

- 多版本支持:提供基础模型(如WorldPM-72B)及多个微调版本(如WorldPM-72B-HelpSteer2、WorldPM-72B-UltraFeedback、WorldPM-72B-RLHFLow),满足不同任务需求。

- 高效优化能力:通过偏好建模,显著提升模型在监督学习中的表现,尤其在需要理解人类偏好的场景下表现突出。

- 风格中立性:优化风格偏好分析,减少主观评估中的偏见,提升模型在客观任务(如编码、数学)中的准确性。

优缺点

优点:

- 数据驱动:基于大规模偏好数据训练,模型泛化能力强。

- 灵活微调:提供多个微调版本,支持开发者根据特定任务进行优化。

- 风格中立:减少主观偏见,提升模型在客观任务中的表现。

- 开源共享:采用Apache 2.0协议发布,全球开发者可免费下载和使用。

缺点:

- 主观评估限制:在主观偏好评估中,模型性能受限于多维度特性,难以呈现单一扩展趋势。

- 计算资源需求:大规模训练需要高性能计算资源,可能限制部分开发者的使用。

如何使用

-

安装与配置:

- 从Hugging Face平台下载模型(如WorldPM-72B)及其依赖库。

- 配置Python环境,安装必要的依赖(如

transformers、torch等)。

-

偏好评分:

- 定义对话或文本对,通过模型计算偏好得分。

框架技术原理

- 数据收集与处理:

- 从StackExchange、Reddit等公共论坛收集用户生成的偏好数据,基于投票机制形成偏好对。

- 模型训练:

- 采用二元偏好对的建模框架,计算每个回答的奖励分数,优化基于Bradley-Terry模型的BT损失函数。

- 借鉴语言建模中的规模定律,通过增加模型参数规模和训练数据量提升性能。

- 风格偏好分析与控制:

- 分离风格特征(如文本长度、Markdown格式)和内容特征,减少风格因素对评估结果的干扰。

创新点

- 规模化偏好建模:验证了偏好建模在客观领域遵循幂律下降趋势,揭示了偏好模型的可扩展性。

- 多版本微调:提供多个针对特定数据集微调的版本,支持开发者高效优化模型性能。

- 风格中立性优化:减少主观评估中的偏见,提升模型在客观任务中的准确性。

评估标准

- 生成质量:通过用户调研评估模型生成文本的真实感、连贯性及细节还原度。

- 偏好匹配度:对比用户草图(或偏好数据)与生成结果的几何细节匹配度。

- 鲁棒性:测试模型在处理错误或不完整信息时的表现。

- 计算效率:记录单次推理时间及显存占用,评估实时应用潜力。

应用领域

- 自然语言处理:优化对话系统、推荐系统的输出质量。

- 强化学习:作为奖励模型,指导策略模型生成更符合人类偏好的内容。

- 内容审核:识别过滤错误或有害信息,提升内容安全性。

- 多模态应用:扩展到图像和视频等多模态内容的偏好建模。

项目地址

- GitHub仓库:https://github.com/QwenLM/WorldPM

- HuggingFace模型库:https://huggingface.co/Qwen/WorldPM-72B

- arXiv技术论文:https://arxiv.org/pdf/2505.10527

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...