QwenLong-L1-32B:阿里Qwen-Doc推出的长文本推理大模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

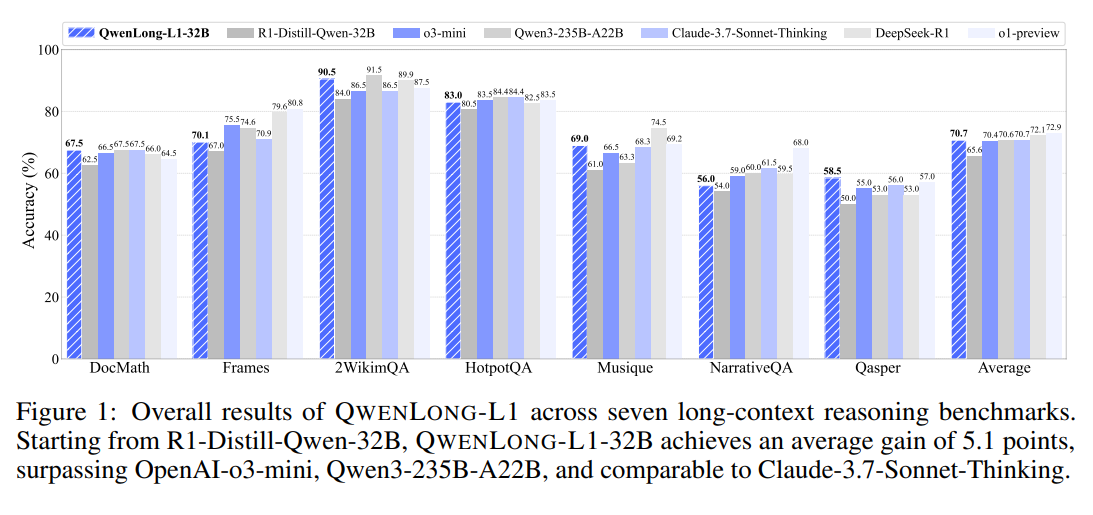

QwenLong-L1-32B是阿里Qwen-Doc团队于2025年5月26日开源的长文本推理大模型,基于QwenLong-L1框架开发,是全球首个通过强化学习训练的长文本情境推理模型。该模型通过渐进式上下文扩展和混合奖励机制,显著提升了长文本推理的准确性和效率,在长文本问答、文档分析等任务中性能达到行业领先水平。

功能特点

- 超长上下文处理:支持高达131,072个tokens的上下文窗口,可处理超长文本。

- 强化学习训练:采用GRPO(组相对策略优化)和DAPO(直接对齐策略优化)算法,结合混合奖励函数,提升推理能力。

- 多任务适配:在数学、逻辑、多跳推理等领域表现优异,适用于复杂长文本任务。

- 高效推理:在保持高性能的同时,优化了计算效率,降低了资源消耗。

优缺点

优点:

- 长文本处理能力强:支持超长上下文,适用于复杂文档分析。

- 推理性能优异:在多个基准测试中达到或超越行业领先模型。

- 开源生态友好:代码、训练日志、评估工具等资源全部开源,支持自由使用。

缺点:

- 硬件要求较高:训练和推理需要较强的计算资源支持。

- 特定领域优化有限:在部分垂直领域可能需要进一步微调。

如何使用

- 安装依赖:

- 加载模型:

- 输入处理:

将长文本输入模型,支持高达131,072个tokens的上下文。 - 生成输出:

框架技术原理

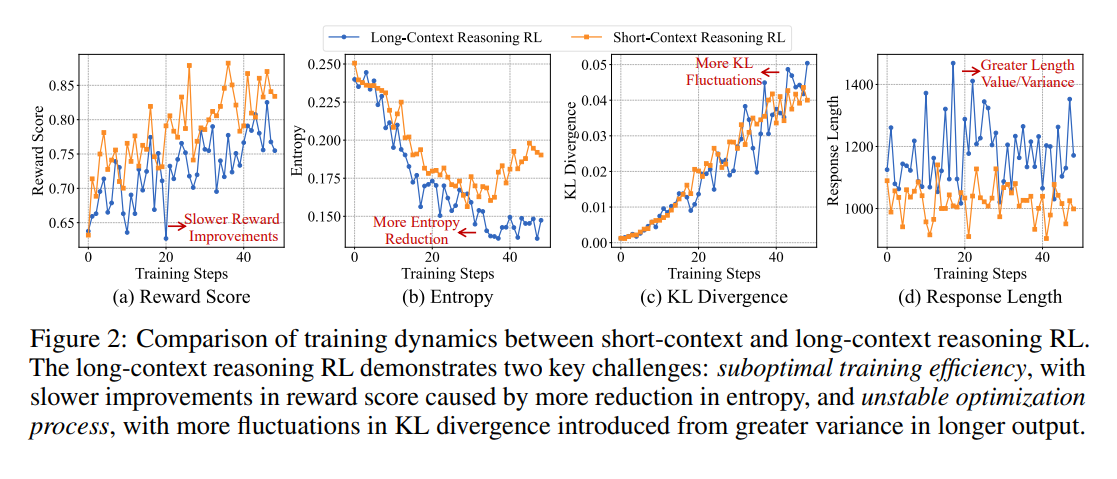

- 渐进式上下文扩展:通过课程式分阶段强化学习,逐步提升模型对长上下文的适应能力。

- 混合奖励函数:结合基于规则的验证和基于模型的判断,平衡精度和召回率。

- 监督微调预热:在强化学习训练前,通过监督微调构建稳定的初始策略。

- 难度感知回顾采样:优先探索复杂实例,增强模型的探索能力。

创新点

- 强化学习在长文本推理中的应用:首次将强化学习引入长文本推理场景,构建起“渐进式上下文扩展”训练框架。

- 混合奖励机制:结合基于规则和模型的二元结果奖励,提升模型在长文本任务中的表现。

- 开源完整解决方案:提供模型、训练数据集、训练方法和评估体系的全链条工具,加速长文本AI应用的产业化进程。

评估标准

- 准确性:在长文本问答基准测试中评估模型的输出正确率。

- 鲁棒性:测试模型在OOD(分布外)数据和对抗样本下的表现。

- 效率:评估模型的推理速度和资源占用情况。

- 长文本处理能力:验证模型在超长上下文下的性能表现。

应用领域

- 文档分析:处理法律文件、学术论文等超长文本。

- 智能问答:支持复杂长文本的问答系统。

- 知识图谱构建:从长文本中提取结构化知识。

- 代码生成:结合长上下文理解,生成高质量代码。

项目地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...