EVI 3 : Hume AI推出的语音语言模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

EVI 3(Empathic Voice Interface 3)是Hume AI推出的第三代情感智能语音语言模型,基于共情大语言模型(eLLM)技术,结合语义空间理论与多模态情感计算,支持实时语音交互与情绪感知。该模型通过分析用户的语音语调、节奏、音色及文本内容,识别53种以上情绪状态,并以低于700毫秒的延迟生成情感适配的语音回应。EVI 3旨在为医疗保健、AR/VR、客户服务、心理健康支持等领域提供高自然度、高同理心的AI语音交互体验,推动人机对话从功能型向情感型升级。

功能特点

- 多模态情感感知

- 通过语音韵律(语调、音色、节奏)和文本语义,识别用户情绪(如喜悦、愤怒、焦虑等),并生成情感适配的回应。

- 实时交互与低延迟

- 支持用户随时打断对话,模型可从中断点恢复,响应延迟低于700毫秒,实现流畅的类人对话。

- 个性化语音风格

- 支持自定义AI的语音音色、语速、情感表达强度,适配不同场景需求(如心理咨询、虚拟助手)。

- 零样本与少样本学习

- 无需大量标注数据即可适应新情感场景或语言,具有高灵活性和适应性。

- 多语言支持

- 支持英语、中文等多语言交互,适用于全球化应用场景。

优缺点

优点

- 情感理解精准:基于数百万次人类互动数据训练,情感识别准确率高。

- 交互自然流畅:支持实时打断与恢复,对话体验接近人类。

- 应用场景广泛:兼容医疗、教育、娱乐、客服等多个领域。

缺点

- 硬件要求高:实时情感计算与低延迟响应需高性能GPU支持。

- 复杂情绪识别局限:在极端情绪或混合情绪场景下,识别精度可能下降。

- 数据隐私风险:需处理用户语音与文本数据,需严格的安全与合规措施。

如何使用

- 接入API

- 开发者可通过Hume AI官网申请API密钥,使用RESTful API或WebSocket接口集成EVI 3至应用程序。

- 配置参数

- 调整情感识别强度、语音风格、响应延迟等参数,优化交互体验。

- 集成语音输入

- 通过Media Stream API捕获用户语音,转换为音频流发送至EVI 3模型。

- 处理输出

- 接收模型返回的语音数据(如MP3、WAV格式)或文本回复,集成至应用界面。

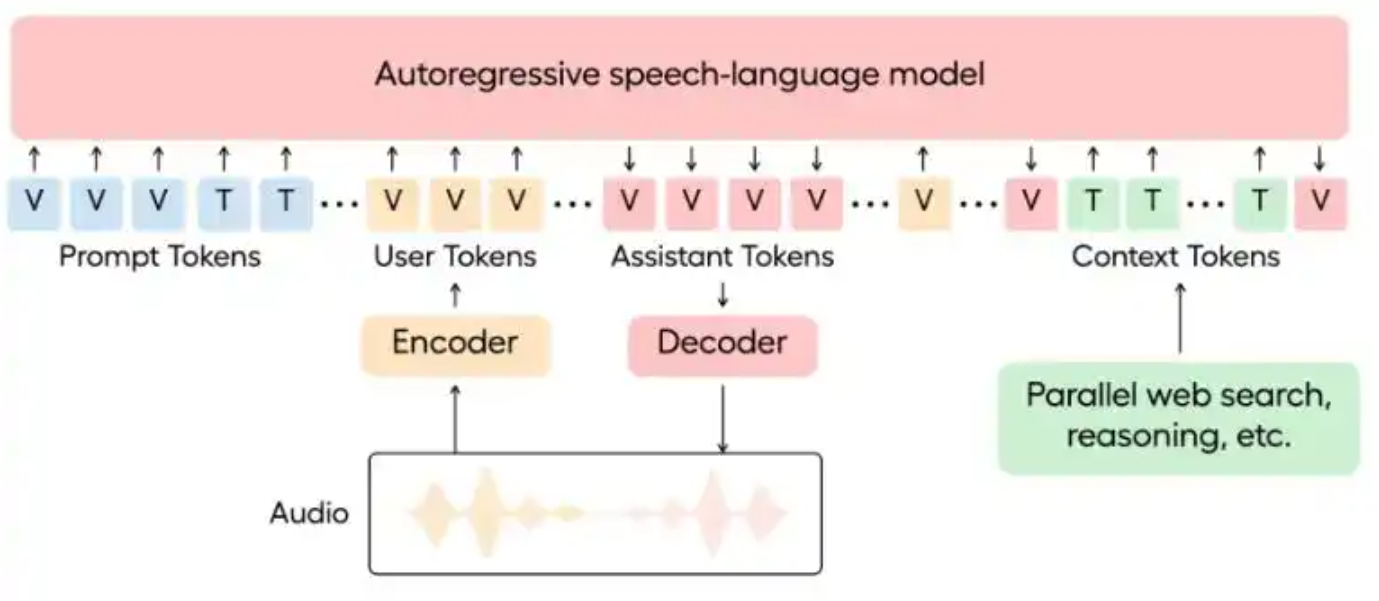

框架技术原理

- 共情大语言模型(eLLM)

- 结合大型语言模型(LLM)与情感计算技术,通过多模态Transformer架构处理语音与文本数据。

- 语义空间理论

- 基于Alan Cowen博士提出的语义空间理论,量化声音、面部和手势的情感表达,构建高维情感特征空间。

- 实时情感分析

- 使用卷积神经网络(CNN)与循环神经网络(RNN)提取语音韵律特征,结合BERT等模型分析文本情感。

- 动态响应生成

- 通过强化学习优化回应策略,确保回应内容与用户情绪高度适配。

创新点

- 情感感知与响应一体化

- 首次实现语音交互中的实时情感识别与动态回应,突破传统语音助手的功能型局限。

- 超低延迟交互

- 通过模型优化与边缘计算部署,实现低于700毫秒的响应延迟,接近人类对话水平。

- 多模态情感计算

- 整合语音、文本、面部表情(未来版本支持)等多模态数据,提升情感理解精度。

- 可解释性AI

- 提供情感识别结果的可视化反馈(如情绪柱状图),增强用户信任。

评估标准

- 情感识别准确率

- 通过人工标注数据集(如IEMOCAP)评估模型对53种情绪的识别准确率。

- 交互自然度

- 使用MOS(Mean Opinion Score)评分,评估语音回应的流畅度、情感适配度与人类相似性。

- 响应延迟

- 测量从用户输入到模型回应的时间,确保低于700毫秒。

- 用户满意度

- 通过问卷调查收集用户对交互体验的主观评价(如信任感、陪伴感)。

应用领域

- 心理健康支持

- 用于AI心理咨询师,通过情感感知与共情回应,缓解用户焦虑、抑郁等情绪。

- 虚拟助手与数字人

- 提升虚拟角色(如游戏NPC、虚拟偶像)的情感表达能力,增强用户沉浸感。

- 客户服务

- 在呼叫中心中识别客户情绪,动态调整服务策略,提升客户满意度。

- 教育与培训

- 用于AI口语教练、面试模拟等场景,提供情感反馈与个性化指导。

项目地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...