OmniConsistency: Show Lab 团队推出的扩散变换器框架

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

OmniConsistency 主要介绍

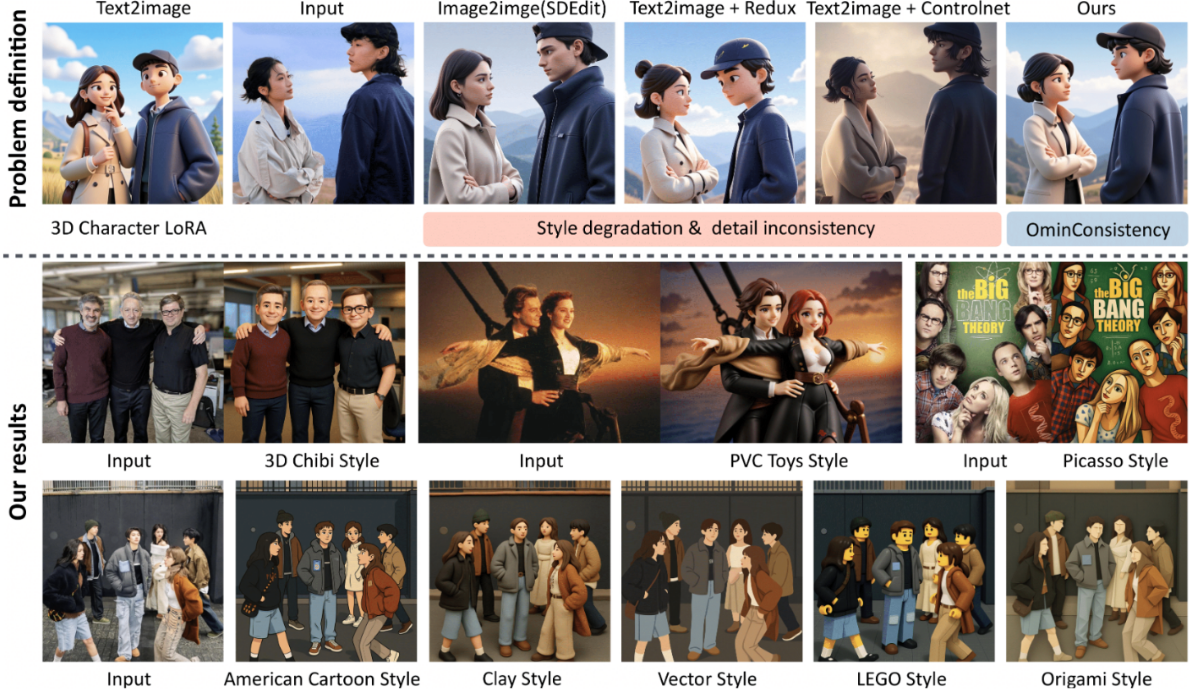

OmniConsistency 是新加坡国立大学 Show Lab 团队推出的一款基于扩散变换器(Diffusion Transformer)架构的通用一致性增强插件,旨在解决开源图像风格化模型在风格迁移过程中难以同时保持强烈风格化效果与细节、语义和结构一致性的难题。通过利用配对数据学习风格无关的一致性规律,该模型能够在保持高质量风格化输出的同时,精准保留输入图像的核心信息,为开源社区提供了接近商业级性能(如 GPT-4o)的图像风格化解决方案。

功能特点

- 风格无关的一致性保持:在多种艺术风格下均能维持输入图像的构图、语义和细节一致性。

- 即插即用兼容性:支持与任意 Flux 底模的风格 LoRA 模块无缝集成,无需额外训练。

- 高效轻量化设计:训练仅需 2600 对高质量图像对和约 500 小时 GPU 算力,推理阶段显存与时间开销仅增加约 5%。

- 多风格泛化能力:对训练阶段未见过的风格 LoRA 模块同样表现出色,显示出强大的风格无关性。

优缺点

优点:

- 低成本高效益:以极低的训练成本实现了接近商业级模型(如 GPT-4o)的性能。

- 高度灵活性:模块化设计允许用户自由选择和组合不同的风格 LoRA 模块。

- 强大泛化能力:在多种风格和复杂场景下均能保持一致性和风格化效果。

缺点:

- 数据依赖性:尽管训练数据量相对较少,但高质量配对数据的获取和筛选仍需一定成本。

- 计算资源需求:虽然推理阶段成本较低,但训练阶段仍需一定的 GPU 算力支持。

如何使用

- 安装依赖:根据项目文档安装必要的依赖库和框架。

- 加载模型:下载并加载预训练的 OmniConsistency 模型和所需的风格 LoRA 模块。

- 输入图像:选择待风格化的输入图像,并指定所需的风格类型。

- 生成输出:运行模型生成风格化后的图像,并可根据需要调整参数以优化结果。

框架技术原理

OmniConsistency 的核心技术原理包括:

- 基于配对数据的一致性学习:直接利用原图与其高一致性风格化结果的成对关系,学习图像在风格迁移中的一致性保持规律。

- 两阶段风格-一致性解耦训练策略:第一阶段独立训练各种风格的 LoRA 模块,第二阶段冻结风格 LoRA,仅训练一致性模块,从而彻底分离风格表达与一致性保持。

- 模块化架构设计:一致性模块与风格 LoRA 使用独立插槽,确保架构上的无参数冲突,支持即插即用。

创新点

- 风格-一致性解耦学习方法:通过全新的训练策略,彻底打破了风格化与一致性之间的跷跷板困境。

- 因果注意力机制:引导模型关注配对图像风格化前后的一致性,提高风格迁移的准确性。

- 滚动 LoRA 银行加载机制:确保一致性模块专注于跨风格保持结构和语义,而不学习任何具体风格内容。

评估标准

- 风格一致性:通过 FID、CMMD 等指标评估生成图像与目标风格之间的一致性程度。

- 内容一致性:评估生成图像在细节、语义和结构上与输入图像的保持程度。

- 泛化能力:测试模型在未见过的风格 LoRA 模块上的表现,评估其风格无关性。

- 推理效率:评估模型在推理阶段的显存占用和时间开销。

应用领域

- 艺术创作:为艺术家和设计师提供高效的图像风格化工具,辅助创作过程。

- 娱乐产业:用于游戏、动画等领域的角色和场景风格化,提升视觉效果。

- 广告设计:快速生成符合品牌风格的广告图像,提高设计效率。

- 虚拟现实与增强现实:为 VR/AR 应用提供实时的图像风格化功能,增强用户体验。

项目地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...