OmniAudio : 阿里通义推出的空间音频生成模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

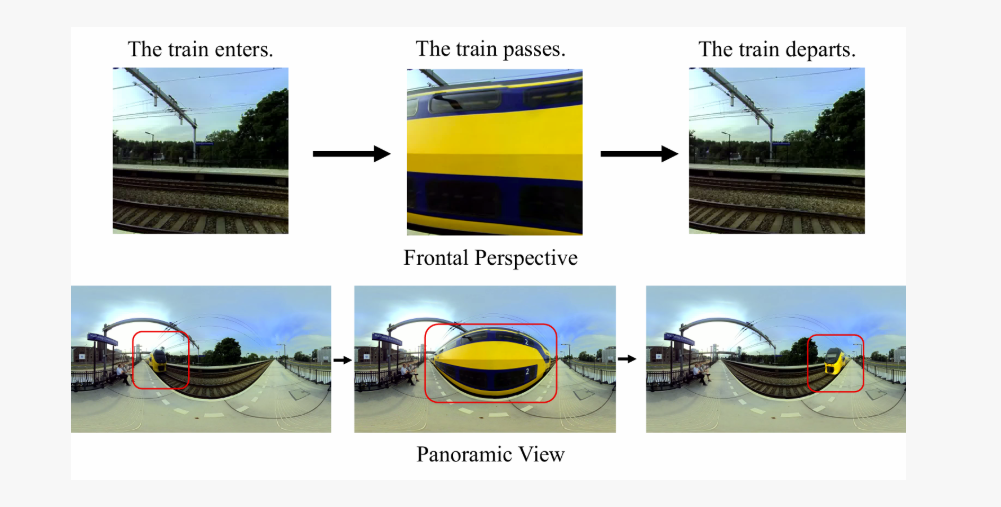

OmniAudio是阿里通义实验室推出的一项突破性空间音频生成技术,能够直接从360°视频生成FOA(First-order Ambisonics)空间音频,为虚拟现实和沉浸式娱乐带来全新可能。该技术解决了传统空间音频制作依赖专业设备与人工后期的痛点,通过自监督coarse-to-fine预训练和双分支视频表示微调,在非空间音频质量和空间定位准确性上显著优于现有方法。项目包含超过103,000个视频片段的Sphere360数据集,支持高质量的模型训练与评估,代码、数据及论文均已开源,助力沉浸式体验技术发展。

功能特点

- 360°视频到空间音频生成:直接从360°全景视频生成FOA格式的3D空间音频,捕捉声音的方向性,实现真实的3D音频再现。

- 高精度空间定位:能够准确模拟声音的空间方位、距离及反射特性,提升沉浸式体验。

- 支持多种应用场景:涵盖影视制作、虚拟社交、智能座舱等多个领域。

- 开源生态:代码、数据及论文均已开源,促进技术共享与创新。

优缺点

优点:

- 技术突破:首次实现从360°视频直接生成空间音频,降低制作成本90%以上。

- 高质量数据集:Sphere360数据集包含超过103,000个视频片段,涵盖288种音频事件,总时长288小时,支持高质量训练与评估。

- 广泛应用:适用于影视制作、虚拟社交、智能座舱等多个领域,推动沉浸式体验技术发展。

缺点:

- 物理精度有限:相比基于物理建模的方案,AI生成音频的反射仿真仍有差距。

- 实时性待提升:当前推理延迟约200ms,尚未达到VR交互的毫秒级要求。

如何使用

- 访问项目主页:用户可通过OmniAudio项目主页了解技术详情。

- 获取代码与数据:代码和数据开源仓库位于GitHub,用户可下载并部署模型。

- 参考技术论文:论文地址为arXiv,提供详细的技术原理与实验结果。

框架技术原理

- 360V2SA任务框架:通过端到端深度学习,直接解析全景视频中的视觉场景与声源物理关系,动态映射声音的空间方位、距离及反射特性。

- 自监督coarse-to-fine预训练:利用大规模非空间音频资源,通过流匹配方法实现音频时序和结构的自监督学习,掌握通用音频特征和宏观时域规律。

- 双分支视频表示微调:结合全局特征和局部细节表征,高效微调条件流场,从噪声中“雕刻”出符合视觉指示的FOA潜在轨迹。

创新点

- 提出360V2SA任务:直接从360°视频生成空间音频,填补技术空白。

- 构建Sphere360数据集:解决训练数据稀缺问题,支持高质量模型训练与评估。

- 双阶段训练方法:通过自监督预训练和有监督微调,提升模型对空间特征的泛化能力与生成质量。

评估标准

- 非空间音频质量:采用Frechet Distance(FD)和Kullback-Leibler散度(KL)衡量生成音频和真实音频在OpenL3特征空间的分布差异和标签分布差异。

- 空间音频准确度:计算声源方向估计误差,包括绝对方位角误差、绝对仰角误差及综合角度误差。

- 主观评测:通过人工打分得到空间音频质量MOS-SQ和视音对齐保真度MOS-AF,评估生成音频的空间感、清晰度及画面与声音的同步度。

应用领域

- 影视制作:为VR电影自动生成沉浸式音效,提升观众体验。

- 虚拟社交:在元宇宙会议中还原参与者方位声像,增强社交互动的真实感。

- 智能座舱:结合车载摄像头实现事故现场声音重放,提升驾驶安全性。

- 游戏与娱乐:为游戏角色和场景生成精准的空间音频,提升沉浸感。

项目地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...