Seed GR-3 : 字节跳动推出通用机器人模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

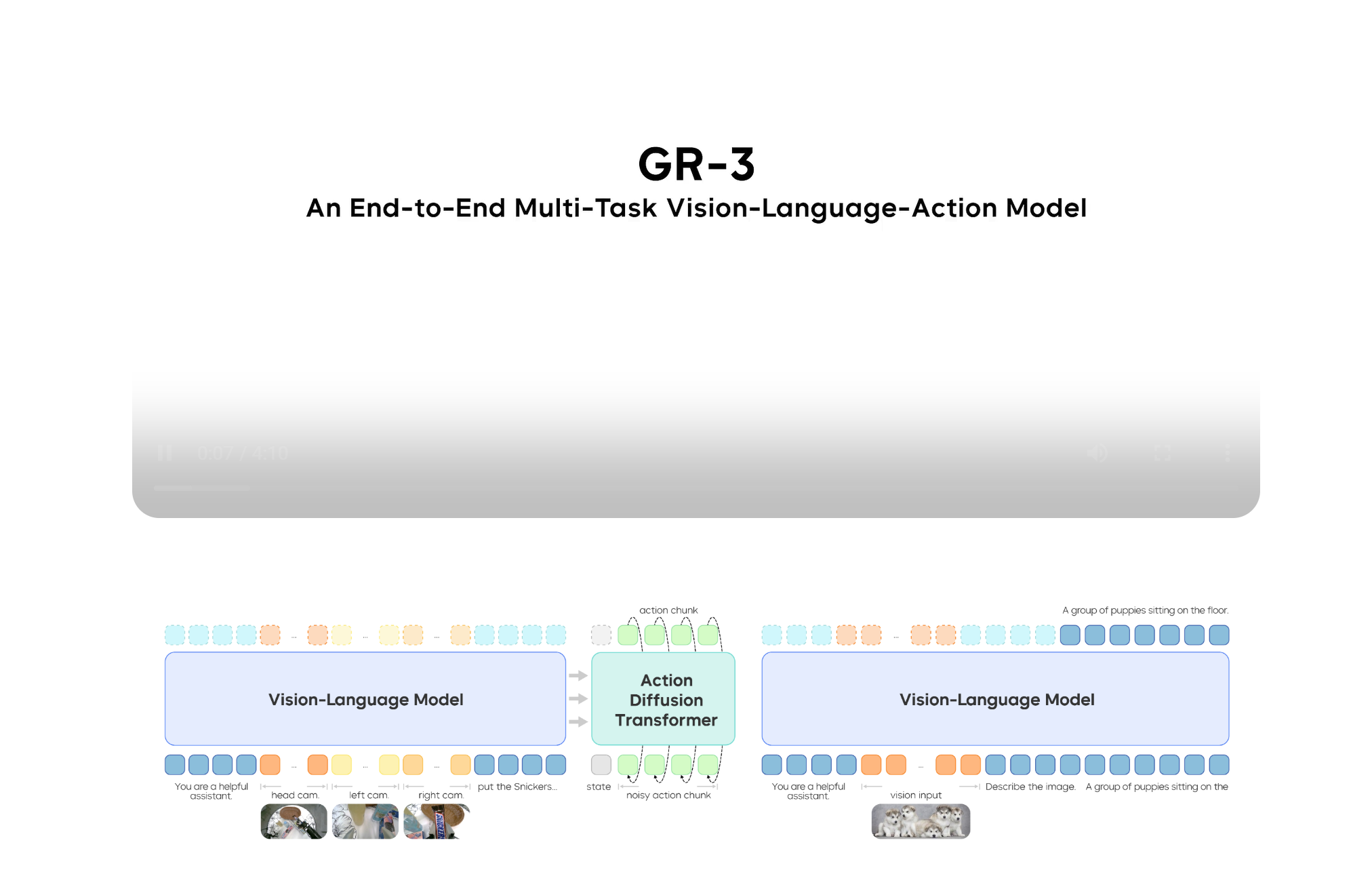

2025年7月22日,字节跳动Seed团队正式发布通用机器人模型GR-3,作为新一代视觉-语言-动作(VLA)架构模型,其核心目标是突破传统机器人“听不懂抽象指令”“不适应环境变化”“做不好长程任务”三大瓶颈,推动通用机器人“大脑”向日常场景落地。该模型通过端到端架构设计、多模态数据融合及高效微调技术,在泛化能力、操作精度和任务复杂度上实现显著突破,成为机器人学习领域的重要里程碑。

功能特点

- 抽象指令理解:GR-3能解析“收拾餐桌”“整理衣柜”等包含空间关系、抽象概念的指令,并自主规划多步骤动作。例如,在听到“收拾餐桌”后,可自动完成“打包剩菜→收拾餐具→倒垃圾”的全流程。

- 柔性物体操作:支持挂衣服、整理衣物等高灵巧度任务,双臂协同操作可形变物体,成功率达86.7%,即使面对短袖等未见过款式或混乱摆放状态仍能稳定完成。

- 长程任务处理:在超长序列任务(子任务数≥10)中,如餐桌清理、衣物整理,GR-3可严格遵循分步指令,面对无效指令(如“把不存在的蓝色碗放进篮子”)能准确判断并保持不动,任务完成度超95%。

- 高效泛化能力:仅需10条人类轨迹数据即可将新物体操作成功率从60%提升至80%以上,在未见过的物体抓取任务中成功率较基准模型提升17.8%,且在新环境(如卧室书桌、超市柜台)中性能几乎无衰减。

- 多模态感知与决策:通过2个手腕摄像头(捕捉细节)和1个头部摄像头(全局感知)实现“眼观六路”,结合归一化的RMSNorm设计,增强动态指令跟随能力。

优缺点

优点:

- 低成本迁移:通过少量人类数据(如VR轨迹、图文数据)即可微调至新任务,训练效率较传统模型提升近一倍(450条/小时 vs 250条/小时),显著降低数据采集成本。

- 高鲁棒性:在物体滑落、指令歧义等突发情况下,能通过模仿学习保持任务连续性,未来计划引入强化学习(RL)进一步增强抗干扰能力。

- 硬件协同优化:配套开发通用双臂移动机器人ByteMini,具备22个全身自由度及手腕球角设计,可在狭小空间(如衣柜、厨房抽屉)完成精细操作,硬件与模型深度适配。

缺点:

- 复杂场景依赖:在极端光照、遮挡等环境下,视觉感知性能可能下降,需结合多传感器融合技术优化。

- 强化学习待完善:当前模型仍以模仿学习为主,面对完全未知任务(如突发障碍物)时,自主决策能力有限,需扩大RL训练数据量。

如何使用

- 任务部署:用户可通过自然语言指令(如“把客厅的玩具收进箱子”)或分步指令(如“先拿杯子,再倒水”)启动GR-3,模型自动规划动作序列。

- 数据微调:针对新物体或环境,上传10-50条人类操作轨迹(如VR设备采集的挂衣服数据),GR-3可在1小时内完成微调,无需重新训练整个模型。

- 硬件集成:搭载GR-3的ByteMini机器人可通过API接口与智能家居系统联动,例如根据语音指令自动整理书桌或协助老人穿衣。

框架技术原理

GR-3采用Mixture-of-Transformers(MoT)网络结构,将视觉-语言模块与动作生成模块整合为40亿参数的端到端模型:

- 视觉编码:通过ViT(Vision Transformer)提取图像的像素级和语义级特征,结合VAE(变分自编码器)压缩视觉信息。

- 语言理解:利用BAGEL模型(字节跳动此前开源的70亿参数多模态模型)解析指令中的抽象概念(如“大”“小”“左右”)。

- 动作生成:采用Diffusion Transformer(DiT)结合Flow-Matching技术生成连续动作,归一化的RMSNorm设计确保动态指令跟随的稳定性。

- 数据融合训练:通过三合一数据训练法提升能力:

- 遥操作数据:收集机器人真实操作轨迹,确保基础动作精度;

- VR人类数据:用户授权采集人类操作轨迹,加速新任务学习;

- 图文数据:融合公开视觉语言数据,使模型理解抽象概念并识别未见过物体。

创新点

- 端到端架构:首次将视觉、语言、动作模块统一为40亿参数模型,消除传统VLA模型中模块间的信息损失,动作规划效率提升30%。

- 多样性数据融合:突破单一数据源局限,通过遥操作、VR、图文数据联合训练,使模型在未见物体抓取任务中成功率提升17.8%。

- 高效微调技术:仅需10条人类轨迹数据即可将新物体操作成功率从60%提升至80%以上,训练成本降低80%。

- 硬件-模型协同设计:ByteMini机器人的22自由度及手腕球角设计,与GR-3的灵巧操作能力深度适配,实现“大脑”与“躯体”的无缝协同。

评估标准

- 指令遵循率:在训练过的场景中达98.1%,新环境中几乎无衰减。

- 任务成功率:通用拾取放置任务成功率96.3%,长程餐桌清理任务完成度超95%,柔性衣物操作成功率86.7%。

- 泛化性能:在未见过的物体抓取任务中,成功率较基准模型提升17.8%;仅需10条人类轨迹数据即可将新物体操作成功率从60%提升至80%以上。

- 数据效率:新任务学习效率提升近一倍(450条/小时 vs 传统250条/小时),训练成本降低60%。

应用领域

- 家庭服务:自动整理房间、协助老人穿衣、准备餐食等。

- 物流仓储:在狭小货架间完成高精度分拣,支持柔性物体(如衣物、包装盒)操作。

- 医疗护理:辅助护士搬运器械、整理病房,或为残障人士提供日常起居支持。

- 工业制造:在复杂生产线中完成精密装配,适应产品迭代带来的环境变化。

项目地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...