Qwen3-Coder : 阿里通义千问推出的代码生成模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

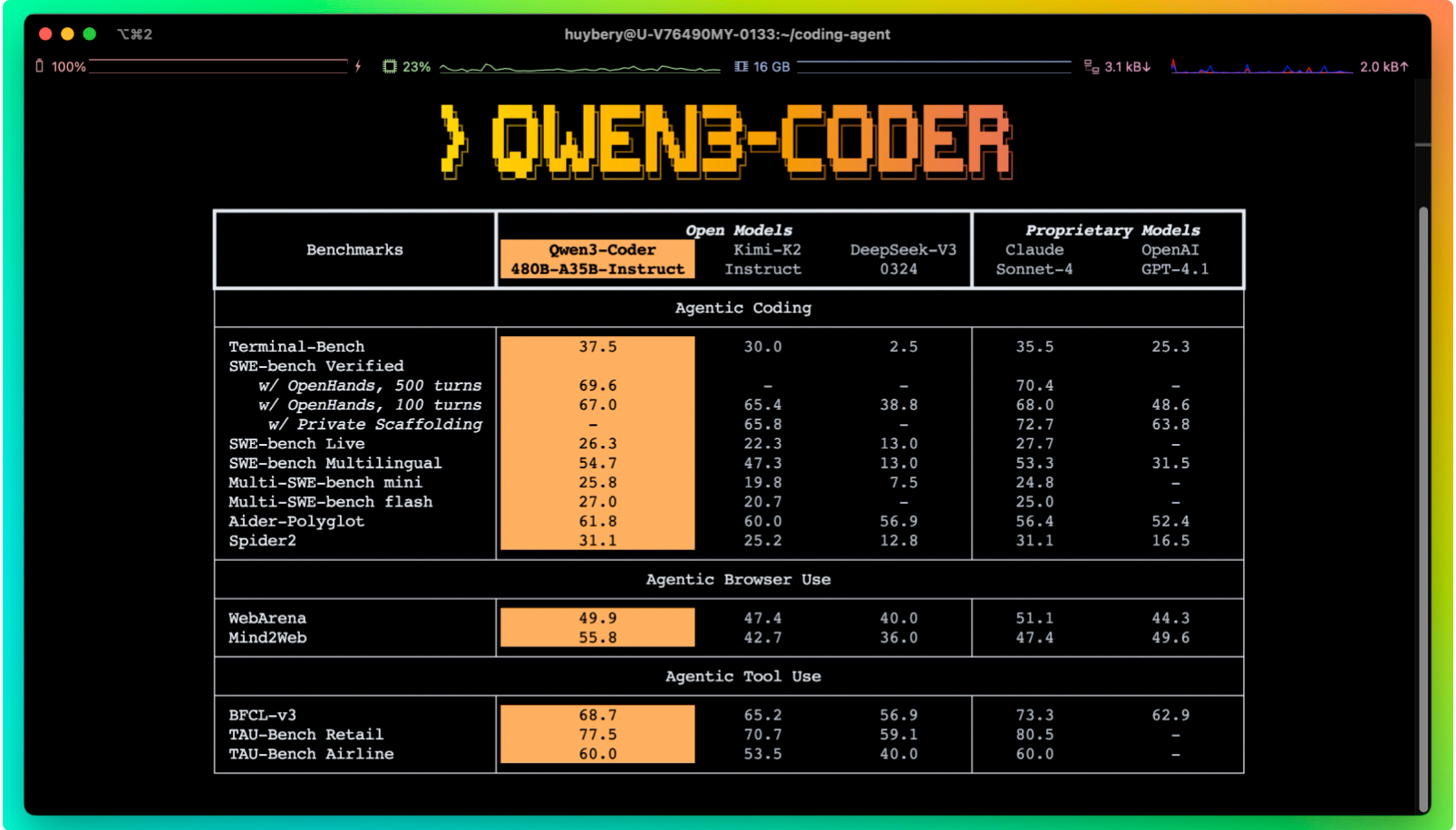

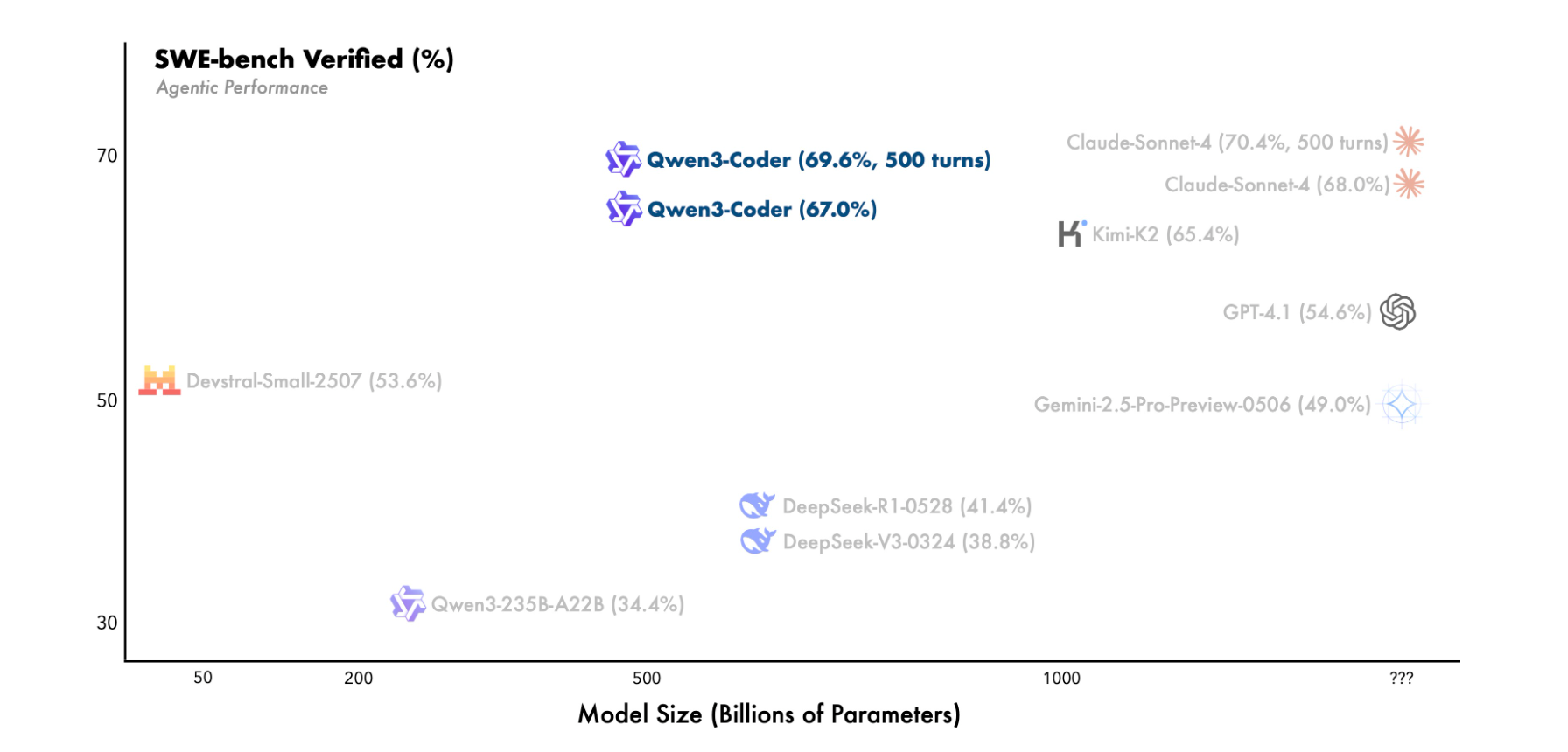

Qwen3-Coder是阿里通义千问团队推出的全球顶尖开源代码生成模型,于2025年7月23日正式发布。作为千问系列首个采用混合专家(MoE)架构的代码模型,其总参数达4800亿,激活参数350亿,原生支持256K上下文(可扩展至1M),在代码生成、智能体(Agent)任务和工具调用能力上达到开源模型巅峰,性能比肩全球最强商业模型Claude4,并超越GPT-4.1等闭源模型。该模型旨在降低编程门槛,提升开发效率,推动AI技术普惠化。

功能特点

- 超长上下文处理:原生支持256K上下文,可扩展至1M,轻松处理仓库级代码库或复杂动态数据。

- 多语言与格式支持:原生支持Python、JavaScript、Java、C++等主流语言,兼容Markdown、SVG、JSON等开发文档格式。

- Agent能力卓越:擅长解决多步骤长任务,能自主规划工作内容,调用外部工具(如API、数据库)完成复杂编程任务,工具调用数量是Claude的数倍。

- 高效代码生成:生成代码准确率高,基础编程任务效率提升10倍(如品牌官网生成时间从数天压缩至5分钟)。

- 可视化与物理模拟:支持通过自然语言指令生成SVG动画、物理引擎模拟(如小球弹跳、粒子运动),降低非专业开发者门槛。

优缺点

优点:

- 开源免费:全球开发者可免费下载商用,API价格仅为Claude4的1/3至1/2。

- 性能领先:在SWE-Bench等评测中刷新开源模型纪录,代码生成质量与商业模型持平。

- 生态兼容:支持HuggingFace、魔搭社区等平台,可与阿里云百炼、通义灵码等产品无缝集成。

缺点:

- 推理成本较高:旗舰模型需高端GPU(如A100)或32GB+内存,轻量级模型可在消费级显卡运行。

- 代码冗长:部分场景下输出代码存在“以勤补拙”现象,需进一步优化简洁性。

- 中英混合注释:注释语言不稳定,偶现不可见字符导致编译失败。

如何使用

- 访问平台:通过魔搭社区、HuggingFace或GitHub下载模型权重。

- 环境配置:安装PyTorch 1.12+、CUDA 11.4+,推荐使用SGLang或vLLM框架部署。

框架技术原理

- 混合专家架构(MoE):采用160个专家模块,每次激活8个,动态分配计算资源,平衡性能与效率。

- 预训练与强化学习:

- 预训练:在7.5T数据(代码占比70%)上训练,覆盖119种语言,利用Qwen2.5-Coder清洗低质量数据。

- 强化学习:通过Scaling Code RL生成多样化测试用例,提升代码执行成功率;引入Scaling Long-Horizon RL,在20,000个独立环境中模拟多轮交互,优化Agent能力。

创新点

- 超长上下文与Agent协同:1M上下文支持为Agent能力提供全局视角,实现复杂任务自主规划。

- 低成本高效微调:利用旗舰模型知识降低轻量级模型训练成本,确保性能竞争力。

- 工具调用数量突破:实测中工具调用数量是Claude的数倍,显著提升智能体应用效率。

评估标准

- 代码质量:在WebArena、BFCL、SWE-Bench等评测中,刷新开源模型纪录,准确率与商业模型持平。

- Agent能力:工具调用数量、任务完成率等指标达行业领先水平。

- 成本效益:API价格低于Claude4,性能与成本比优势显著。

应用领域

- 软件开发:代码生成、补全、Bug修复,提升程序员效率。

- 智能体应用:网页开发、AI搜索、深度研究等场景自动化。

- 教育与科普:非专业开发者通过自然语言生成3D物理模拟、复杂算法,降低编程门槛。

- 企业服务:一汽集团、中国石油等企业已接入,用于智能客服、自动化办公、数据分析等。

项目地址

- 项目官网:Qwen3-Coder官方页面

- GitHub仓库:Qwen3-Coder GitHub

- HuggingFace模型库:Qwen3-Coder HuggingFace

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...