StableAvatar : 复旦推出的音频驱动视频生成模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

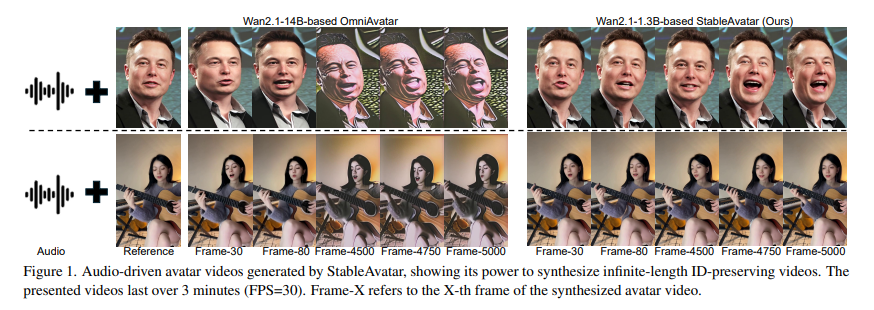

StableAvatar是由复旦大学联合微软亚洲研究院、西安交通大学及腾讯混元团队共同研发的突破性AI视频生成技术,于2025年8月首次提出。该模型是首个端到端的视频扩散Transformer,能够在无需后处理的情况下生成无限长度的高质量音频驱动视频,解决了以往技术在生成长视频时频繁出现的面部扭曲、身体变形、音画不同步等关键问题,推动了AI数字人技术在实际应用中的可用性与自然度。

功能特点

- 无限长度视频生成:StableAvatar能够生成数小时的连续视频,而不会出现明显质量下降问题。

- 高质量音画同步:通过时间步感知音频适配器(Timestep-Aware Audio Adapter)和音频原生引导机制(Audio Native Guidance),实现了口型与音频的精准对齐,以及头部微动作、表情的自然过渡。

- 身份一致性:在长视频生成过程中,能够保持角色的面部特征和风格一致,避免面部漂移。

- 多场景应用:支持单人说话、唱歌、直播、遮挡嘴部(带口罩)等多种场景,以及多人交互场景。

- 高效可部署:基于Wan2.1-1.3B模型实现,相比此前基于更大模型(如Wan2.1-14B)的方案,显存减少约50%,推理速度提升10倍。

优缺点

优点:

- 生成质量高:在面部质量、唇形同步和视频平滑度上显著优于现有方法。

- 无限长度生成:首次实现无需后处理的端到端长视频生成。

- 资源消耗低:模型参数量更小,适合实际部署场景。

缺点:

- 非人类生物限制:对于外观和结构与普通人类存在显著差异的非人类生物(如奇幻生物),难以定位嘴唇位置,无法实现唇形同步。

- 特定任务精度:在边缘检测等特定任务上,仍落后于专用模型。

如何使用

- 选择镜像:在GPU实例界面中选择创建实例,并在镜像市场搜索StableAvatar镜像。

- 应用服务:实例运行后,等待两到三分钟,点击应用服务按钮。

- 选择模式:有StableAvatar、音频提取、人声分离三种模式可供选取,选择StableAvatar模式。

- 上传素材:选择相应语言和模型,上传图片和音频文件。

- 调整参数:根据需要调整提示词和参数。

- 开始生成:点击开始生成按钮,实现一张图、一段音频生成数字人视频。

框架技术原理

- 时间步感知音频适配器:将音频嵌入通过多个仿射调制和交叉注意力模块与时间步嵌入和潜在特征进行交互,减少潜在分布误差累积。

- 音频原生引导机制:替代传统的分类自由引导(CFG),通过联合音频-潜在分布引导生成过程,增强音频同步。

- 动态加权滑动窗口策略:在时间维度上融合潜变量,提升长视频生成过程中的视频平滑性。

- 视频扩散Transformer架构:支持高质量、长时间序列的视频生成。

创新点

- 端到端无限长度生成:首次实现无需后处理的端到端长视频生成。

- 时间步感知调制:在音频适配器中引入时间信息,提升跨帧一致性。

- 音频-潜在联合建模:通过音频原生引导机制,直接作用于扩散模型的采样分布,强化音频与潜变量之间的相关性。

- 动态加权滑动窗口:在相邻窗口的重叠潜变量上引入滑动融合机制,实现跨视频片段的无缝衔接。

评估标准

- 视频质量:使用FID、FVD、IQA等指标评估视频的保真度和质量。

- 唇形同步性:使用Sync-C、Sync-D等指标评估口型与音频的同步程度。

- 身份一致性:通过CSIM等指标评估角色在长视频中的面部特征和风格一致性。

- 人工评估:从结构完整性、指令遵循和审美质量三个维度进行主观评估。

应用领域

- 影视制作与广告:快速生成虚拟角色讲解视频,大幅减少后期配音与演员拍摄成本。

- 虚拟助手与交互代理:打造高度拟人化的数字员工,提升用户体验。

- 在线教育与企业培训:教师或讲师仅需提供录音即可生成授课视频,支持多语言、多风格输出。

- 社交媒体与内容创作:用户可通过一张自拍和一段语音生成个性化视频内容,极大丰富创作形式。

项目地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...