DeepSeek-V3.2 : DeepSeek开源的AI模型Exp实验性版本

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

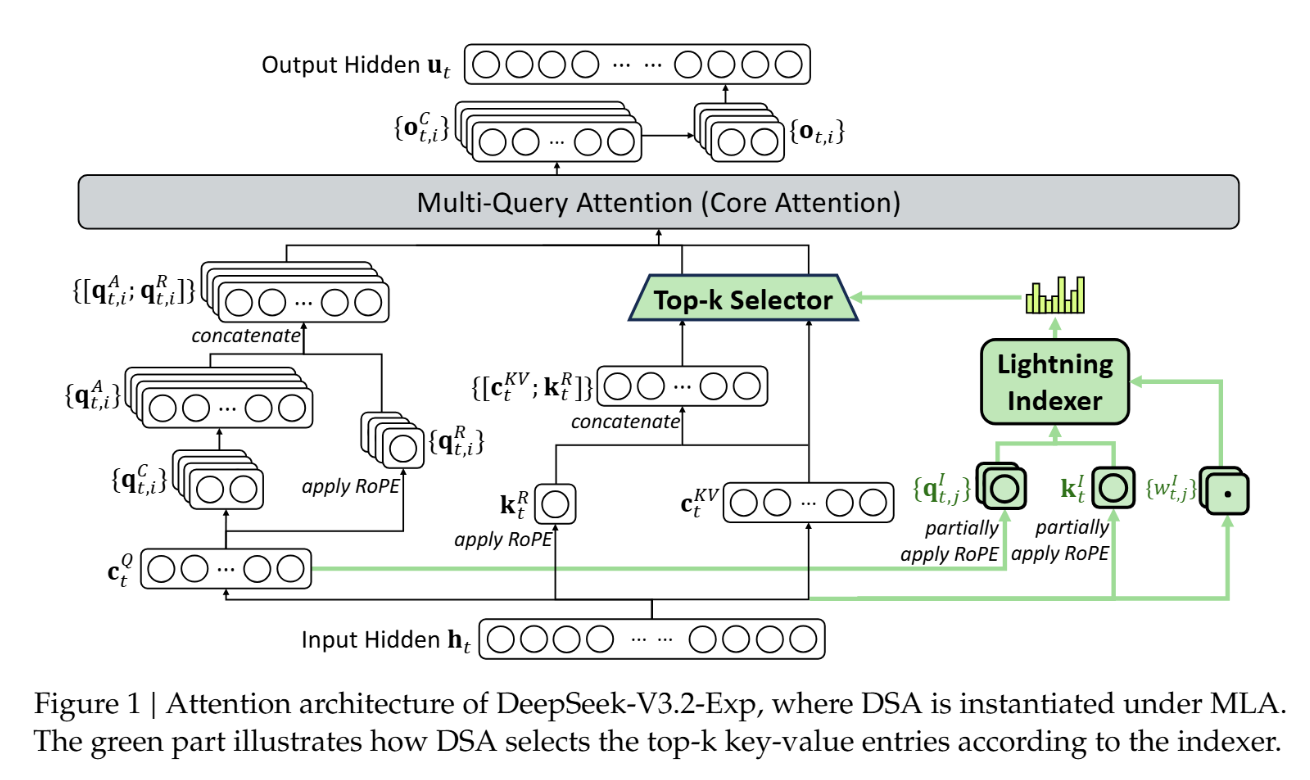

DeepSeek-V3.2-Exp是DeepSeek于2025年9月29日发布的实验性AI模型版本,作为迈向新一代架构的中间探索步骤,该模型在V3.1-Terminus基础上首次引入DeepSeek Sparse Attention(DSA)稀疏注意力机制,重点优化长文本场景下的训练与推理效率。其核心目标是通过细粒度注意力分配降低计算复杂度,同时保持模型输出质量稳定。实验结果显示,在128K长上下文处理中,DSA机制使推理效率显著提升,而模型性能与前代基本持平。目前,V3.2-Exp已全面开源,支持学术研究与商业应用,并同步推出API服务价格下调超50%的优惠政策。

功能特点

- 长文本处理效率优化:DSA机制将注意力计算复杂度从O(L²)降至O(Lk),支持最长128K上下文,推理速度提升且显存占用降低。

- 性能稳定性:在MMLU-Pro、Codeforces、AIME2025等基准测试中,模型得分与V3.1-Terminus基本持平,部分任务(如数学推理)略有提升。

- 低成本API服务:输入价格降至每百万tokens 0.2元(缓存命中)/2元(缓存未命中),输出价格降至3元,降幅超50%。

- 多平台适配:支持华为昇腾、寒武纪、海光DCU等国产硬件,以及vLLM/SGLang等推理框架,华为云最大支持160K上下文。

- 开源生态:模型权重与代码在Hugging Face和ModelScope平台开源,配套技术论文及GPU算子(TileLang/CUDA版本)同步公开。

优缺点

- 优点:

- 长文本处理效率显著提升,成本大幅降低。

- 性能与前代持平,稳定性经公开评测验证。

- 硬件适配广泛,支持国产AI生态。

- 缺点:

- 实验性版本,需更大规模用户测试以排除场景化缺陷。

- 稀疏注意力机制可能导致部分任务(如复杂编程)输出简短,牺牲一定准确性。

- 工作记忆与计算精度稳定性存在短板,偶发死循环问题。

如何使用

- 官方渠道体验:通过DeepSeek官方App、网页端或小程序直接使用模型服务。

- API调用:开发者可通过DeepSeek API接入模型,享受降价后的低成本服务(输入/输出价格详见官方文档)。

- 本地部署:在Hugging Face或ModelScope下载模型权重,通过vLLM/SGLang等框架在支持硬件上部署。

- 对比测试:官方保留V3.1-Terminus API接口至2025年10月15日,用户可同步测试两版本性能差异。

框架技术原理

- DeepSeek Sparse Attention(DSA):

- Lightning Indexer:动态计算查询token与历史token的关联分数,采用FP8混合精度训练,参数可训练。

- Top-k Selector:基于分数选择top-k个token进行注意力计算(k=2048),将复杂度从O(L²)降至O(Lk)。

- 训练流程:

- 继续预训练:分两阶段优化,先冻结主模型训练索引器,再放开参数进行稀疏训练。

- 后训练:采用专家蒸馏(领域专用模型生成数据)与混合强化学习(GRPO算法),统一推理、代理与对齐训练。

- 硬件优化:开源TileLang(研究原型)与CUDA(生产)版本算子,支持昇腾、寒武纪等国产芯片的高效计算。

创新点

- 细粒度稀疏注意力:首次实现单token维度筛选,突破传统块级稀疏的粒度限制。

- 长文本效率突破:在128K上下文处理中,推理速度提升且成本降低,同时维持语义连贯性。

- 软硬件协同优化:与华为昇腾、寒武纪等厂商合作,实现“Day 0”适配与算子开源。

- 低成本普惠战略:API价格降幅超50%,推动AI技术商业化落地。

评估标准

- 长文本处理效率:128K上下文下的推理速度与显存占用。

- 模型性能:MMLU-Pro、Codeforces、AIME2025等基准测试得分。

- 成本效益:API调用价格与同类模型对比。

- 硬件适配性:支持国产芯片与主流推理框架的兼容性。

- 稳定性:工作记忆、计算精度与死循环问题的发生率。

应用领域

- 长文档处理:法律合同分析、科研论文综述、多轮对话管理。

- 代码生成与调试:支持复杂项目开发中的上下文理解与代码补全。

- 金融风控:实时分析长文本报告,识别潜在风险。

- 教育领域:辅助长文本学习材料生成与问题解答。

- 企业AI:降低长任务处理成本,提升运营效率。

项目地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...