Lynx : 字节跳动推出的高保真个性化视频生成模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

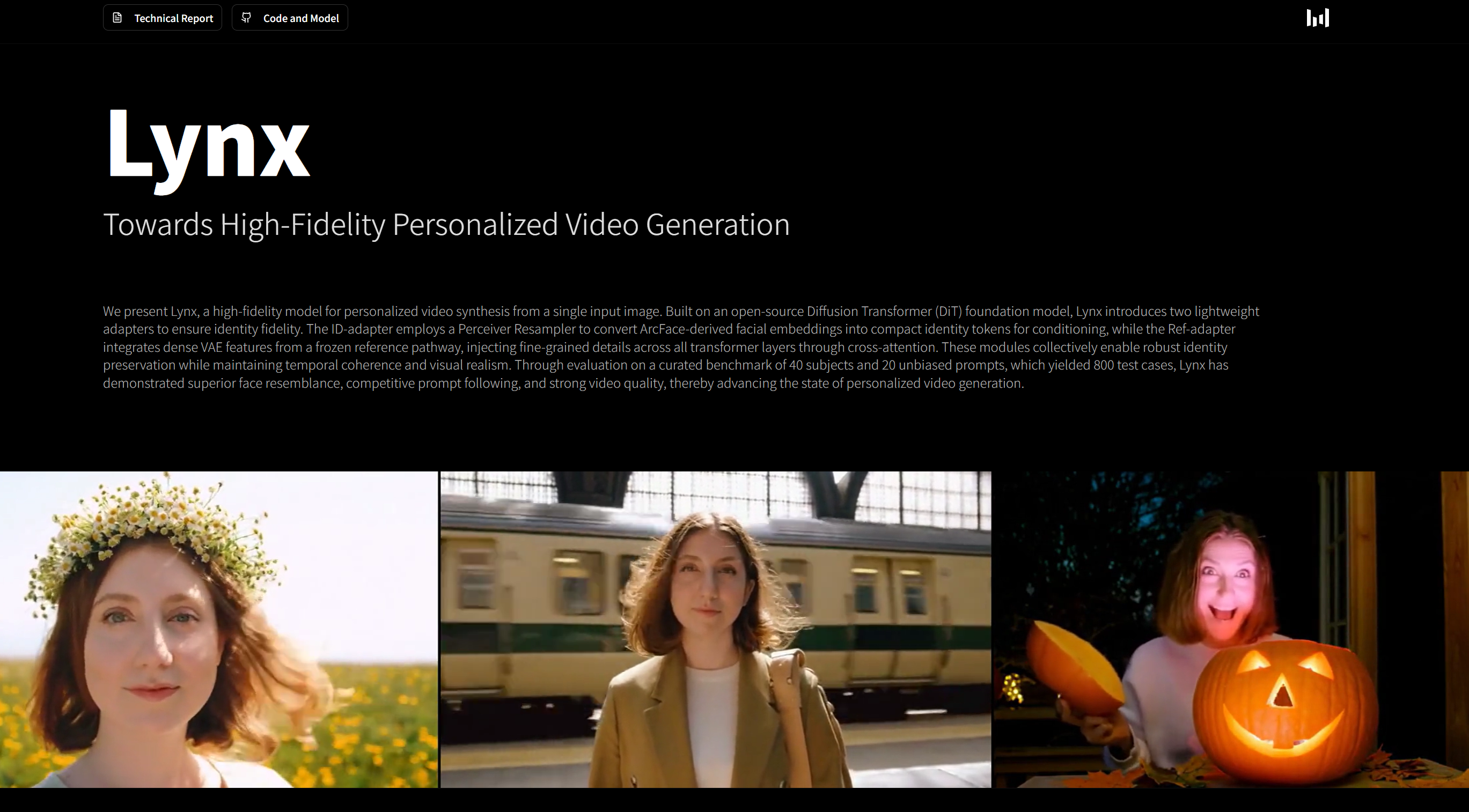

Lynx是字节跳动于2025年9月推出的高保真个性化视频生成模型,基于开源扩散Transformer(DiT)架构开发。该模型通过单张人物图像即可生成身份一致、动作自然、场景多样的动态视频,在身份保真度、动作连贯性、视觉真实感方面达到行业领先水平。其核心目标是通过轻量级适配器设计,解决传统视频生成模型中身份信息丢失、场景适应性差等问题,推动个性化视频生成技术的实用化。

功能特点

- 单图生成视频:仅需一张人物照片,即可生成包含指定动作、场景的高清视频(如“在厨房吃饺子”)。

- 身份高保真:通过双适配器架构(ID-adapter+Ref-adapter)精准提取面部特征,确保生成视频中人物身份一致。

- 场景自适应:支持多样化场景(如霓虹灯下、太空舱内)和表情变化(喜怒哀乐),同时保持身份特征稳定。

- 动作自然连贯:采用3D VAE架构理解动作物理规律,避免生成视频中出现不合理动作(如筷子反向夹饺子)。

- 数据增强策略:通过表情增强(X-Nemo技术)和肖像重光照(LBM算法)提升模型鲁棒性,适应极端光照条件。

优缺点

- 优点:

- 生成视频质量高,身份相似度、提示词遵循度、动作自然度均优于同类模型。

- 无需复杂设备或专业技能,降低视频创作门槛。

- 支持商业应用(如广告定制、电商虚拟试穿)。

- 缺点:

- 极端动作或复杂交互场景下,生成效果可能受限。

- 对输入图像质量要求较高,低分辨率或遮挡图像可能影响结果。

如何使用

- 官方渠道体验:通过字节跳动旗下App(如豆包、即梦AI)或项目官网直接使用。

- 输入要求:上传一张清晰人物照片,输入文字描述(如“在雨中打伞”),模型自动生成视频。

- 场景定制:支持选择不同场景(厨房、太空舱)、光照条件(阳光、阴影)和表情(微笑、惊讶)。

- 商业应用:企业用户可通过API接入,快速生成个性化广告或虚拟讲师视频。

框架技术原理

- 基础架构:以Wan2.1 DiT模型为核心,通过时空自注意力机制联合建模空间细节与时间动态。

- 双适配器设计:

- ID-adapter:利用ArcFace提取面部嵌入,通过Perceiver Resampler转换为身份令牌,注入Transformer跨注意力层。

- Ref-adapter:通过冻结参考路径的VAE编码器获取密集特征,跨层注入细粒度细节(如皮肤纹理、阴影)。

- 训练策略:

- 渐进式训练:先在图像数据上训练,再扩展至视频数据。

- 时空帧打包:将不同分辨率、时长的视频/图像打包为统一序列,通过注意力掩码区分样本。

- 对抗训练:采用生成器-判别器-身份判别器三重机制,优化视频真实感与身份一致性。

创新点

- 适配器式DiT架构:首次在视频生成领域引入轻量级适配器,无需微调整模型即可实现身份保真。

- 细粒度特征注入:通过交叉注意力机制在所有Transformer层注入身份与细节特征,提升生成质量。

- 多维度数据增强:结合表情增强和肖像重光照技术,增强模型对极端条件的适应性。

- 3D时间感知:采用3D VAE架构理解动作物理规律,提升时间连贯性。

评估标准

- 身份相似度:通过专家人脸识别模型评估生成视频与原始图像的面部匹配度。

- 提示词遵循度:基于Gemini-2.5-Pro API自动化评估视频对文字描述的遵循能力。

- 视频质量:从美学质量、运动自然度、整体真实感等维度打分。

- 泛化能力:在包含40个主体、20种场景的测试集(共800个案例)中验证模型适应性。

应用领域

- 数字人/虚拟偶像:生成虚拟主播、客服的动态视频,提升交互体验。

- 短视频/社交媒体:用户输入照片和描述,快速生成个性化短片。

- 广告/营销:定制品牌人物广告,保持形象统一性。

- 影视制作:生成角色演绎镜头、动画片段,减少拍摄成本。

- 教育/培训:创建虚拟讲师视频,增强教学吸引力。

项目地址

- 项目官网:https://byteaigc.github.io/Lynx/

- GitHub仓库:https://github.com/bytedance/lynx

- HuggingFace模型库:https://huggingface.co/ByteDance/lynx

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...