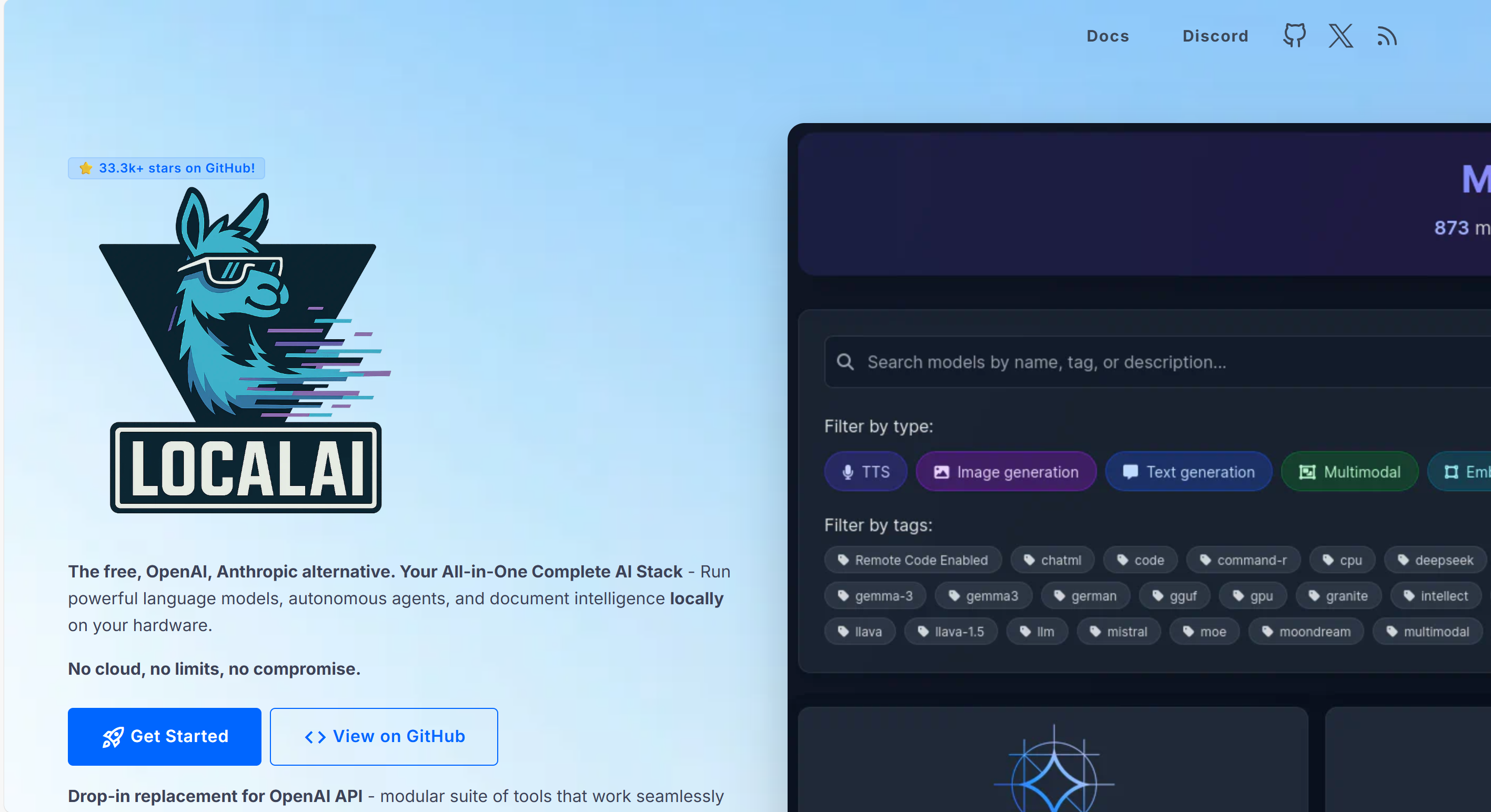

LocalAI : 开源的本地AI推理框架,支持多模态模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

LocalAI 是一个开源的本地化AI推理框架,专为在消费级硬件上运行多模态模型而设计。其核心目标是通过本地化部署,降低AI技术门槛,解决数据隐私泄露风险与云端API调用成本高的问题。该框架支持文本生成、图像生成、语音处理(如语音转文字、文字转语音)等任务,兼容OpenAI API规范,允许开发者无缝迁移现有应用。LocalAI 支持CPU和GPU运行,无需依赖高端硬件,尤其适合资源受限环境下的AI应用开发。

功能特点

- 多模态支持:涵盖文本生成(LLM模型)、图像生成(Stable Diffusion)、语音处理(Whisper)等。

- 硬件兼容性:支持CPU推理,同时兼容NVIDIA、AMD、Intel GPU加速。

- 模型灵活性:支持量化模型(如4-bit/8-bit量化),降低内存占用,提升推理速度。

- 本地化部署:所有数据处理在本地完成,确保数据隐私安全,支持离线运行。

- OpenAI兼容接口:提供与OpenAI一致的REST API,简化迁移流程。

- 分布式推理:支持P2P网络,允许多设备协同处理任务,提升计算效率。

- WebUI与工具集成:提供可视化界面管理模型,支持函数调用与外部服务嵌入。

优缺点

- 优点:

- 隐私保护:数据本地处理,避免敏感信息上传云端。

- 成本低廉:无需支付云端API费用,适合高频调用场景。

- 硬件友好:可在普通消费级设备上运行,降低部署门槛。

- 开源生态:代码公开,支持自定义训练与模型微调。

- 缺点:

- 性能限制:在复杂任务或大规模模型上,推理速度可能弱于云端服务。

- 社区成熟度:相比OpenAI等成熟平台,社区支持与生态系统仍需完善。

框架技术原理

LocalAI采用模块化设计,核心组件包括:

- API兼容层:实现OpenAI API规范,确保现有应用无缝迁移。

- 模型加载器:支持多种格式(GGML、GGUF、GPTQ)和来源(本地文件、HuggingFace仓库)。

- 推理引擎:针对不同模型类型优化后端(如llama.cpp、whisper.cpp、Stable Diffusion),支持量化与KV缓存加速。

- 资源管理器:动态分配CPU/GPU资源,支持多任务并行处理。

- 分布式模块:通过P2P网络拆分计算任务,利用libp2p协议保障通信安全。

创新点

- 本地化多模态支持:首次在单一框架中集成文本、图像、语音处理能力,且完全本地运行。

- 硬件优化技术:通过量化模型与KV缓存,显著降低内存占用,提升消费级硬件推理效率。

- 分布式推理架构:去中心化设计,动态调度任务至负载较轻节点,提高集群容错性。

- 开源生态整合:提供预训练模型库、示例代码与活跃社区,降低开发门槛。

评估标准

- 功能完整性:是否覆盖多模态任务(如文本生成、图像生成、语音处理)。

- 性能指标:推理速度、资源占用(内存/CPU/GPU利用率)、模型加载时间。

- 易用性:安装部署复杂度、API兼容性、文档与社区支持。

- 隐私与安全:数据本地化处理能力、通信加密机制。

- 扩展性:对新型模型与硬件的支持能力。

应用领域

- 企业内网:搭建私有AI助手,处理敏感文档、代码审查、知识问答。

- 个人开发:作为本地编程助手,减少网络延迟,提升开发效率。

- 离线场景:支持无网络环境下的科研、编程与内容创作。

- 边缘计算:在资源受限设备(如机器人、IoT设备)上部署轻量级模型。

- 创意产业:本地生成文本、图像、音频,用于市场营销、多媒体制作。

项目地址

- GitHub仓库:https://github.com/mudler/LocalAI

- 官网:https://localai.io/

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...