Alpamayo-R1:英伟达推出的推理版视觉-语言-动作模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

Alpamayo-R1是英伟达在2025年NeurIPS人工智能大会上发布的全球首款专为L4级自动驾驶设计的开源推理型视觉-语言-动作模型(VLA)。该模型基于Cosmos-Reason推理架构升级,首次实现视觉感知、语言理解与动作决策的端到端融合,支持同时处理摄像头数据、激光雷达点云及人类语言指令,通过内部逻辑推演生成驾驶决策。其核心目标是为自动驾驶系统注入“人类常识”,显著提升复杂场景下的决策能力,推动L4级自动驾驶技术落地。

功能特点

- 多模态统一处理:支持视觉(摄像头/激光雷达)、语言(导航指令/交通标识)和动作(加速/转向/制动)的端到端训练,避免传统分模块设计中的误差累积。

- 因果链推理能力:通过Cosmos思维链技术,模型可对复杂场景进行多步骤推演。例如,检测到前车急刹时,同步分析周边车辆动向、行人位置及道路标志,最终输出综合决策。

- 实时轨迹生成:采用基于单车模型动力学的控制表示,预测未来加速度和曲率序列,确保轨迹的实时性与物理可行性。

- 模块化架构:支持灵活替换视觉编码器与轨迹解码器,兼容不同硬件需求。

优缺点

优点:

- 决策可靠性高:通过因果推理显著提升长尾场景(如道路施工、异常车辆行为)的应对能力,闭环仿真中越野率降低35%,近距离碰撞率降低25%。

- 泛化能力强:减少对高精度地图的依赖,适应动态环境变化。

- 开源生态支持:提供完整开发工具包(Cosmos Cookbook),包含分步指南、推理工具及训练后工作流,降低开发者门槛。

缺点:

- 计算资源需求高:模型参数从0.5亿扩展至70亿时性能持续提升,但大规模部署需强大算力支持。

- 商业化验证待完善:需通过功能安全认证并满足车规级实时性要求,目前仍处于技术验证阶段。

如何使用

- 获取模型与工具包:从GitHub或Hugging Face平台下载Alpamayo-R1模型权重及Cosmos Cookbook开发资源包。

- 数据准备:输入多摄像头图像、车辆历史运动状态及可选的用户指令或导航信息,转换为统一的多模态token序列。

- 推理与决策:通过Cosmos-Reason骨干网络生成因果链推理文本和离散轨迹token,再由动作专家解码器转换为连续轨迹。

- 微调与优化:利用监督微调(SFT)和强化学习(RL)提升推理质量,确保推理与动作一致性。

框架技术原理

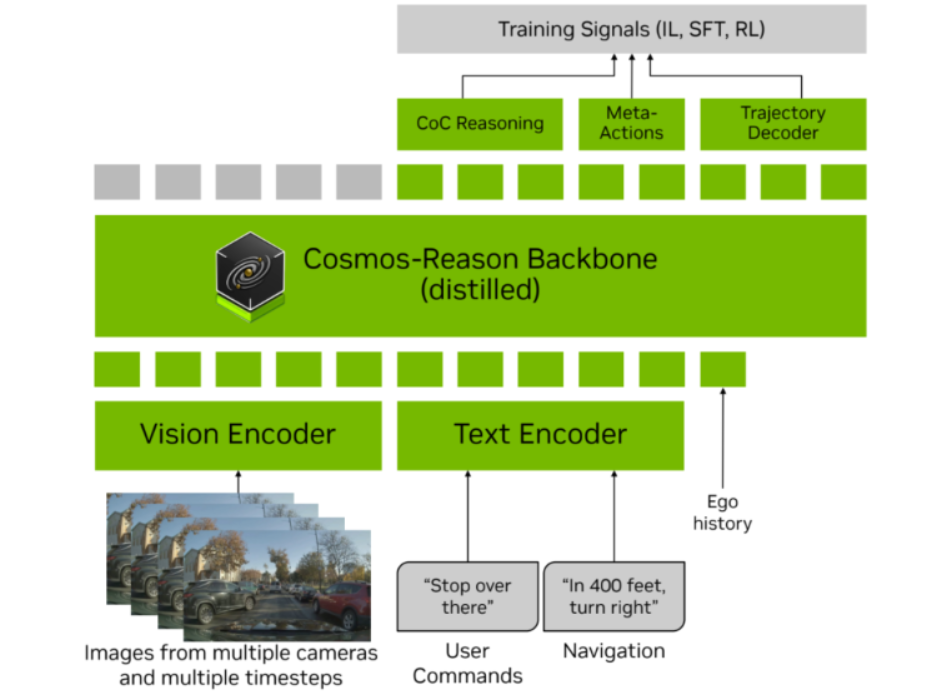

Alpamayo-R1采用“感知-推理-决策”分层架构:

- 视觉编码:支持多摄像头编码器(如三平面编码)或视频编码器(如Flex),实现高效token化。

- 推理核心:基于Cosmos-Reason模型,通过自回归生成结构化因果推理文本(如“因行人横穿,需减速”)。

- 轨迹解码:采用流匹配框架将离散轨迹token解码为连续控制量(加速度、曲率),确保物理可行性。

- 训练策略:结合监督微调(激发推理能力)和强化学习(优化推理质量与一致性),形成多阶段训练闭环。

创新点

- 因果链数据集(CoC):通过“自动标注+人机协同”构建,生成与驾驶行为对齐、以决策为核心的因果推理轨迹,解决传统数据集行为描述模糊、推理肤浅的问题。

- 模块化VLA架构:整合Cosmos-Reason与基于扩散的轨迹解码器,实现高层推理与底层控制的高效协同。

- 双重轨迹表示:训练阶段采用离散token学习,推理阶段通过动作专家解码为连续轨迹,兼顾训练效率与实时性能。

评估标准

- 规划精度:在复杂场景(如无保护左转、突发障碍物)中的轨迹预测准确率。

- 安全性指标:闭环仿真中的越野率、近距离碰撞率及脱离道路行驶概率。

- 推理质量:通过大型推理模型评估器测量推理链的合理性与一致性。

- 实时性能:端到端延迟(如99毫秒)及车载部署的稳定性。

应用领域

- L4级自动驾驶:支持Robotaxi、无人配送车等限定区域自动驾驶场景。

- 高级驾驶辅助系统(ADAS):提升现有系统的场景理解与决策能力。

- 智能交通研究:为学术机构提供开源基准模型,推动自动驾驶技术边界拓展。

项目地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...