DLCM : 字节跳动推出的动态大概念模型框架

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

DLCM(Dynamic Large Concept Models)是字节跳动Seed团队提出的动态大概念模型框架,旨在解决传统大语言模型(LLM)在长文本推理中因均匀处理Token(词)导致的计算冗余问题。该模型通过将推理单位从Token升级为Concept(概念),实现动态语义分割与自适应算力分配,在保持高准确率的同时显著降低计算成本。2026年1月,字节跳动正式发布DLCM架构,相关论文同步开源,标志着推理技术向更高层次语义理解迈进。

功能特点

- 动态语义分割:基于Token级表示,通过计算相邻Token的局部不相似性(余弦距离)动态划分概念边界,实现内容自适应分割。

- 高效推理:在压缩后的概念空间中进行深度推理,减少冗余计算,推理阶段FLOPs降低34%。

- 准确率提升:通过概念级推理优化,平均准确率提升2.69%,尤其在多步逻辑推理任务中表现突出。

- 自适应算力分配:根据信息密度动态分配计算资源,例如对冗余代码或简单文本激进压缩,对复杂语义转折点保持低压缩比。

优缺点

优点:

- 计算效率高:通过动态概念分割与压缩,显著减少无效计算,推理成本降低超30%。

- 语义理解强:在长文本、复杂逻辑推理任务中表现优异,准确率超越传统LLM基线模型。

- 工程优化完善:引入全局解析器(GlobalParser)、概念复制策略(Concept Replication)等技术,解决动态掩码、内存访问等工程挑战。

缺点:

- 训练门槛高:需依赖大规模数据与复杂训练技术栈,普通开发者可能面临环境配置挑战。

- 架构复杂度高:Token级与概念级模块的异构设计需解耦最大更新参数化,训练稳定性要求较高。

如何使用

- 在线体验:通过字节跳动或合作平台提供的Demo工具,上传文本或输入任务指令,模型将自动返回概念级推理结果(如文本摘要、逻辑分析)。

- 本地轻量部署:

- 下载预训练模型与推理脚本(需支持GPU环境)。

- 使用命令行工具调用模型API

- 输出结果包含概念分割、推理过程及最终结论。

- 集成到现有系统:通过字节跳动提供的SDK或API服务,将DLCM嵌入到业务流程中(如智能客服、文档分析)。

框架技术原理

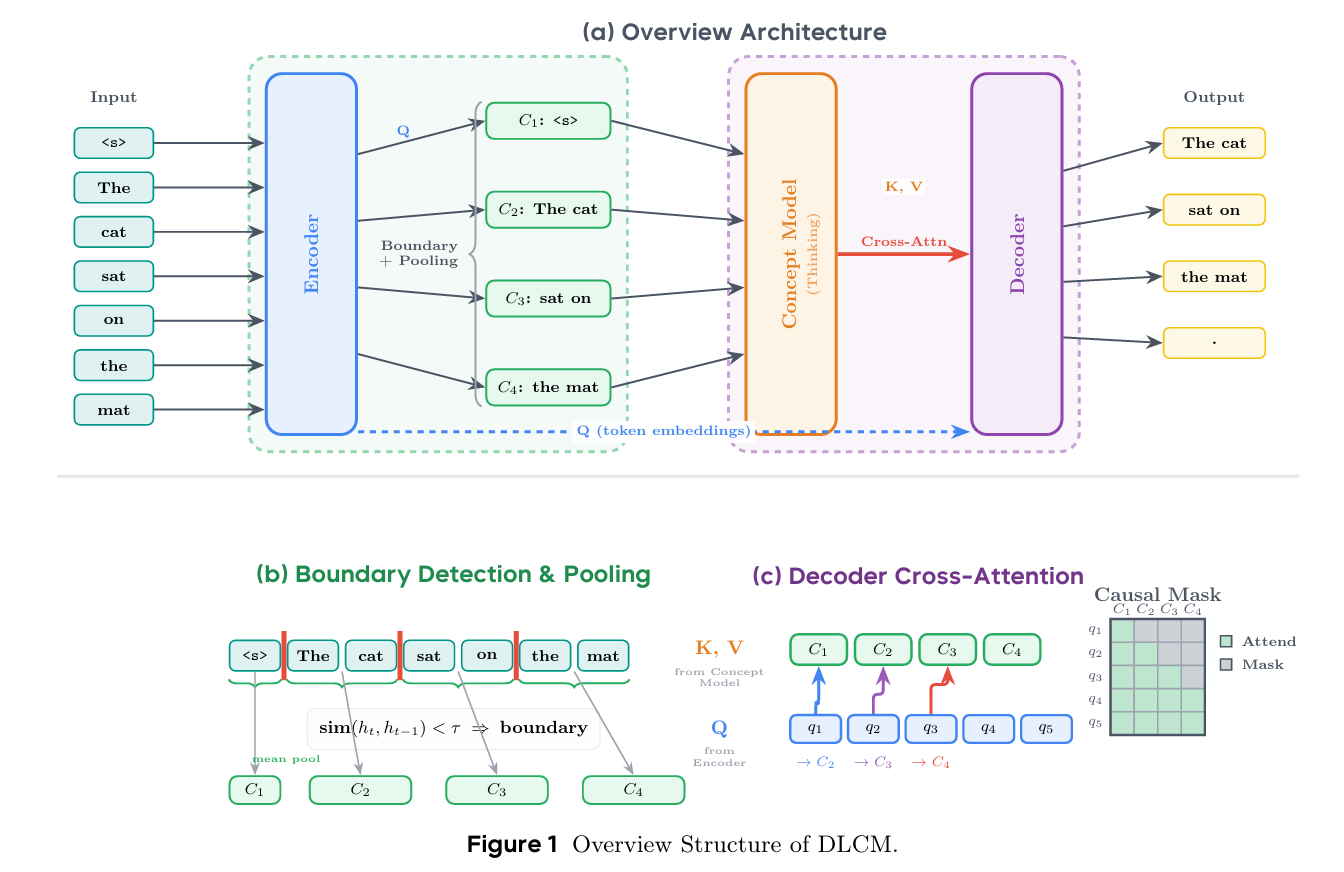

DLCM采用分层下一Token预测框架,核心流程分为四阶段:

- 编码阶段:通过编码器提取Token级细粒度表示,捕获局部上下文信息。

- 动态分割阶段:计算相邻Token的局部不相似性,当阈值超过设定值时判定为语义断点,形成概念边界。

- 概念级推理阶段:在压缩后的概念空间中进行深度推理,整合信息并生成概念表示。

- Token级解码阶段:利用推理后的概念表示重构并预测下一个Token,完成输出。

创新点

- 动态Token-概念映射:首次将推理单位从Token升级为概念,实现计算资源的自适应分配。

- 全局解析器(GlobalParser):通过Batch层面约束平均边界生成率,实现内容自适应压缩,精准分配算力至语义关键区域。

- 概念复制策略:将可变长交叉注意力问题转换为长度对齐的局部恒定注意力问题,利用Flash Attention优化推理效率,加速1.26-1.73倍。

- 解耦最大更新参数化:为Token模块与概念模块分配独立宽度缩放因子,稳定不等宽架构训练,支持零样本超参数迁移。

评估标准

- 定量指标:在BrowseComp、DocVQA等基准测试中,推理阶段FLOPs降低34%,平均准确率提升2.69%。

- 定性分析:通过复杂逻辑推理、长文本理解等任务验证模型鲁棒性。

- 效率对比:在相同推理成本下,DLCM性能显著优于传统LLM基线模型。

应用领域

- 自然语言处理:文本生成、机器翻译、问答系统,提升生成内容的连贯性与翻译准确性。

- 金融分析:预测市场趋势、评估投资风险、生成决策报告。

- 医疗健康:分析病历数据、预测疾病传播路径、辅助临床决策。

- 教育领域:个性化学习建议、智能辅导、作文评分与编程作业反馈。

项目地址

- 论文与代码:

- arXiv技术报告:https://arxiv.org/abs/2512.24617

- GitHub开源仓库:https://github.com/test-time-training/e2e

- 在线Demo:字节跳动官方平台或合作云服务(如昇腾社区)。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...