DCLM-7B ——苹果公司与合作团队推出的开源小模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

DCLM-7B 的主要介绍

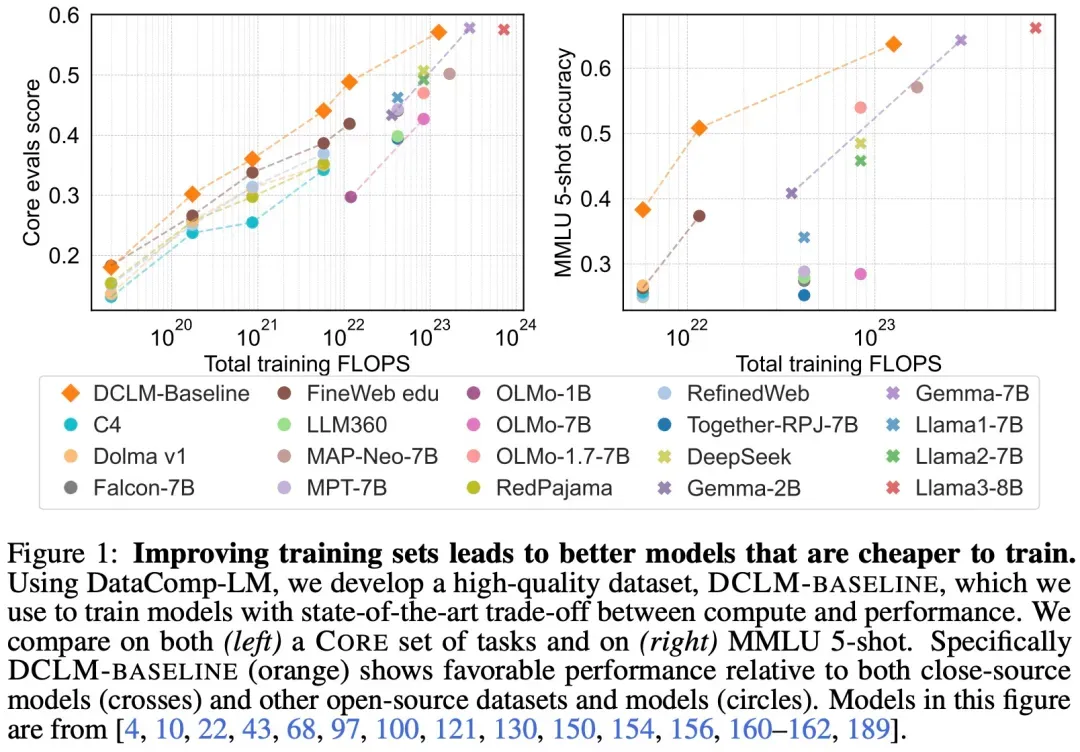

DCLM-7B是苹果公司作为DataComp-LM(DCLM)项目研究机构之一,在Hugging Face上发布的开源模型。该模型包含70亿和14亿两种参数规模,其中最大70亿参数的版本在性能上超越了Mistral-7B,并接近Llama 3和Gemma等大型模型。DCLM-7B不仅开源了模型权重,还开源了训练代码和预训练数据集,被视为“真正开源的最佳模型”。它的发布标志着苹果在AI领域的又一重要贡献,为全球AI研究者和开发者提供了宝贵资源。

DCLM-7B 的功能特点

- 高性能:在多项基准测试中表现出色,如MMLU基准上的5-shot准确率达64%,接近大型模型如Llama 3 8B。

- 高效能:在处理语言任务时,由于采用了先进的架构设计和优化,模型表现更加高效和准确。

- 开源性:不仅开源了模型权重,还提供了训练代码和预训练数据集,促进了AI技术的开放共享。

DCLM-7B 的优缺点

- 优点:

- 高性能:在保持较小参数规模的同时,实现了接近大型模型的性能。

- 高效能:优化了模型架构和训练过程,提高了处理效率。

- 开源性:提供了完整的开源资源,降低了AI研究和开发的门槛。

- 缺点(基于当前信息,可能相对有限):

- 依赖计算资源:虽然比大型模型计算量小,但仍需一定计算资源来训练和运行。

- 潜在局限性:作为小模型,可能在某些复杂任务上仍不及大型模型全面。

DCLM-7B 的主要应用场景

- 自然语言处理:用于文本生成、文本分类、问答系统等任务。

- 学术研究:作为研究基准,帮助学者探索更高效的模型架构和训练方法。

- 应用开发:为开发者提供基础模型,支持定制化开发和应用部署。

如何使用DCLM-7B

- 下载资源:从Hugging Face等平台下载DCLM-7B的模型权重、训练代码和预训练数据集。

- 配置环境:根据训练代码的要求配置适当的计算环境和依赖库。

- 模型部署:将模型部署到合适的应用场景中,进行推理或进一步训练。

DCLM-7B 的训练方法

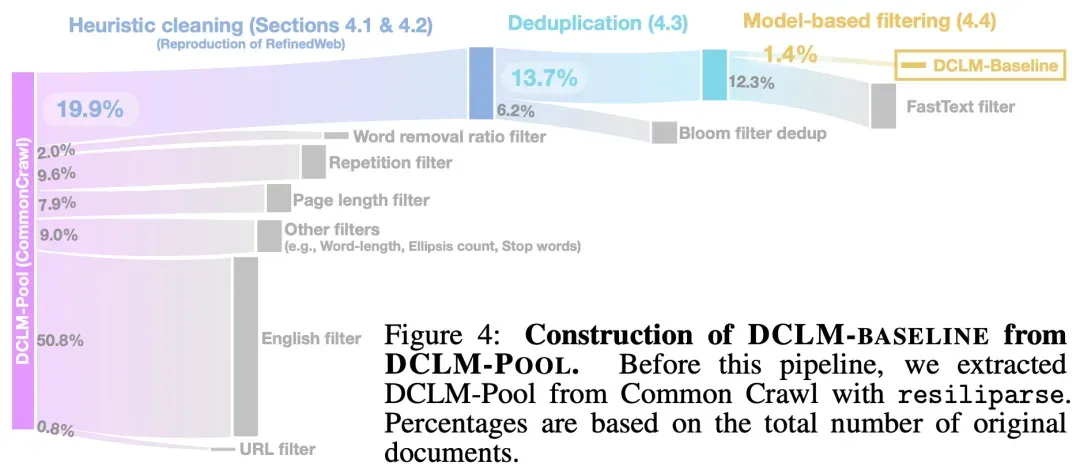

DCLM-7B的训练使用了标准的实验框架,包括固定的模型结构、训练代码、超参数和评估方法。训练过程中使用了AdamW优化器,学习率峰值为2e-3,权重衰减为0.05,批处理大小为2048个序列,序列长度为2048个标记,并在H100 GPU上进行训练。

DCLM-7B 的框架结构

DCLM-7B是一个基于解码器的Transformer语言模型,采用了先进的架构设计,并基于PyTorch与OpenLM框架进行优化。这种架构使得模型在处理语言任务时更加高效和准确。

DCLM-7B 的创新点

- 高质量数据集:通过设计高质量的数据集DCLM-BASELINE来提升模型性能。

- 开源典范:不仅开源模型权重,还开源训练代码和预训练数据集,树立了真正的开源典范。

- 性能优化:在保持较小参数规模的同时,通过优化模型架构和训练过程,实现了接近大型模型的性能。

DCLM-7B 的影响

DCLM-7B的发布推动了AI领域的小型化趋势,降低了AI技术的门槛和成本。它不仅为全球AI研究者和开发者提供了宝贵资源,还促进了AI技术的开放共享和进一步创新。未来,随着更多类似模型的推出和应用场景的拓展,小型化AI模型有望在更多领域发挥重要作用。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...