8月13日·Falcon Mamba 7B:挑战Transformer的新一代AI大模型

8月13日·周二 AI工具和资源推荐

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

Falcon Mamba 7B:挑战Transformer的新一代AI大模型

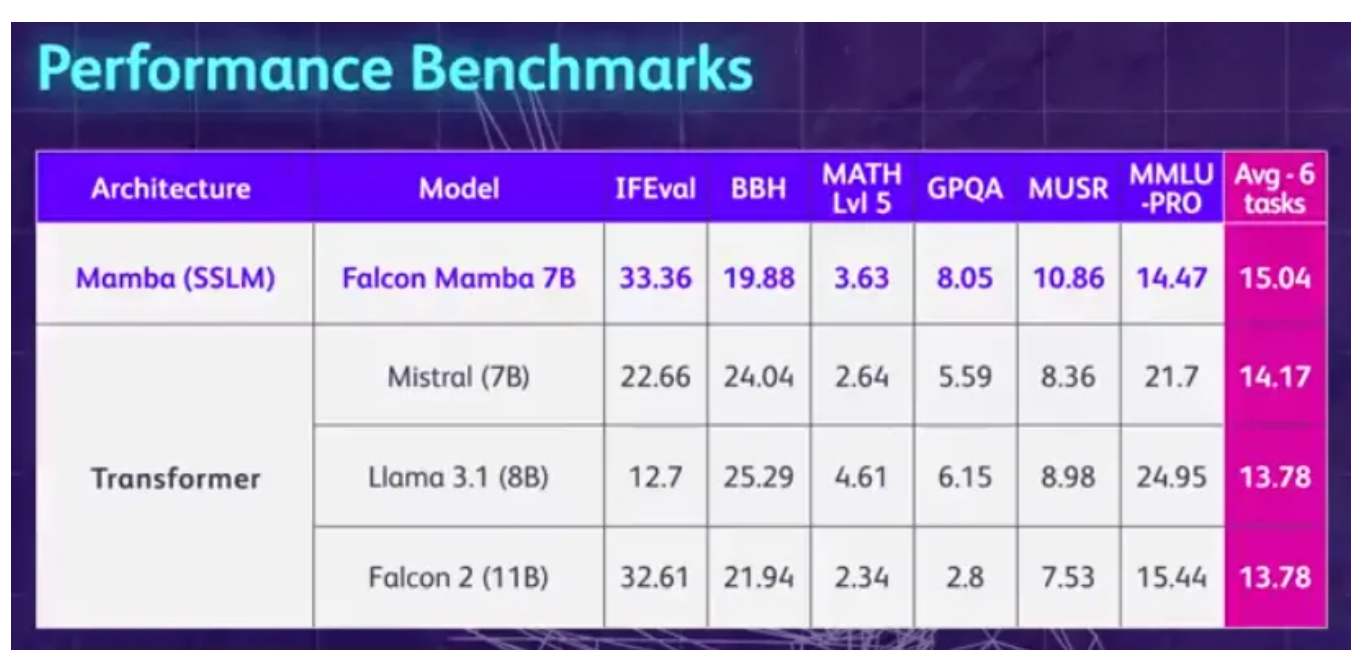

阿布扎比技术创新研究所(TII)近日发布了一款名为Falcon Mamba 7B的新型开源AI大模型,该模型基于Mamba架构,无需增加内存即可处理任意长度的序列,并在单个24GB A10 GPU上高效运行。Falcon Mamba 7B采用了创新的状态空间语言模型(SSLM)架构,通过动态调整参数来关注或忽略特定输入,类似于Transformer中的注意力机制,但更为高效。在多轮基准测试中,Falcon Mamba 7B在某些任务上超越了Meta的Llama 3 8B等同尺寸级别的领先模型。该模型训练数据高达5500GT,采用多阶段训练策略,上下文长度从2048增加到8192。TII表示,Falcon Mamba 7B的发布是智能系统探索的重要一步,有望推动生成式AI的进一步创新。来源:微信公众号【机器之心】

Genie:新一代AI工程师引领编程革命

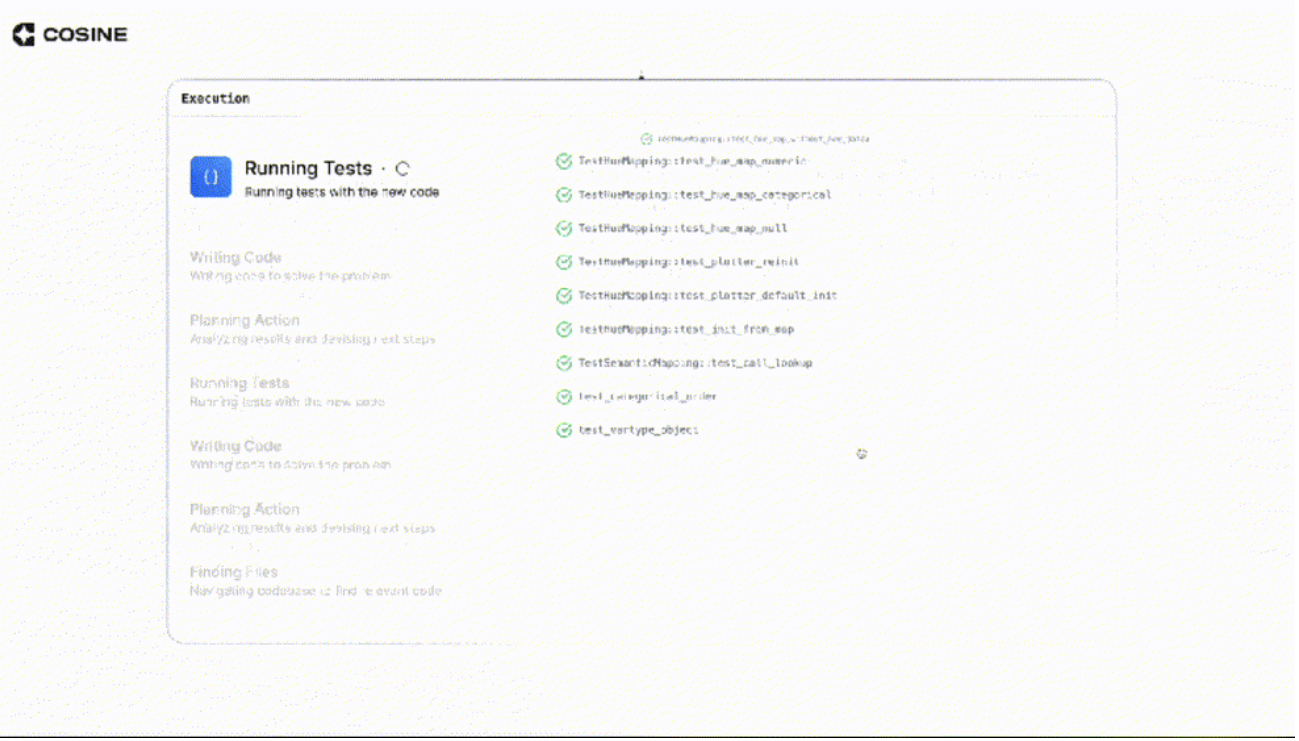

初创公司Cosine开发的AI工程师Genie,基于GPT-4o模型,以其卓越的编程能力超越了前辈Devin,成为业界领先的”AI软件工程师”。Genie不仅能够自主完成编码任务,包括bug修复、功能构建、代码重构等,还能与人类工程师协作,提出问题并回应评论。在SWE-Bench基准测试中,Genie以30.08%的得分大幅领先Devin的13.8%。Genie的训练数据集经过精心整理,涵盖了多种编程语言和真实的软件开发活动,使其能够模拟人类工程师的认知过程。目前Genie仍处于内测阶段,但已展现出改变软件开发团队工作方式的巨大潜力。来源:微信公众号【新智元】

Sakana AI推出首位AI科学家:自动生成十篇学术论文

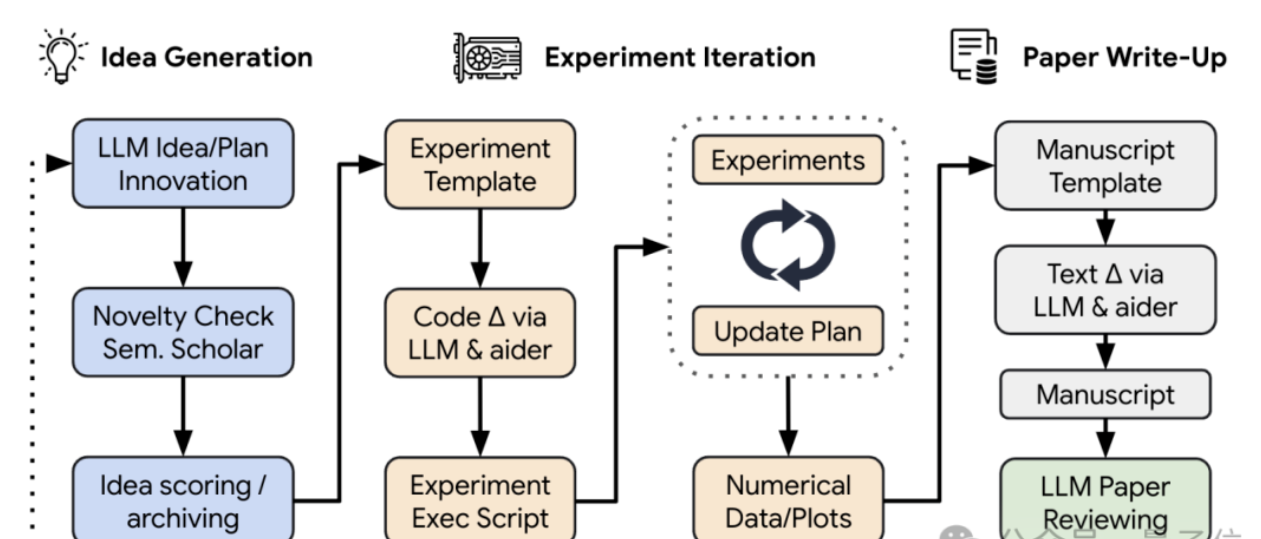

Sakana AI,由Transformer论文作者之一Llion Jones创立的公司,宣布成功开发了史上首位AI科学家,这一系统能够独立完成从研究想法的提出到实验设计、代码编写、结果分析,直至论文撰写的整个科研流程。AI科学家已经生成了十篇完整的学术论文,每篇成本仅约15美元。这些论文覆盖了机器学习的不同研究方向,包括扩散模型、语言模型、Transformer与强化学习的结合等。Sakana AI不仅开源了AI科学家和AI审稿人,还展示了AI在科学研究中的自动化潜力。尽管AI科学家生成的论文可能存在一些限制和挑战,但其低成本和高效率预示着AI在科学研究领域的应用前景广阔。来源:微信公众号【量子位】

巨人网络AI Lab发布多方言TTS大模型Bailing-TTS

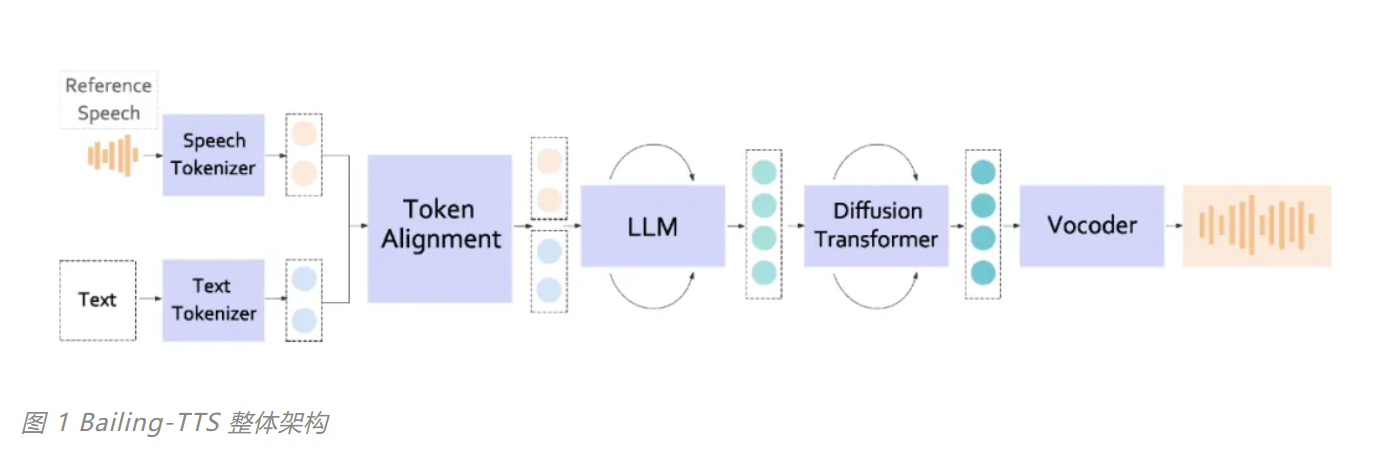

巨人网络AI Lab团队在语音合成技术领域取得重大突破,成功研发出首个支持多种普通话方言混说的TTS大模型——Bailing-TTS。该模型能够生成高质量的普通话语音,并覆盖河南话、上海话、粤语等20种方言,解决了方言语音合成领域的行业痛点和技术瓶颈。Bailing-TTS的创新之处在于统一方言Token规范、精细化Token对齐技术、层次混合专家结构和层次强化学习增强策略。这些技术的应用使得Bailing-TTS在普通话和方言的语音合成上达到接近真人的水平,已在游戏NPC配音、视频创作等领域得到应用,未来还将在方言文化保护、游戏AI NPC方言交互等领域展现更大潜力。巨人AI实验室将继续推动该技术的创新和应用,为用户提供更智能、更便捷的语音交互体验。来源:微信公众号【机器之心】

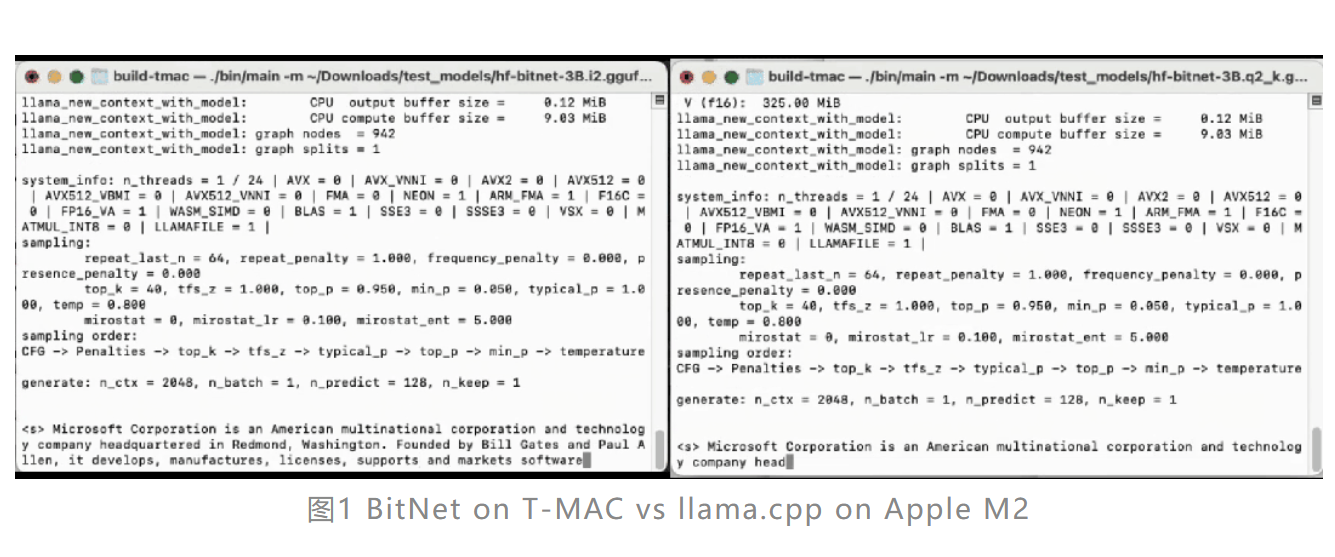

T-MAC:革新的CPU部署方案使LLM推理速度提升5倍

微软亚洲研究院联合中国科学技术大学、中国科学院大学研究人员共同开发了T-MAC,一种创新的基于查找表(LUT)的方法,专门设计用于在CPU上高效执行低比特大型语言模型(LLMs)的推理。T-MAC通过直接支持混合精度矩阵乘法(mpGEMM),无需权重反量化,显著降低了推理开销并提升了计算速度。这一技术突破使得在CPU上的推理速度能够超越专用加速器如NPU,且已成功开源。

T-MAC的关键创新在于它采用的基于LUT的计算范式,这种方法不仅减少了乘法和加法操作的数量,而且随着比特数的降低,计算性能线性提高。实验结果显示,在Surface AI PC上,T-MAC部署的模型生成速率远超NPU,且在低端设备如Raspberry Pi 5上也展现出良好的性能。此外,T-MAC在功耗上具有优势,所需核心数仅为原始llama.cpp的1/4至1/6。

T-MAC的开源为边缘设备上部署LLMs提供了新的可能性,不再依赖专用加速器,使得LLMs能够部署在PC、手机、树莓派等各类边缘端设备上。这项技术的发展为低比特模型如BitNet、EfficientQAT等提供了高效率的部署方案,预示着未来设备端智能性的极大增强。来源:微信公众号【新智元】

【今日案例】

如何利用人工智能构建未来应用场景

https://yuanbao.tencent.com/bot/app/share/chat/c2f10d3af51e4ca3e721aacacc91f007