10月20日·英伟达nGPT革新Transformer,AI训练速度激增20倍

10月20日·周日 AI工具和资源推荐

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

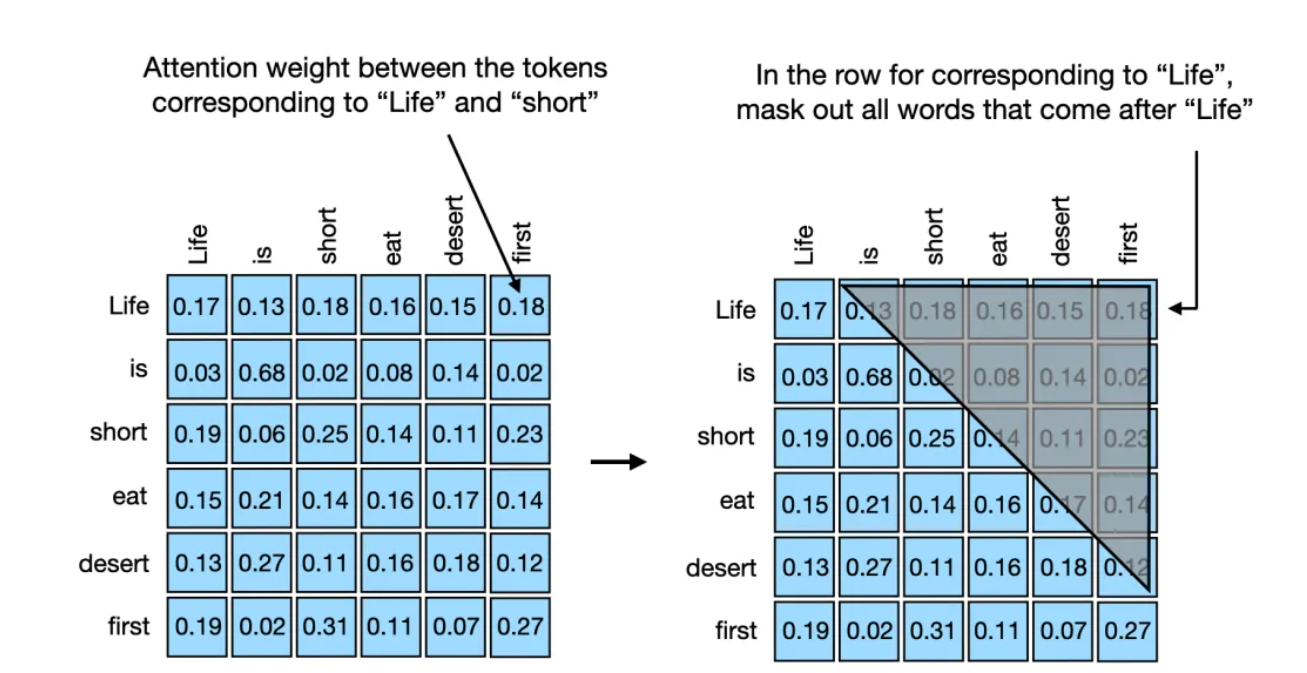

英伟达nGPT革新Transformer,AI训练速度激增20倍

英伟达团队近日提出了一种名为归一化Transformer(nGPT)的新型神经网络架构,该架构基于超球面表示学习,能够显著提升大型语言模型(LLM)的训练速度。在实验中,nGPT在不同上下文长度下均展现出卓越的性能,特别是在处理长文本时,训练速度可提高20倍,同时保持了模型的原有精度。这项技术不仅减少了训练步骤,还可能为实现人工通用智能(AGI)的目标提供强有力的支持。来源:微信公众号【新智元】

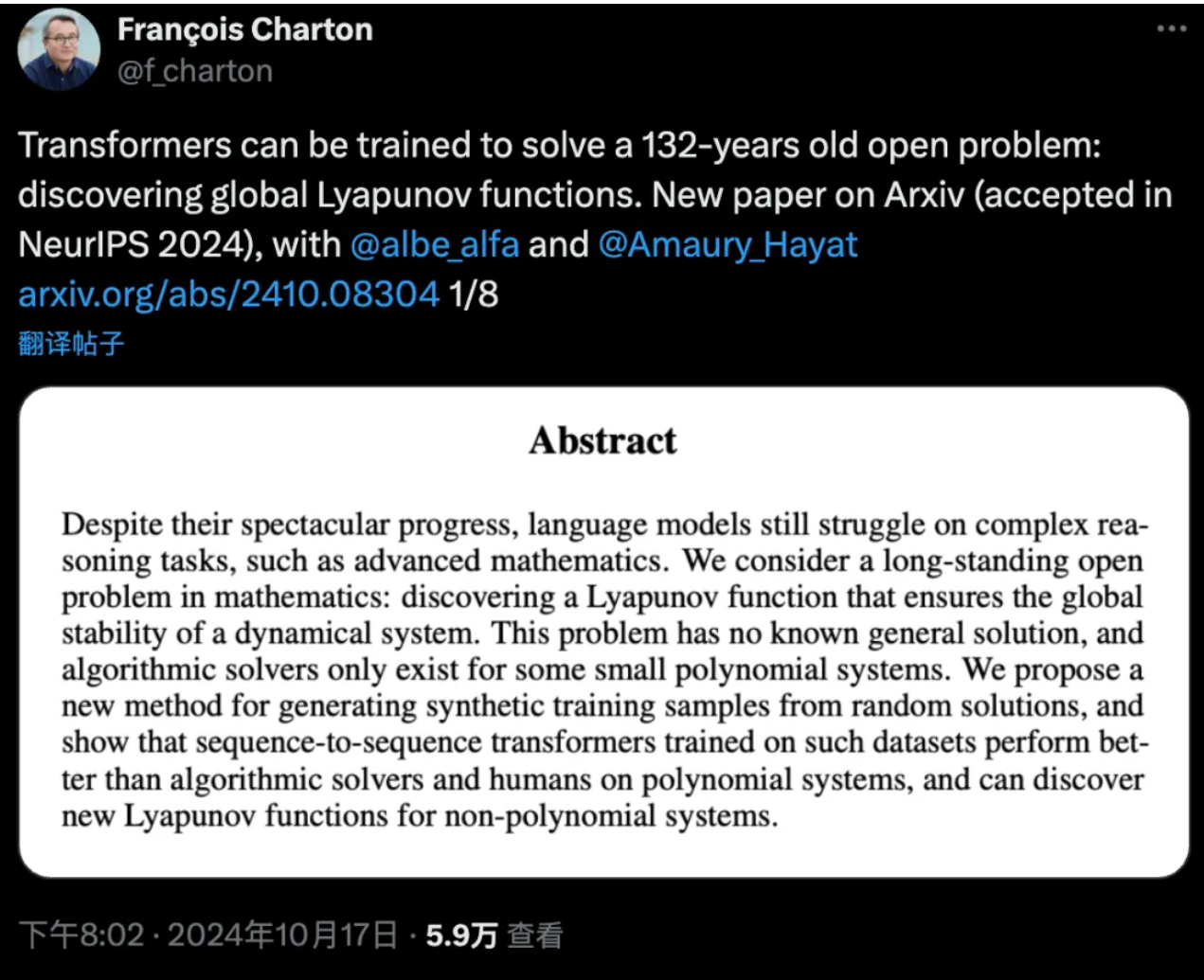

AI破解132年数学难题:李雅普诺夫函数

Meta和巴黎理工学院的研究人员利用Symbolic Transformer模型,在解决李雅普诺夫函数问题上取得了突破性进展。李雅普诺夫函数是判断动力系统稳定性的关键工具,但132年来一直缺乏通用解法。研究团队通过生成随机采样的李雅普诺夫函数训练数据,训练的Transformer模型在测试集上达到了99%的准确率,并在分布外测试集上展现了73%的高性能。这项研究不仅展示了AI在解决高级数学问题上的潜力,还为数学家提供了新的解题思路。AI模型生成的解决方案具有明确的数学正确性,可以被验证,这标志着人工智能在数学研究中的应用迈出了重要一步。来源:微信公众号【机器之心】

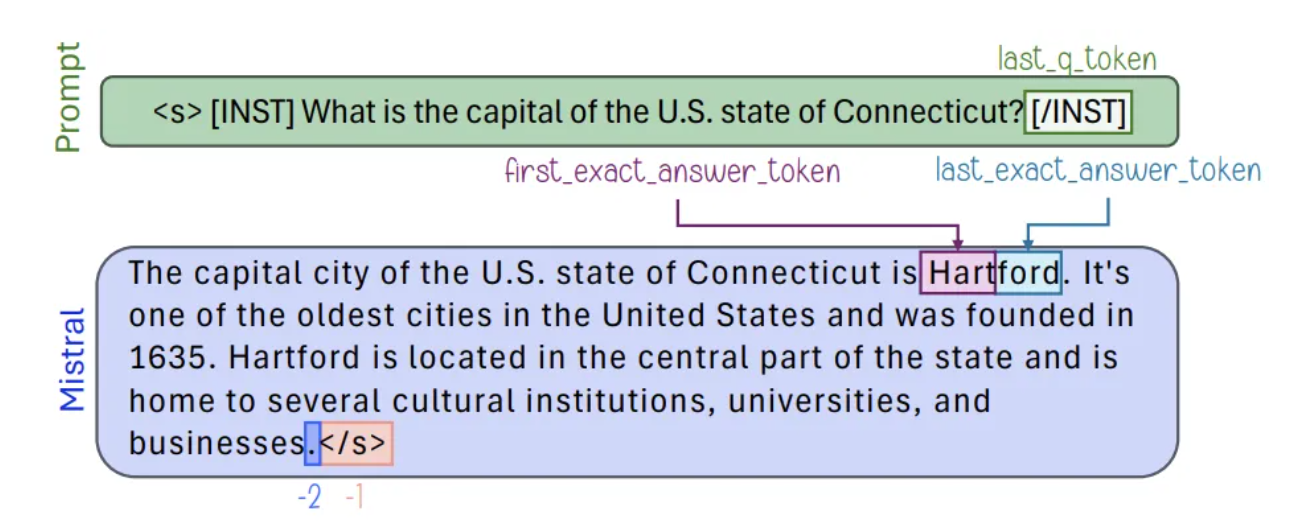

AI大模型被揭示“装傻”:谷歌屏柜最新发现知识多于表现

谷歌和苹果的最新研究揭示了一个关于大型语言模型(LLM)的有趣现象:这些模型掌握的知识远比它们表现出来的要多。研究团队通过训练分类器分析LLM的内部表示,发现模型的内部状态实际上编码了大量真实性信息,这些信息在特定token中尤为集中。这一发现不仅有助于提高检测LLM错误输出的能力,还提示我们LLM可能在某些情况下选择不展示其完整知识。研究建议,应将关注点从人类中心的幻觉解释转移到模型中心的视角,通过检查模型的中间激活来更好地理解和改进LLM的行为。来源:微信公众号【新智元】

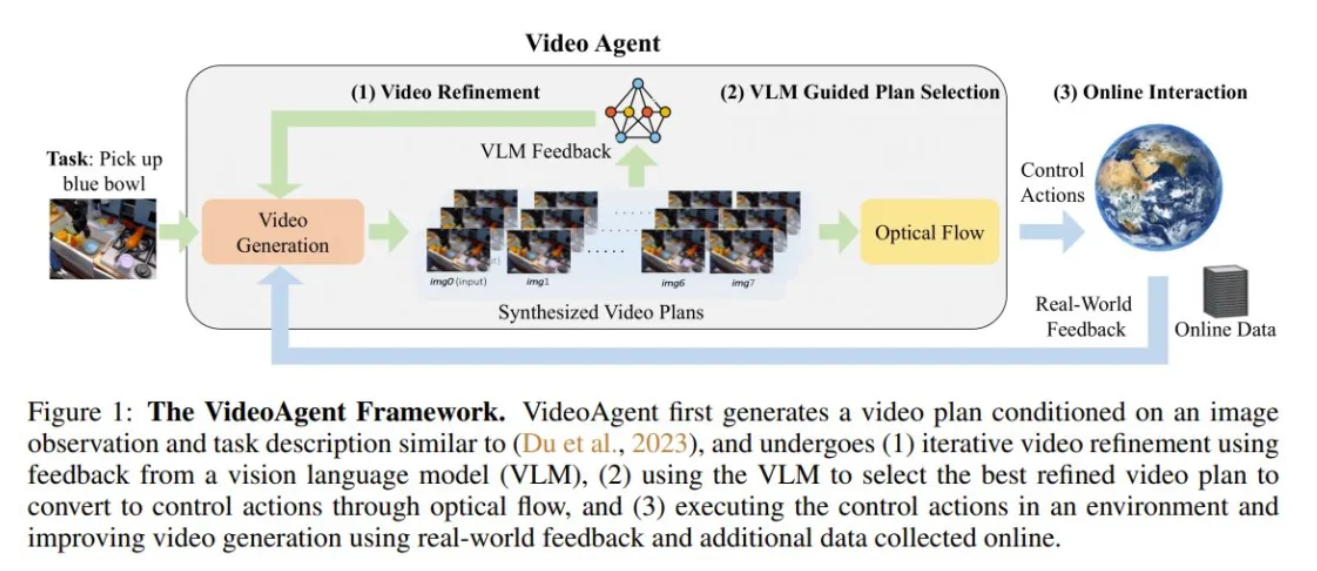

斯坦福大学提出VideoAgent:自我优化的视频生成智能体

斯坦福大学与其他机构的研究人员合作,提出了一种名为VideoAgent的视频生成模型,该模型能够通过自我调节一致性和外部反馈进行自我优化。VideoAgent利用预训练的视觉-语言模型(VLM)提供的AI反馈和真实世界执行反馈,迭代式地优化视频规划。在推理阶段,VideoAgent会查询VLM以选择最佳的改进版视频规划,并在环境中执行该规划。该模型在多个数据集上进行了实验,包括Meta-World、iTHOR和BridgeData V2,结果显示VideoAgent在端到端任务成功率和视频质量上均优于基线模型。这项研究不仅展示了视频生成模型的自我提升能力,也为未来视频生成技术的应用提供了新的可能性。来源:微信公众号【机器之心】

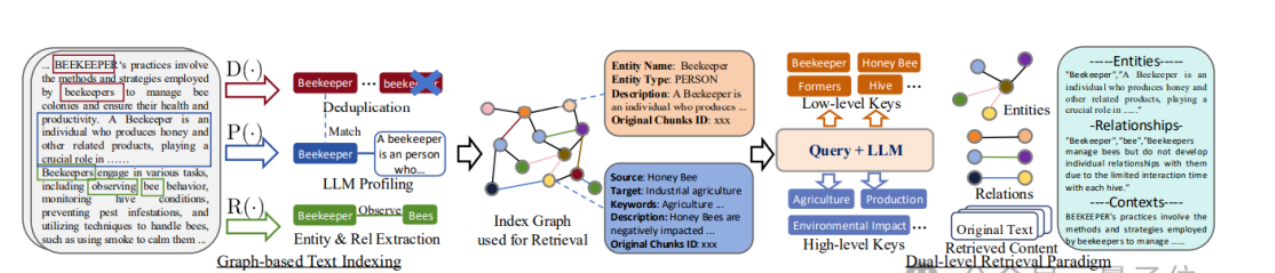

港大LightRAG模型:降低大模型问答成本,提升信息检索效率

香港大学黄超团队研发的LightRAG模型,通过引入基于图的文本索引和双层检索范式,显著提升了大模型在问答任务中的效率和准确性。LightRAG不仅全面理解复杂实体间的依赖关系,还大幅降低了检索增强系统的成本。该模型在GitHub开源仅两周便获得了4.7k标星,显示出其受欢迎程度。LightRAG的图结构与向量表示结合,提高了检索速度并保持了上下文相关性,同时快速适应动态数据变化,使其在快速变化的数据环境中保持有效响应。这一研究成果为大模型的问答系统提供了新的解决方案,具有重要的实际应用价值。来源:微信公众号【量子位】