2月12日·清华团队1B模型凭测试时Scaling逆袭405B,小模型推理能力大幅提升

2月12日·周三 AI工具和资源推荐

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在[图片]这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的o g zAI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

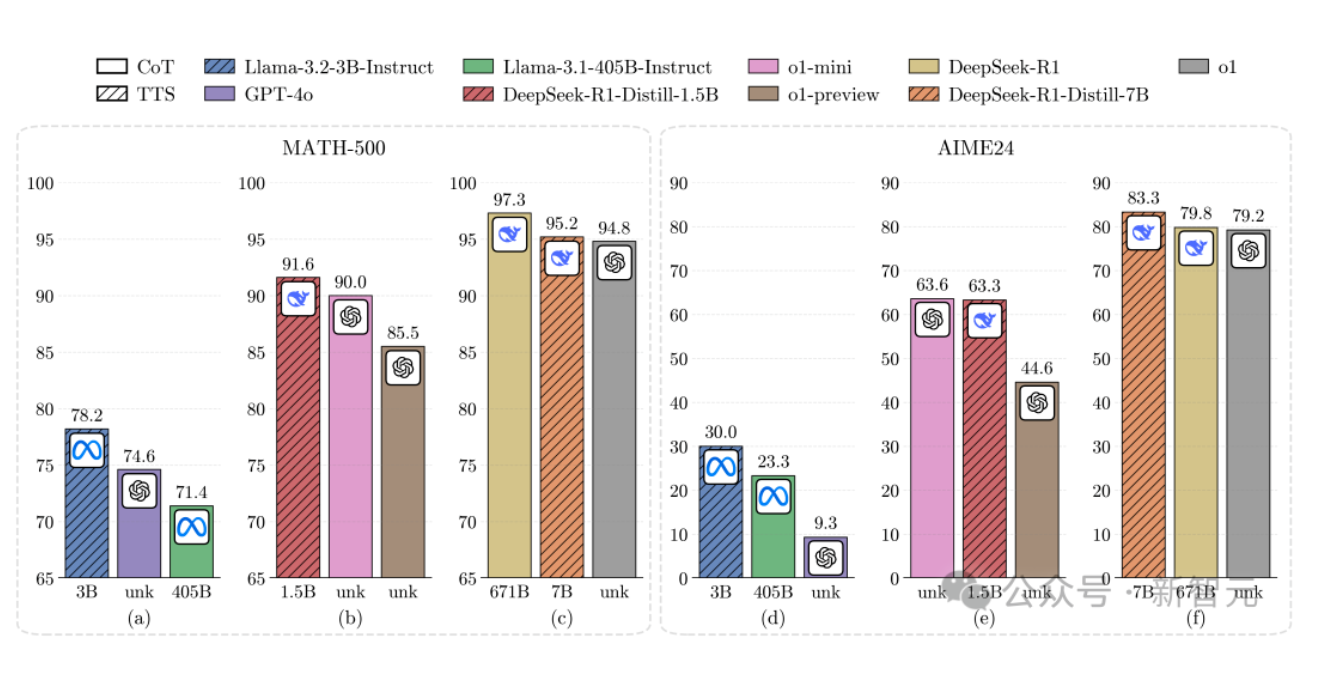

清华团队1B模型凭测试时Scaling逆袭405B,小模型推理能力大幅提升

清华大学联合多机构发布了一项关于大语言模型(LLM)测试时Scaling(TTS)策略的研究成果,引发AI领域广泛关注。研究团队通过计算最优的TTS策略,成功让仅1B参数的小模型在数学任务上超越了405B的超大模型,7B模型更是力压DeepSeek R1等顶尖选手。该策略通过在推理时分配额外算力,显著增强了模型的推理能力。实验表明,小模型在经过计算最优TTS策略优化后,不仅在性能上超越了更大规模的模型,还大幅减少了总计算量,展现了极高的效率。这一成果为大语言模型的优化提供了新的思路,也为未来AI技术的发展提供了重要参考。来源:微信公众号【新智元】

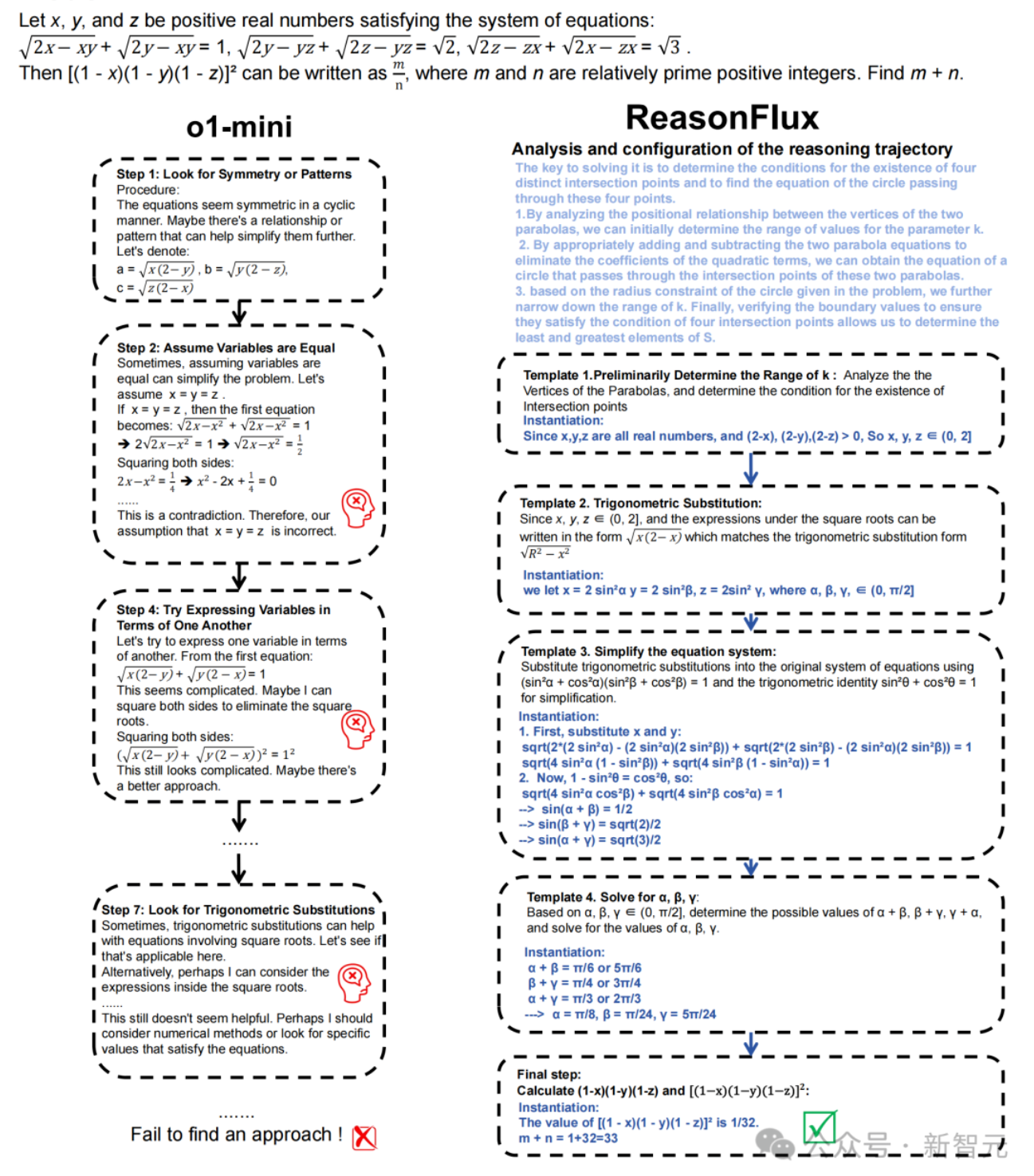

普林斯顿北大联合提出ReasonFlux框架,32B模型以8块A100碾压o1-preview

普林斯顿大学与北京大学联合提出了一种创新的分层LLM推理框架——ReasonFlux,通过分层强化学习和结构化思维模板库,显著提升了大语言模型在复杂推理任务中的表现。该框架仅用8块A100 GPU训练出的32B模型,在MATH和AIME等数学基准测试中,大幅超越了o1-preview、DeepSeek V3等顶尖模型,准确率分别达到91.2%和56.7%。ReasonFlux的核心在于其三大创新:一是构建了包含500个高层次思维模板的结构化模板库,可泛化到类似推理问题;二是通过分层强化学习优化推理路径;三是设计了自适应推理Scaling系统,动态调整模板轨迹以高效求解。这一成果为小模型在复杂任务中超越大模型提供了新思路,也为未来AI推理技术的发展开辟了新方向。来源:微信公众号【新智元】

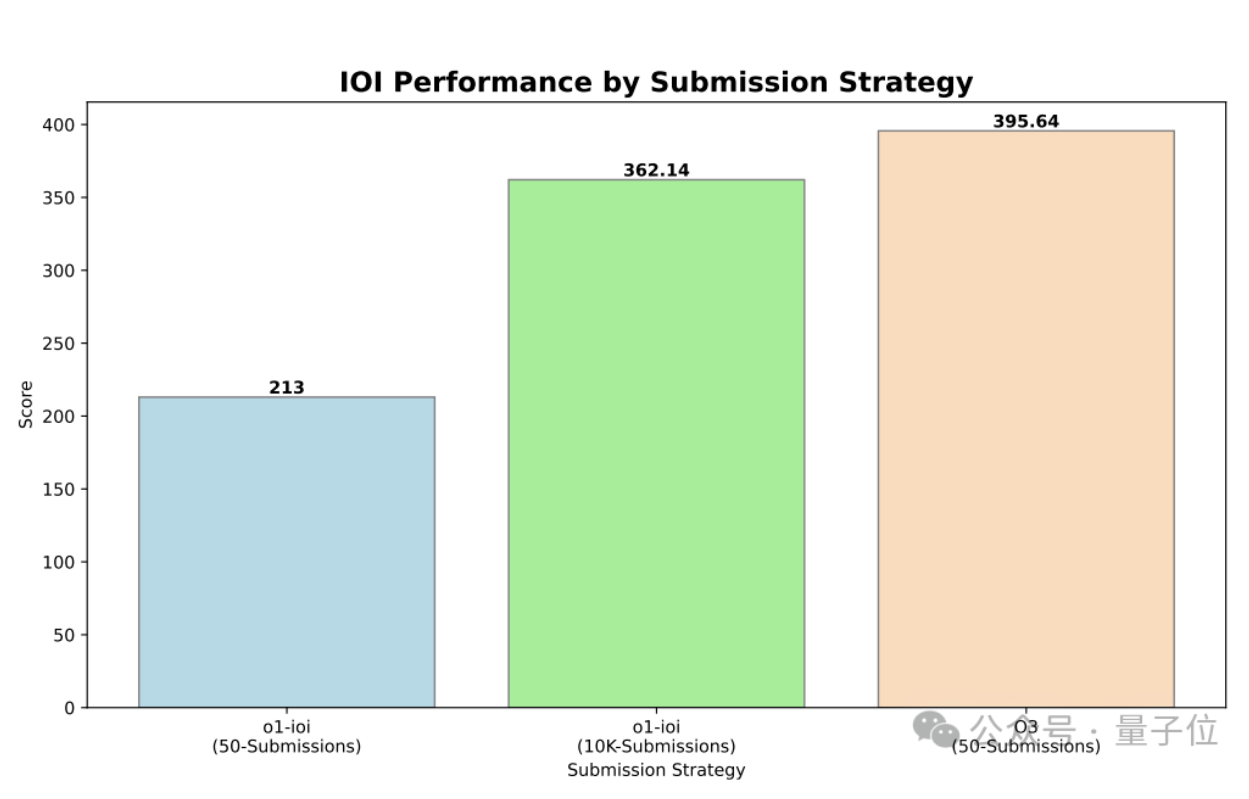

OpenAI o3斩获IOI 2024金牌,AI自主设计推理策略成关键

OpenAI发布了一篇关于推理模型在竞技编程中应用的研究论文,展示了其推理模型o3在国际信息学奥林匹克竞赛(IOI 2024)中轻松获得金牌的成果。o3在严格规则下以395.64分超越金牌分数线(359.71),表现超越人类顶尖选手。论文指出,o3通过大规模端到端强化学习(RL),无需人工设计的测试时推理策略,即可自主学会优化解题策略。例如,它会先写出暴力求解代码,再用最优算法交叉验证,显著提升了解题效率。此外,o3在CodeForces基准测试中也表现出色,评分达到2724,超越99.8%的选手。这一成果表明,AI在复杂推理任务中的自主学习能力正在快速提升,为未来AI在更多领域的应用提供了新的思路。来源:微信公众号【量子位】

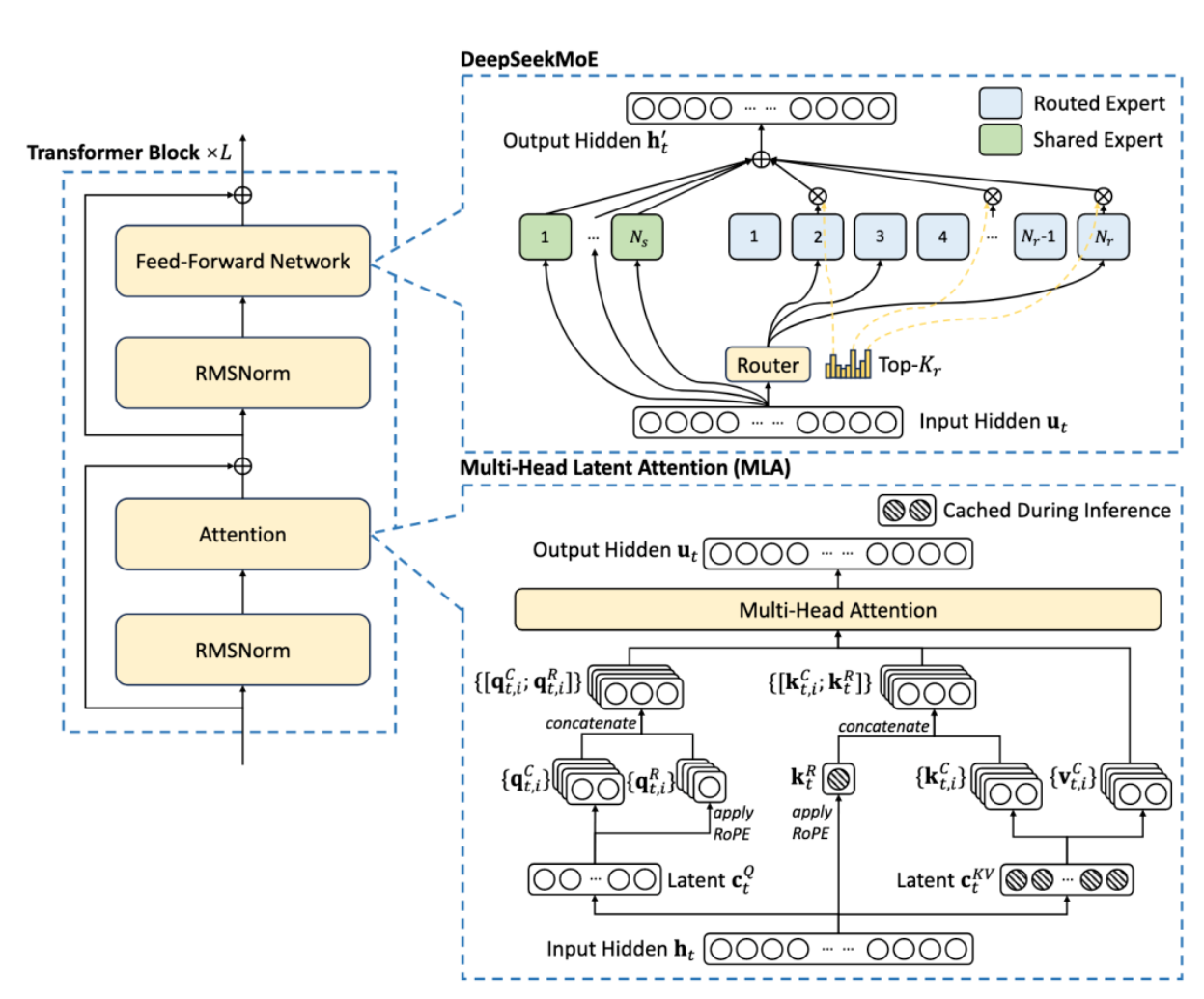

清华团队开源KTransformers,4090单卡运行DeepSeek-R1满血版

清华大学KVCache.AI团队联合趋境科技开源的KTransformers项目取得重大突破,成功支持在24GB显存的单卡(如RTX 4090)上运行DeepSeek-R1和V3的671B满血版模型。这一成果打破了大模型对硬件的高门槛限制,推理速度最高可达14 tokens/s,预处理速度达286 tokens/s,相比llama.cpp提升近28倍。KTransformers利用MoE架构的稀疏性,通过GPU/CPU异构计算策略,将稀疏矩阵放在CPU处理,稠密部分放在GPU处理,显著降低显存需求。此外,项目还引入高性能CPU和GPU算子、CUDA Graph加速等技术优化推理性能,并提供兼容Hugging Face的API和ChatGPT式界面,极大降低了使用门槛。目前,KTransformers在localLLaMa社区热度居首,为中小团队和科研工作者探索大模型提供了高效、低成本的解决方案。来源:微信公众号【量子位】

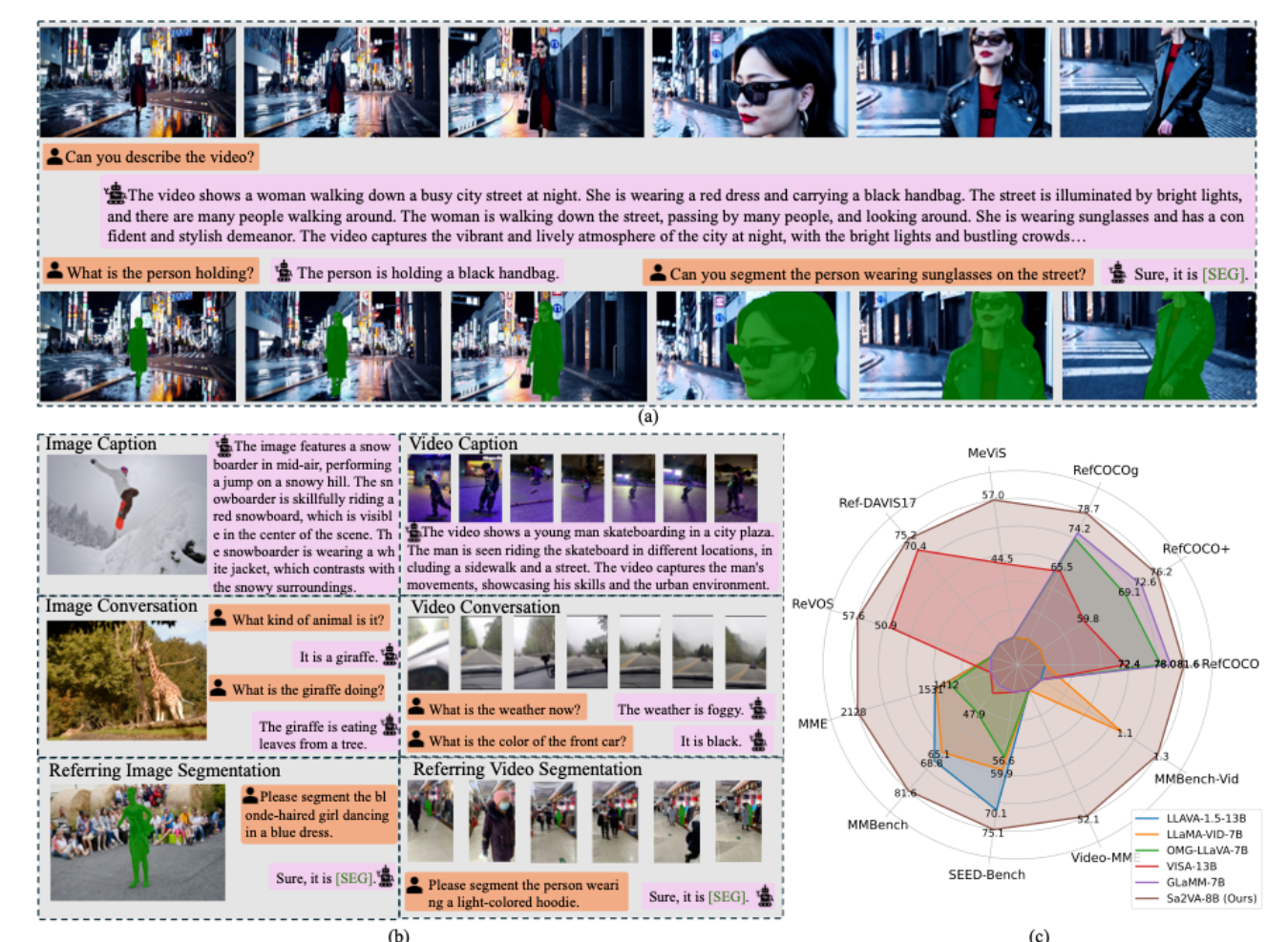

字节跳动提出Sa2VA,统一SAM2和LLaVA实现多模态任务突破

字节跳动联合北京大学等机构推出了一种新型多模态大模型Sa2VA,首次将SAM2的感知能力和LLaVA的推理能力相结合,实现了图像和视频的细粒度理解与分割。Sa2VA通过统一的指令微调格式,整合了图像对话、视频对话、指代分割等超过20个数据集进行联合训练,在多个视频和图像理解任务上取得了领先效果。该模型采用分离设计,将多模态大语言模型与SAM2模型结合,通过“[SEG]”令牌连接两者,支持时空感知和对话生成。此外,Sa2VA还提出了新的Ref-SAM-v基准测试,进一步验证了其在多模态任务上的优越性能。Sa2VA的推出为多模态大模型的发展提供了新的思路和方法。来源:微信公众号【机器之心 】