OLMo 2 32B —— Ai2 推出的最新开源语言模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

OLMo 2 32B 是由艾伦人工智能研究所(Allen Institute for AI,简称 Ai2)推出的最新开源语言模型。该模型拥有 320 亿参数,是 OLMo 2 系列的最新力作。Ai2 毫不保留地公开了 OLMo 2 32B 的所有数据、代码、权重及详细的训练过程,旨在促进更广泛的研究和创新,推动人工智能领域的进步。

功能特点

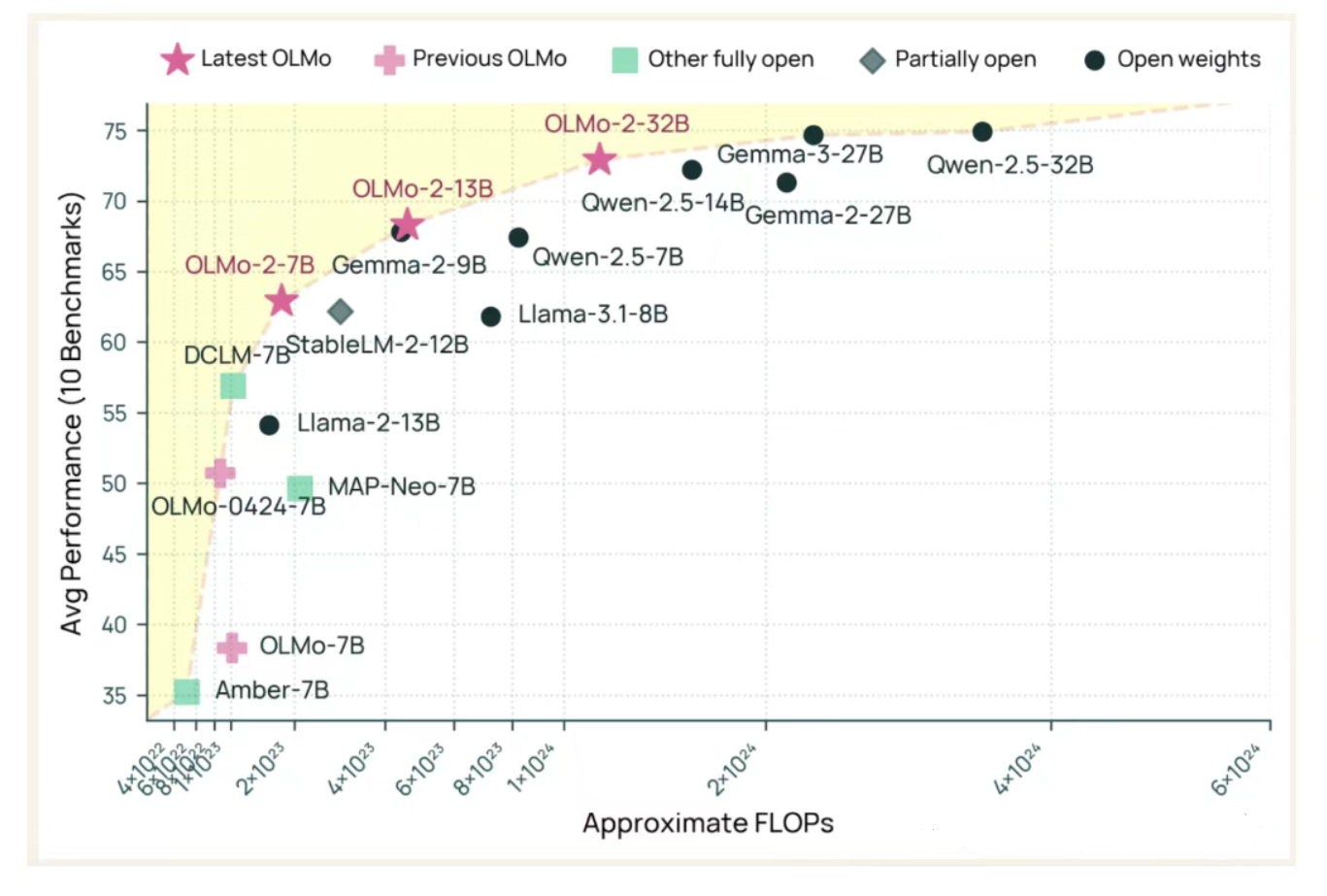

- 高性能:OLMo 2 32B 在多项被广泛认可的学术基准测试中,展现了卓越的性能,甚至超越了 GPT-3.5 Turbo 和 GPT-4 Turbo 等商业模型。

- 多任务处理能力:该模型经过微调,适用于多种任务,如聊天、数学、GSM8K 和 IFEval 等,是适用于各种应用的通用工具。

- 完全开源:Ai2 公开了 OLMo 2 32B 的所有数据、代码、权重及详细的训练过程,为全球的研究人员提供了宝贵的学习资源和研究基础。

- 高效训练:OLMo 2 32B 在达到与领先的开放权重模型相当的性能水平时,仅使用了约三分之一的计算资源,体现了高效的训练方法。

优缺点

优点:

- 高性能:在多项基准测试中表现出色,甚至超越了一些商业模型。

- 完全开源:提供了丰富的资源和工具,方便研究人员进行定制和优化。

- 高效训练:训练效率高,降低了计算资源的使用成本。

- 多任务处理能力:适用于多种任务,具有广泛的应用前景。

缺点:

- 计算资源需求:尽管训练效率高,但作为大规模语言模型,OLMo 2 32B 在推理时仍需要一定的计算资源支持。

- 模型复杂性:模型参数众多,可能增加使用的复杂性和调试难度。

如何使用

- 安装依赖:首先,需要安装 Transformers 库和相关的依赖项。

- 加载模型:使用 Hugging Face 的 Transformers 库加载预训练的 OLMo 2 32B 模型。

- 输入处理:将输入文本进行预处理,如分词、编码等。

- 模型推理:将预处理后的输入传递给模型,获取推理结果。

- 结果后处理:根据需要对推理结果进行后处理,如解码、格式化等。

框架结构

OLMo 2 32B 的框架结构主要包括以下几个部分:

- 输入层:接收输入文本,进行分词和编码处理。

- Transformer 编码器:由多个 Transformer 层组成,负责提取文本特征。

- 输出层:根据任务需求,生成相应的输出结果(如文本、标签等)。

创新点

- 完全开源:Ai2 公开了 OLMo 2 32B 的所有数据、代码、权重及详细的训练过程,这是目前开源语言模型中极为罕见的做法。

- 高效训练:通过优化模型架构和训练方法,提高了训练效率,降低了计算资源的使用成本。

- 多任务处理能力:经过微调后,OLMo 2 32B 适用于多种任务,具有广泛的应用前景。

评估标准

评估 OLMo 2 32B 的性能时,可以考虑以下几个标准:

- 基准测试成绩:在各类学术基准测试中的表现,如困惑度、准确率等。

- 推理速度:模型处理输入文本并生成推理结果的速度。

- 资源利用率:模型在推理过程中使用的计算资源和内存资源。

- 任务适应性:模型在不同任务上的适应性和表现。

应用领域

OLMo 2 32B 适用于多个领域,包括:

- 自然语言处理:文本生成、语言理解、问答系统等。

- 智能客服:提供自动化的客户服务,解答用户问题。

- 内容创作:辅助创作新闻、文章、诗歌等文本内容。

- 教育:提供个性化的学习资源和辅导服务。

项目地址

OLMo 2 32B 的项目地址包括:

- GitHub 仓库:https://github.com/allenai/OLMo-core

- Hugging Face 模型仓库:https://huggingface.co/allenai/OLMo-2-0325-32B-Instruct

用户可以通过这些地址获取 OLMo 2 32B 的最新代码、预训练模型和详细文档,以便进行研究和开发工作。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...