LMEval:谷歌开源的统一评估多模态AI模型框架

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

LMEval是谷歌于2025年5月26日开源的统一评估框架,旨在解决多模态AI模型(如LLaDA-V、GPT-4V等)评测标准不统一的问题。该框架通过标准化基准设置和跨平台接口兼容性(如LiteLLM),支持文本、图像、代码等多领域任务的自动化评估,同时提供隐私保护、可视化分析和高效计算等特性,助力开发者快速优化模型性能。

功能特点

- 多模态任务支持:覆盖图像描述、视觉问答(VQA)、视频理解、音频分析、多模态推理和生成等任务。

- 跨平台兼容性:通过LiteLLM兼容Google、OpenAI等主流平台的接口差异,实现无缝测试。

- 隐私与效率:测试数据存储于本地加密数据库,增量评估和多线程引擎设计显著降低计算成本。

- 可视化分析:LMEvalboard工具通过雷达图直观展示模型性能差异,助力开发者精准优化。

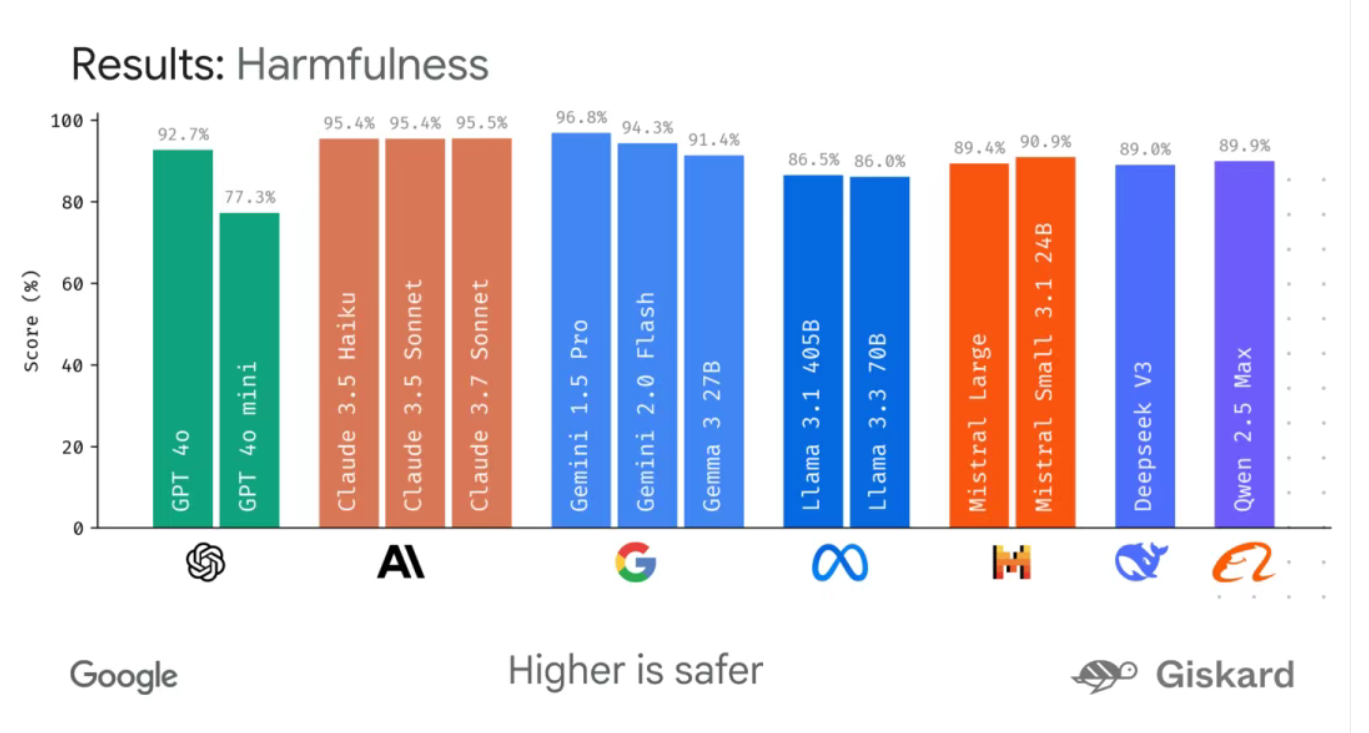

- 安全评分:引入Giskard安全评分量化模型防护能力,识别规避风险内容的策略。

优缺点

优点:

- 标准化评估:统一多模态模型的评测流程,解决标准不统一难题。

- 高效计算:增量评估和多线程引擎设计降低计算资源需求。

- 隐私保护:本地加密数据库确保数据安全。

- 可视化工具:直观展示模型性能差异,加速优化过程。

缺点:

- 任务覆盖有限:尽管支持多模态任务,但可能无法覆盖所有新兴应用场景。

- 学习成本:对新手开发者而言,框架的配置和使用仍需一定学习成本。

如何使用

- 安装依赖:

- 配置评估任务:

在YAML文件中定义模型路径、数据集和评估指标(如准确率、鲁棒性)。 - 运行评估:

- 查看结果:

通过LMEvalboard可视化工具分析模型性能雷达图。

框架技术原理

- 标准化基准设置:定义统一的模型、数据集和评估指标接口,支持快速扩展新任务。

- 跨平台兼容层:基于LiteLLM实现不同平台接口的适配,确保评估流程的一致性。

- 隐私保护机制:测试数据加密存储,避免数据泄露风险。

- 高效计算引擎:增量评估技术减少重复计算,多线程引擎加速大规模任务处理。

创新点

- 统一评估框架:首次实现多模态AI模型的标准化评测,填补行业空白。

- 隐私与效率平衡:通过本地加密和多线程技术,兼顾数据安全和计算效率。

- 可视化分析工具:LMEvalboard提供直观的性能对比,加速模型迭代。

评估标准

- 准确性:衡量模型在多模态任务中的输出正确率。

- 鲁棒性:测试模型在OOD(分布外)数据和对抗样本下的表现。

- 安全性:通过Giskard评分量化模型规避风险内容的能力。

- 效率:评估模型的推理速度和资源占用情况。

应用领域

- 学术研究:为多模态大模型(如LLaDA-V)提供标准化评测工具。

- 工业落地:支持自动驾驶、机器人、医疗影像分析等领域的模型优化。

- 竞赛与榜单:作为多模态AI竞赛的官方评估框架,推动技术发展。

项目地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...