Step-Audio 2 mini : 阶跃星辰开源的端到端语音大模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

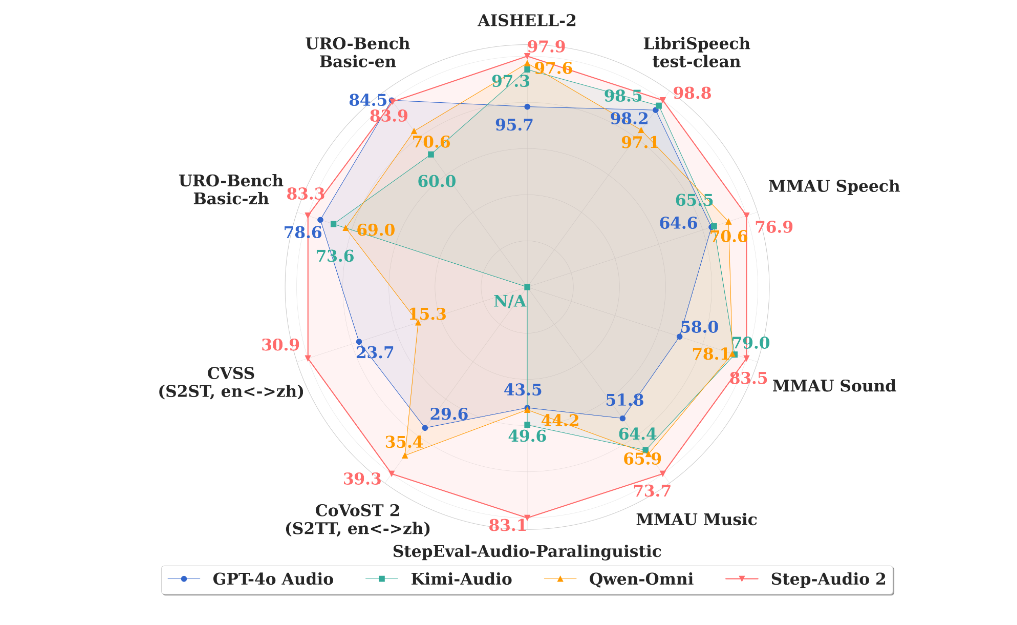

阶跃星辰于2025年9月1日正式发布开源端到端语音大模型 Step-Audio 2 mini,该模型在多个国际基准测试集上取得SOTA(State-of-The-Art,当前最佳水平)成绩,综合性能超越Qwen-Omni、Kimi-Audio等开源模型,并在大部分任务上超越GPT-4o-audio。作为国内首个实现量产上车的端到端语音大模型(已搭载于吉利银河M9车型),Step-Audio 2 mini通过统一建模语音理解、音频推理与生成,重新定义了人机语音交互的效率与智能上限,成为多模态技术领域的里程碑式突破。

功能特点

- 全链路端到端建模

- 突破传统ASR(语音识别)+LLM(大语言模型)+TTS(语音合成)三级结构,实现原始音频输入到语音响应输出的直接转换,架构更简洁、时延更低(响应速度提升3倍以上)。

- 支持语音原生的 Tool Calling 能力,可联网搜索实时信息(如查询天气、新闻),有效解决模型幻觉问题,并赋予其文本大模型级的知识储备与推理能力。

- 副语言与非人声信号理解

- 首创音频推理能力,能精准捕捉情绪(如愤怒、喜悦)、语调(升调疑问、降调陈述)、音乐(旋律、节奏)等副语言信息,以及环境音(鸟鸣、流水)、机械声(引擎加速)等非人声信号。

- 示例:在官方案例中,模型可分清鸟叫、流水、车声和发条玩具声,甚至能识别汽车引擎的加速变化。

- 多任务统一处理

- 在音频理解、语音识别、跨语种翻译、情感解析、语音对话等任务中表现突出,支持中、英、日等13种语言及方言,并能根据上下文自动调整回应风格(如正式、幽默)。

优缺点

优点

- 性能领先:在通用多模态音频理解等基准测试中,语义匹配度(CLAP指标)比基线模型提升23%,音频质量(FAD指标)降低30%,接近真实录音质感。

- 低时延高效率:端到端架构使交互时延降低至传统模型的1/3,适合实时应用场景(如车载语音助手、在线客服)。

- 开源生态完善:采用Apache 2.0协议,支持商业与非商业使用,提供完整部署文档、API调用示例及轻量化部署方案(8B参数模型可在RTX 3060显卡上实时推理)。

缺点

- 音色选择有限:目前仅提供男声、女声两种基础音色,其他音色需通过prompt调整,个性化定制能力待加强。

- 信息识别精度待提升:在复杂场景(如多人对话、背景噪音)下,部分非关键信息识别准确率仍有优化空间。

如何使用

- 环境配置

- 支持Hugging Face、PyTorch框架,提供4-bit AWQ量化技术以降低显存占用(8B模型量化后显存从12GB降至3GB)。

- 输入指令

- 通过自然语言描述需求(如“用欢快的语调朗读《静夜思》”),或上传音频文件并指定任务(如“识别环境音中的汽车品牌”)。

- 生成与调优

- 支持SSML标记语言自定义参数(语速、音量),并可通过强化学习迭代优化生成结果。

框架技术原理

- 端到端多模态架构

- 将语音理解、音频推理与生成统一为单一神经网络,通过共享参数实现跨模态信息融合。例如,在识别“愤怒语调”时,模型会同时分析声学特征(音高、能量)和语义内容(用词激烈程度)。

- 链式思维推理(CoT)与强化学习

- 引入CoT推理机制,将复杂任务拆解为子步骤(如“先识别情绪→再调整回应风格”),并通过强化学习优化决策路径,提升逻辑连贯性。

- 音频知识增强

- 支持外部工具调用(如网页搜索、数据库查询),使模型能动态获取最新信息,避免“知识过时”问题。

创新点

- 副语言与非人声信号的精细理解

- 传统模型仅关注文本内容,而Step-Audio 2 mini通过多模态融合技术,能解析语音中的“弦外之音”(如笑声表示调侃、沉默表示犹豫),使交互更自然。

- 语音原生的Tool Calling能力

- 首次在端到端语音模型中实现工具调用,无需依赖文本中间层,直接通过语音完成复杂操作(如“查询明天北京天气并播报”)。

评估标准

- 语义匹配度(CLAP):衡量生成语音与文本指令的契合程度,减少“文不对音”情况。

- 音频质量(FAD):量化生成音频与真实录音的相似度,关注泛音细节、层次感等维度。

- 时序连贯性:通过人工评测检验场景转换的自然度(如雨声渐强与音乐减弱的过渡是否平滑)。

- 任务完成率:在跨语种翻译、情感解析等任务中统计成功执行比例。

应用领域

- 智能车载:已搭载于吉利银河M9,实现语音控制导航、空调调节,并能根据驾驶员情绪(如疲劳)自动调整回应策略。

- 在线教育:为数学题、科学实验视频生成解说音频,AIME25数学竞赛题解说准确率达75.6%。

- 短视频创作:为英超赛事集锦自动匹配进球欢呼声、解说词,每分钟生成5-8条15秒短视频。

- 无障碍交互:为视障用户实时描述环境音(如“前方有行人过马路”),提升出行安全性。

项目地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...