GDPVAL : OpenAI开源的AI模型经济价值评估框架

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

GDPVAL是OpenAI推出的首个直接衡量AI模型在真实经济价值任务中表现的评估框架,旨在填补学术测试与实际商业应用之间的差距。该框架通过模拟现实世界中的高价值职业任务(如法律文书撰写、工程图纸设计、护理计划制定等),评估AI模型对生产力的实际贡献。其核心目标是提供可量化的指标,帮助企业、开发者和政策制定者理解AI技术在经济领域中的潜在影响,推动AI技术从实验室走向规模化商业应用。

功能特点

- 多行业覆盖:

聚焦美国GDP贡献最大的9个行业(如金融、医疗、制造、政府服务等),涵盖44种知识密集型职业(如律师、软件工程师、注册护士、机械工程师等),确保评估的广泛代表性。 - 真实任务模拟:

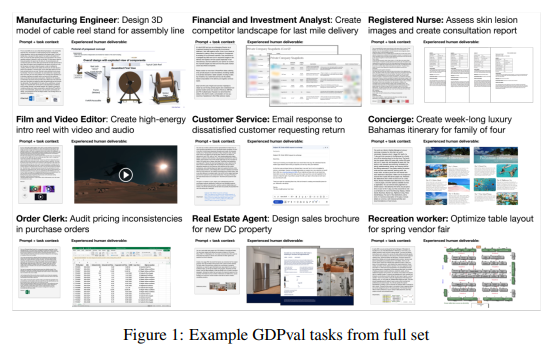

任务设计基于真实工作场景,包含法律简报、工程蓝图、客户支持对话等1320个具体任务(开源版本含220个),交付物形式包括文档、幻灯片、图表、电子表格及多媒体内容,贴近实际工作需求。 - 专家评审机制:

任务由平均拥有14年行业经验的专业人士设计,并经过至少5轮专家审核,确保任务的真实性和可行性。评估阶段采用行业专家盲审,对比AI与人类专家的交付成果,提供“更好”“相当”“更差”三级评分。 - 多模态输出支持:

要求AI模型处理完整参考材料和工作背景,输出形式不限于文本,还涵盖PPT、图表等复杂内容,全面检验模型的综合能力。

优缺点

优点:

- 现实性强:任务直接取材于真实经济活动,评估结果更具商业参考价值。

- 覆盖面广:跨行业、多职业的设计,能反映AI在不同领域中的适用性。

- 专家背书:通过资深从业者审核和盲评,确保评估的权威性和可靠性。

缺点:

- 静态评估:当前版本主要评估一次性任务,未涵盖需多轮修改或动态交互的复杂场景(如根据客户反馈调整方案)。

- 成本计算简化:仅统计模型推理时间和API费用,未纳入人工监督、迭代优化等实际成本。

- 地域局限:目前仅针对美国职业市场设计,需扩展以适应全球不同经济环境。

如何使用

- 访问项目平台:

通过OpenAI官网或Hugging Face模型库下载GDPVAL开源数据集(含220个黄金任务子集)及自动评分服务工具。 - 选择评估任务:

根据目标行业(如金融、医疗)或职业类型(如律师、工程师),从数据集中选取相关任务。 - 运行模型并提交结果:

使用待评估的AI模型(如GPT-5、Claude 4.1)完成任务,生成文档、PPT等交付物,并上传至平台。 - 获取评估报告:

系统自动匹配行业专家评分标准,生成模型表现报告(含胜率、准确性、美观性等指标),或调用自动评分器进行快速预估。

框架技术原理

- 任务设计流程:

- 行业筛选:从美国联邦储备银行数据中锁定GDP贡献超5%的行业,再选取每个行业中工资总额贡献最大的5个知识型职业。

- 任务开发:由资深专家根据实际工作成果(如法律合同、工程图纸)设计任务,包含参考文件、上下文及预期交付物。

- 审核机制:任务需通过至少5轮专家评审(包括模型可行性与清晰度校验),确保质量。

- 评估方法:

- 盲审对比:行业专家在不知情的情况下,对比AI与人类专家的交付成果,按“更好”“相当”“更差”评分。

- 自动评分器:训练AI系统预测人类专家偏好,作为辅助评估工具(目前可靠性低于专家评审)。

- 性能指标:

- 胜率(Win Rate):模型输出被评为“优于或相当”于人类专家的任务比例。

- 成本与效率:计算模型完成任务的时间(比人类快约100倍)和API费用(仅为人类成本的1%),虽未涵盖全部实际成本,但反映基础效率优势。

创新点

- 经济价值导向:

首次以GDP贡献为指标,系统化评估AI对关键行业和职业的实际影响,填补传统学术基准(如MMLU)与商业应用之间的空白。 - 跨行业评估体系:

覆盖9大行业、44种职业,提供比领域专用基准(如SWE-Bench软件工程评估)更全面的视角。 - 多模态现实评估:

要求模型处理完整工作背景并输出复杂交付物,超越简单文本提示任务,更贴近真实工作场景。 - 开源生态建设:

开源220个黄金任务子集及评分工具,降低研究门槛,促进社区协作与模型优化。

评估标准

- 任务完成质量:

- 准确性:交付物是否符合专业标准(如法律条款无误、工程参数正确)。

- 美观性:文档格式、幻灯片布局等视觉呈现质量(Claude 4.1在此维度领先)。

- 完整性:是否涵盖任务要求的所有关键要素。

- 效率与成本:

- 推理速度:模型完成任务的时间与人类专家的对比。

- API费用:生成交付物所需的计算资源成本。

- 专家评分一致性:

通过多轮盲审确保评分标准统一,减少主观偏差。

应用领域

- 企业决策支持:

帮助企业评估AI模型在特定业务场景中的适用性(如用AI生成法律文书降低人力成本)。 - 职业培训与发展:

为从业者提供AI能力边界参考,辅助规划技能提升路径(如工程师需加强哪些领域与AI协作)。 - 政策研究与制定:

为政府机构提供AI对劳动力市场影响的量化数据,支持就业政策调整。 - AI模型优化:

开发者可根据评估结果定位模型短板(如准确性不足或美观性欠佳),针对性改进。

项目地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...