FLM-Audio : 智源研究院开源的全双工音频对话模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

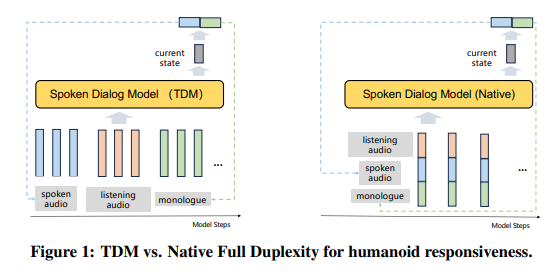

FLM-Audio是由北京智源人工智能研究院联合Spin Matrix与新加坡南洋理工大学共同发布的原生全双工音频对话大模型。该模型支持中文和英文,采用原生全双工架构,能够在每个时间步合并听觉、说话和独白通道,实现“边听边说”的交互模式,有效解决了传统时分复用方案的高延迟问题。FLM-Audio通过自然独白与双重训练范式,使模型在对话中更接近人类的自然交流方式,显著提升了语音交互的自然度和流畅性。

功能特点

- 全双工语音交互:实现“边听边说”,用户可随时打断模型,模型能即时暂停输出并理解新问题后回应,交互自然流畅,延迟低。

- 支持多语言:模型支持中文和英文两种语言,能够满足不同语言用户的对话需求。

- 自然语音建模:采用“自然独白”方式模拟人类说话节奏,通过“双重训练”强化语言与声学语义对齐,兼顾低延迟与语言建模性能。

- 低数据高效训练:仅用约100万小时音频数据训练出70亿参数模型,在嘈杂环境、频繁打断场景下仍保持高鲁棒性和自然度。

- 强鲁棒性:对噪声和用户打断具有较强的鲁棒性,能迅速停顿当前输出、准确理解新问题并即时作答,保证对话的流畅性和准确性。

优缺点

优点:

- 响应敏捷自然:采用原生全双工架构,实现低延迟交互,用户体验接近真人对话。

- 多语言支持:满足不同语言用户的对话需求,具有广泛的应用前景。

- 高效训练:利用少量音频数据训练出高参数量模型,降低训练成本。

缺点:

- 音色克隆未专门优化:在文本转语音任务中,SIM分数较低,音色克隆能力有待提升。

- 对硬件要求较高:由于模型参数量较大,对硬件资源有一定要求。

如何使用

- 访问项目平台:通过GitHub仓库或Hugging Face模型页获取FLM-Audio模型。

- 选择使用方式:根据需求选择本地部署、在线推理或集成到现有系统中。

- 输入音频:通过麦克风或音频文件输入问题,模型将实时生成回答。

- 获取回答:模型将边听边说,即时回应问题,用户可随时打断并调整对话方向。

框架技术原理

FLM-Audio采用原生全双工架构,将听觉、说话和独白通道在每个时间步合并处理,实现“边听边想边说”。模型通过自然独白训练,采用连续句段与停顿组成的“自然独白”代替逐词对齐,更接近人类真实说话方式。同时,通过双重训练策略,将独白交替放在音频首尾进行训练,强化语言与声学语义的对齐,提高模型对语音内容的理解和生成能力。

创新点

- 自然独白对齐:从“词对齐”到“句对齐”,允许模型先完成整个句子的文本生成,再统一决定最自然的语音表达方式,提升发音准确性和语言连贯性。

- 双重训练范式:通过后训练和有监督微调,构建“听说能力”全闭环,使模型在全双工交互中表现更自然、更强大。

- 低数据高效训练:利用少量音频数据训练出高参数量模型,为模型训练效率与泛化能力打开新空间。

评估标准

FLM-Audio的评估主要基于以下标准:

- 音频理解能力:通过自动语音识别(ASR)和语音问答(Spoken QA)任务评估模型对语音内容的理解能力。

- 音频生成能力:通过文本转语音(TTS)任务评估模型生成语音的自然度和流畅性。

- 全双工对话能力:通过多轮语音对话任务评估模型在实时交互中的表现,包括响应速度、流畅度、对打断的处理能力等。

应用领域

- 游戏与虚拟现实(VR):NPC可实现不间断、可打断的自然语音互动,增强游戏的沉浸感。

- 智能客服:低延迟对话减少用户等待,提升客服效率和用户体验。

- 智能陪伴:为用户提供更接近真人的语音互动,增强陪伴感。

- 语音助手:在智能家居、智能办公等场景中,提供更自然的语音交互体验。

- 会议辅助:在多人会议中,实时翻译、记录和互动,提高会议效率。

项目地址

- GitHub仓库:https://github.com/cofe-ai/flm-audio

- Hugging Face模型页:https://huggingface.co/CofeAI/FLM-Audio

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...