RTFM : 李飞飞团队推出的实时生成式世界模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

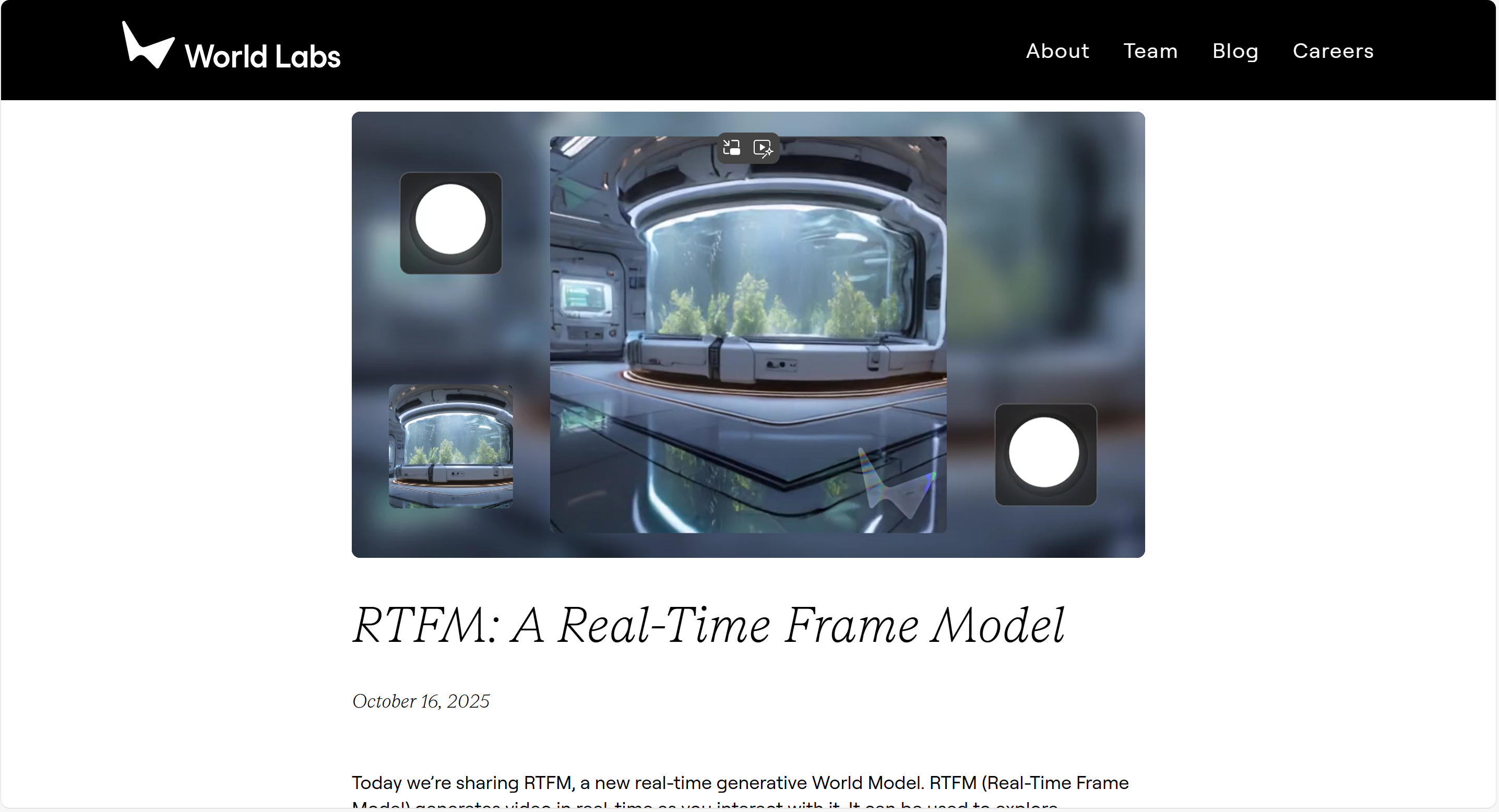

RTFM(Real-Time Frame Model)是由斯坦福大学教授李飞飞团队World Labs于2025年10月17日发布的实时生成式世界模型。该模型基于生成式视频建模技术,通过单张或多张2D图像输入,实时生成交互式3D场景,并支持持久化探索。其核心设计遵循高效性(单块H100 GPU实现60帧4K交互)、可扩展性(随算力增长持续进化)和持久性(无限时长场景记忆)三大原则,旨在构建“永不消逝的3D世界”。

功能特点

- 实时3D场景生成:输入单张照片即可生成可自由漫步、交互的3D世界,支持推拉变焦、鱼眼失真等镜头效果。

- 复杂光影模拟:能精准渲染反射、阴影、光泽表面、镜头光晕等物理效果,无需人工规则定义。

- 持久化交互:场景不会因用户离开而消失,支持长时间探索后的场景一致性。

- 重建与生成融合:输入视角充足时倾向精确重建,视角稀缺时进行合理内容推演。

- 低硬件门槛:仅需单块H100 GPU即可运行,打破传统3D引擎对算力的依赖。

优缺点

- 优点:

- 高效性:单卡运行实现交互级帧率,降低硬件成本。

- 可扩展性:架构支持随数据与算力增长持续优化。

- 持久性:通过空间记忆机制解决传统自回归模型的“遗忘”问题。

- 缺点:

- Demo体验限制:当前预览版仅支持3分钟交互,持久性尚未完全实现。

- 动态场景支持不足:目前主要针对静态场景,动态交互(如移动物体)需后续优化。

如何使用

- 在线Demo体验:访问RTFM官方Demo,上传图片即可实时生成3D场景并交互探索。

- 预训练模型调用:通过HuggingFace或World Labs提供的API接口,直接调用模型进行场景生成与渲染。

- 集成至现有系统:利用官方工具链(如Tokenizer与DeTokenizer),通过配置文件调整参数(如分辨率、光影效果),快速适配语音助手、车载系统等场景。

框架技术原理

RTFM采用自回归扩散Transformer架构,核心流程如下:

- 输入处理:将单张或多张2D图像转换为隐式世界表征(KV缓存)。

- 帧序列预测:通过注意力机制从KV缓存中读取信息,生成新视角下的连贯图像。

- 空间记忆机制:为每帧赋予三维空间位姿(位置与方向),构建带空间结构的记忆系统。

- 上下文调度:生成新帧时,仅检索邻近帧作为参考,避免全局数据加载,实现高效持久化。

该模型通过海量视频数据端到端训练,自动掌握3D几何、反射、阴影等特征,无需显式3D建模。

创新点

- 隐式世界表征:摒弃传统3D网格,通过神经网络激活值(KV缓存)隐式表示世界,降低建模复杂度。

- 空间记忆与上下文切换:引入位姿帧作为空间记忆,结合动态上下文调度,解决持久性难题。

- 重建-生成边界模糊:同一模型兼顾精确重建与内容推演,适应不同输入条件。

- 单卡高效运行:通过架构优化与模型蒸馏,在单块H100 GPU上实现实时4K渲染。

评估标准

- 生成质量:通过信噪比(SNR)、结构相似性(SSIM)等指标评估渲染图像的清晰度与物理准确性。

- 交互延迟:测量帧生成时间,确保实时性(如60帧/秒下延迟低于16ms)。

- 持久性验证:测试长时间交互后场景的一致性,评估空间记忆机制的稳定性。

- 资源效率:计算每帧生成的GPU占用率与能耗,优化算力利用。

应用领域

- 游戏行业:实时生成无限探索的3D游戏世界,降低开发成本。

- 内容创作:助力电影、动画制作,快速生成复杂场景与光影效果。

- 虚拟现实(VR)/增强现实(AR):提供持久化、高保真的虚拟环境,增强沉浸感。

- 机器人仿真:模拟真实物理世界,训练机器人导航与交互能力。

- 建筑设计:可视化设计效果,支持实时修改与场景漫游。

项目地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...