Video-LLaVA是北京大学研究者们提出的一种全新的视觉语言大模型。该模型通过创新的技术手段,使得大型语言模型(LLM)能够同时处理和理解图片与视频内容,推动了多模态学习的边界,并在视频问答等下游任务中取得了卓越的性能表现。

Video-LLaVA的功能特点

- 多模态处理能力:Video-LLaVA模型能够处理和理解图片与视频内容,通过联合图片和视频的训练与指令微调,大幅提高了计算效率和模型性能。

- 先进的性能:在13个基准的图片和视频理解任务上,Video-LLaVA均达到了先进水平,尤其在视频问答方面,模型展现出了优越的性能,全面超越了Video-ChatGPT等先前的模型。

- 视觉语言理解:通过预先对齐视觉输入,Video-LLaVA在图片理解的多个方面也取得了显著进步,包括减少幻觉现象和提升OCR能力等。

如何使用Video-LLaVA

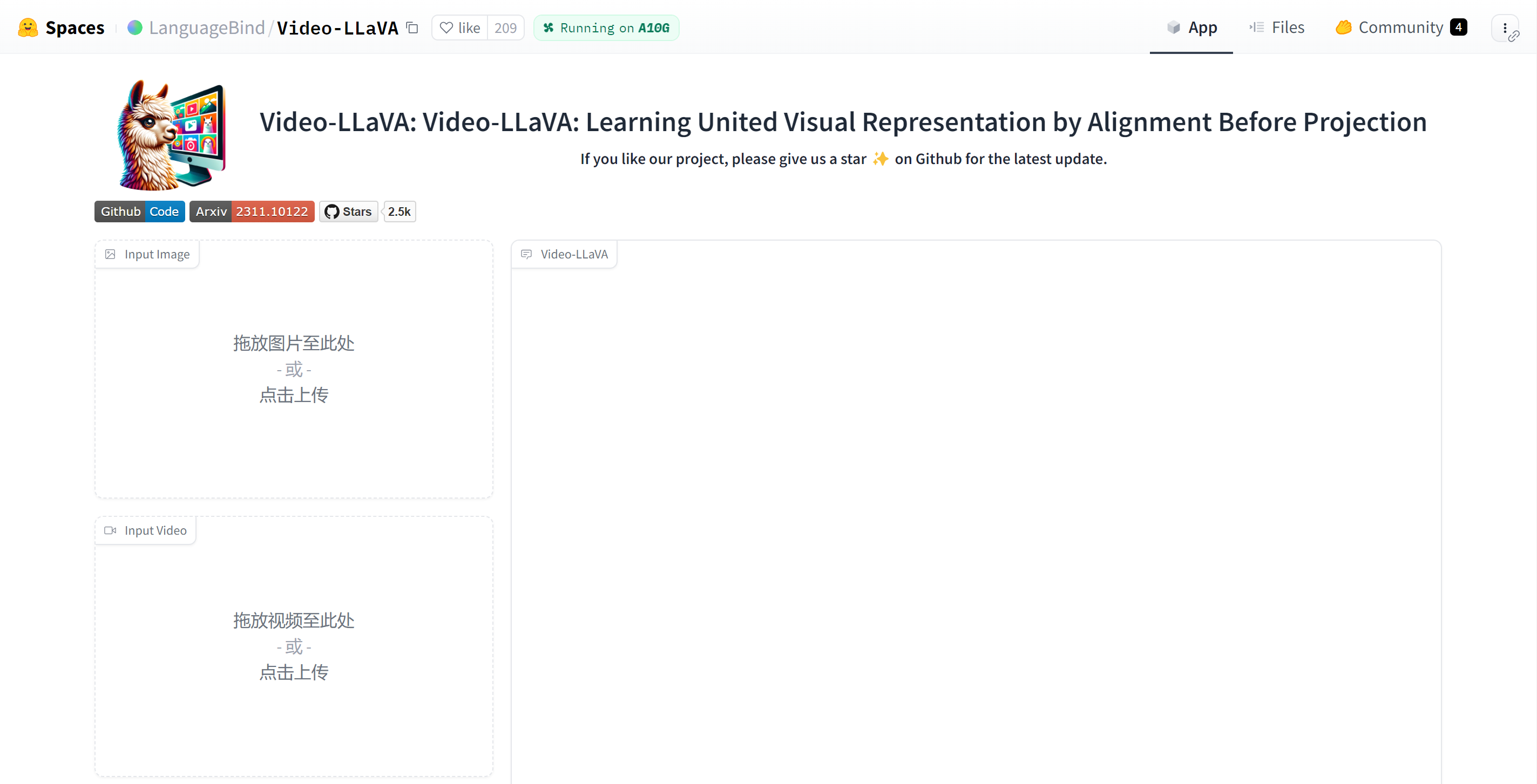

- 访问Hugging Face空间:首先,你需要访问Hugging Face上的Video-LLaVA空间。

- 模型体验与测试:在空间页面上,你可以直接体验模型的各种功能,包括图片和视频的理解、问答等。

- 下载与部署:如果你希望在自己的环境中使用Video-LLaVA,可以从Hugging Face下载模型,并根据提供的指南进行部署。

Video-LLaVA的收费标准

- 关于Hugging Face平台的计算服务收费,根据最新的消息,Hugging Face已经对其计算服务定价进行了大幅调整,整体价格下降了50%。不过,具体的收费标准可能会因服务类型、使用量等因素而有所不同。

- 对于Video-LLaVA模型本身,目前是开源的,可以在Hugging Face上免费下载和使用。但如果你需要使用Hugging Face提供的计算资源来运行模型,那么可能会产生一定的费用。

AI工具和资源推荐-AI全网资源导航-aiguide.cc

相关导航

暂无评论...