10月9日·AI技术助力DeepMind创始人与科学家共获诺贝尔化学奖

10月9日·周三 AI工具和资源推荐

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

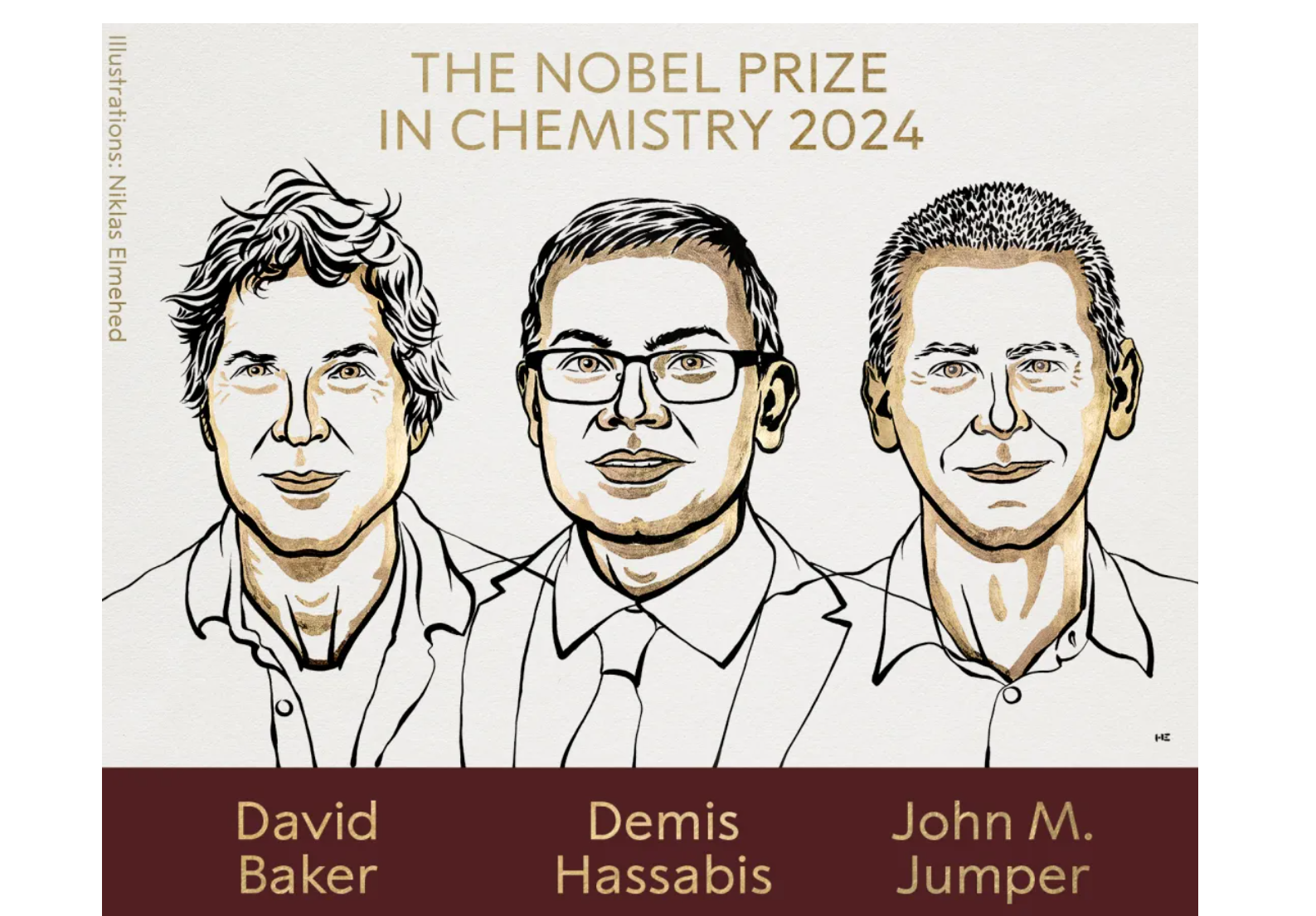

AI技术助力DeepMind创始人与科学家共获诺贝尔化学奖

2024年诺贝尔化学奖授予了在人工智能蛋白质研究领域做出杰出贡献的科学家。其中,DeepMind的Demis Hassabis和John M. Jumper因开发AlphaFold 2,成功预测蛋白质结构而获奖。同时,华盛顿大学的David Baker因其在计算蛋白质设计方面的开创性工作而共享此殊荣。AlphaFold 2的问世解决了生物学中长达50年的难题,使得蛋白质结构的预测变得快速而准确,极大地推动了生物医学研究的发展。Baker教授则通过其RoseTTAFold算法,成功设计出全新的蛋白质种类,为生物技术领域带来革命性的影响。此次诺贝尔化学奖的颁发,不仅是对科学家们个人成就的认可,更是对AI技术在科学研究中应用的肯定。来源:微信公众号【新智元】

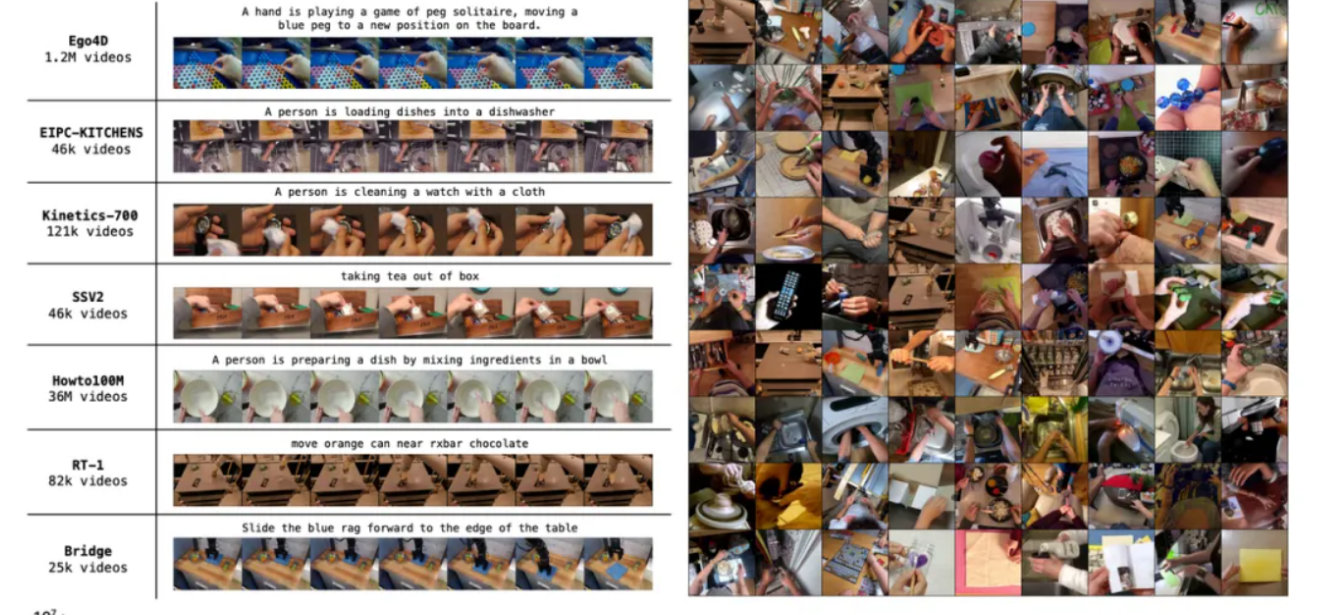

ByteDance Research推出新一代机器人大模型GR-2

ByteDance Research最近发布了其第二代机器人大模型GR-2,该模型在预训练阶段通过分析3800万个互联网视频片段,学习了人类在不同环境下的日常活动,从而具备了强大的世界建模能力和泛化能力。GR-2在多任务学习和未知场景适应方面表现出色,能够在105项不同的桌面任务中达到97.7%的平均成功率。此外,GR-2还结合了大语言模型,能够执行复杂的长任务,并与人类互动。在工业应用中,GR-2展现了端到端物体拣选的能力,能够准确抓取包括透明、反光和柔软物体在内的多种物品,显示出在真实仓储场景中的潜力。尽管GR-2在互联网视频上接受了大规模预训练,但其在真实世界动作数据的规模和多样性上仍有提升空间。来源:微信公众号【机器之心】

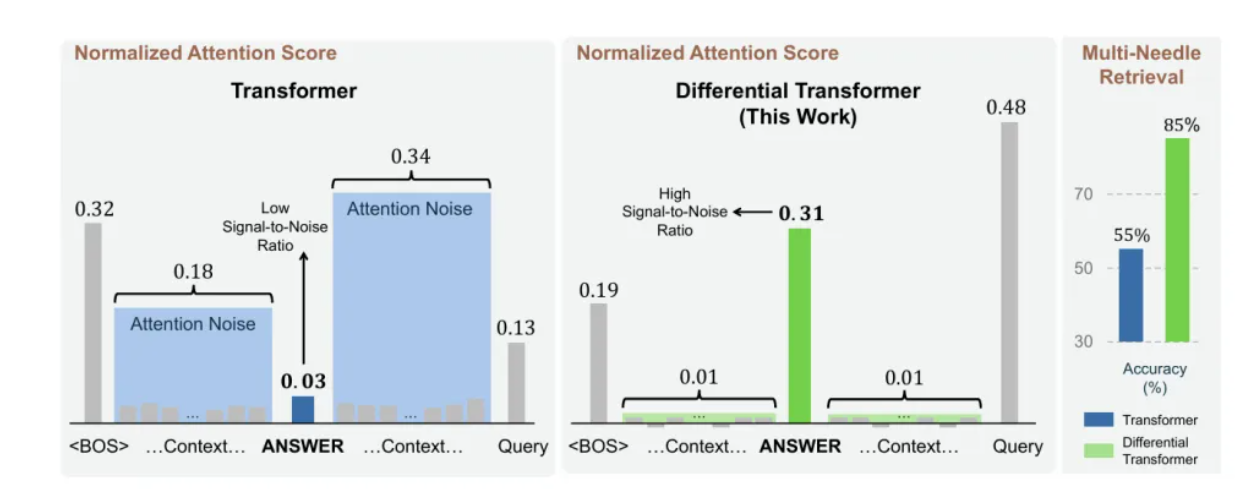

清华大学与微软联合推出革新Transformer模型

清华大学与微软研究院的研究人员联合提出了一种名为Differential Transformer(DIFF Transformer)的新型模型架构,该架构通过引入物理学中的差分概念革新了传统的Transformer注意力机制。DIFF Transformer通过差分注意力机制,显著提升了模型在长上下文任务中的性能,特别是在“大海捞针”关键信息检索测试中,相较于传统Transformer,精度暴涨了30%。此外,该模型在缓解语言模型中的幻觉问题方面也显示出了明显的优势。实验表明,DIFF Transformer在各种下游任务上均展现出强大的性能,且随着模型规模的增加,其性能提升更加显著。这项研究为自然语言处理领域带来了新的突破,有望推动相关技术的发展。来源:微信公众号【新智元】

OpenAI获英伟达DGX B200超算支持,与微软算力合作生变

OpenAI近日收到了英伟达首批工程版DGX B200超级计算机,这标志着其在人工智能领域的硬件支持进一步增强。DGX B200作为目前市面上最强大的AI算力平台之一,将为OpenAI在大型模型训练方面提供显著的性能提升。然而,与此同时,OpenAI与微软之间的算力合作似乎出现了裂痕。据外媒报道,由于微软未能及时提供足够的算力支持,OpenAI正在与甲骨文进行谈判,可能寻求新的数据中心合作伙伴。这一变化可能会影响OpenAI未来在AI领域的研究和商业化进程。此外,OpenAI也在考虑自主开发AI芯片以降低成本。来源:微信公众号【新智元】

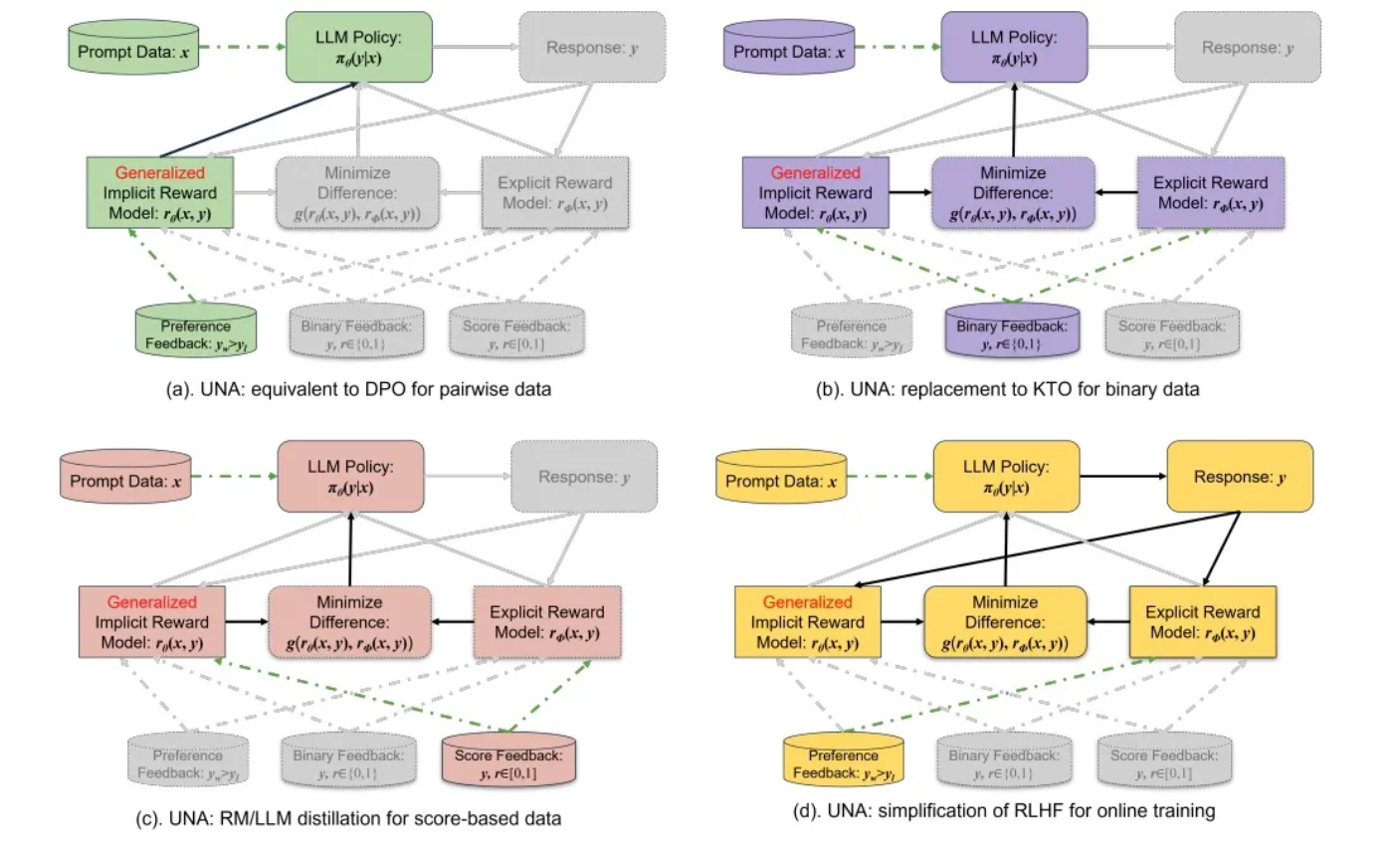

Salesforce与厦门大学联合推出语言模型对齐新框架UNA

Salesforce和厦门大学的研究团队联合提出了一种名为UNA(Unified Alignments)的新方法,旨在统一和优化当前主流的大规模语言模型(LLM)对齐技术,包括RLHF、DPO和KTO。UNA通过引入一个通用的隐式奖励函数,将这些技术融合为一个监督学习问题,简化了模型训练流程,并提高了对齐性能的稳定性和效率。UNA能够处理成对反馈、二元反馈以及基于评分的反馈等多种反馈数据类型。实验结果显示,UNA在多个下游任务中相较于传统方法有显著的性能提升,尤其在训练速度和内存占用方面表现出色。来源:微信公众号【机器之心】