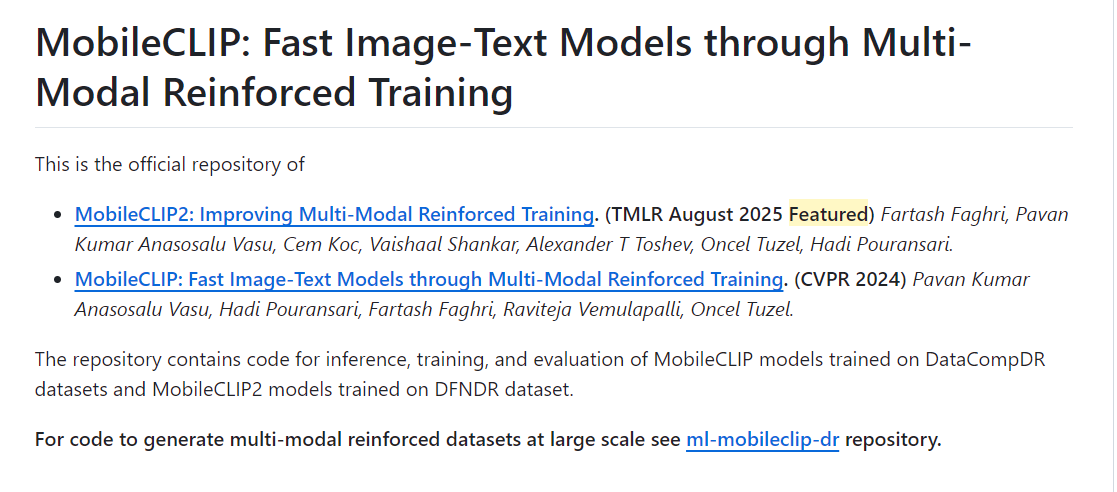

MobileCLIP2 : 苹果开源的端侧多模态模型

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

主要介绍

MobileCLIP2是苹果公司推出的新一代高效端侧多模态模型,作为MobileCLIP的升级版本,通过改进多模态强化训练机制,在低延迟、轻量级模型上实现了新的SOTA(State-of-the-Art)性能。该模型专为零样本分类和检索任务设计,推理延迟在3-15毫秒之间,参数规模在50M至1.5亿不等,支持在移动设备上直接部署,无需依赖云端计算。

功能特点

- 零样本分类与检索

- 支持基于文本描述的图像分类和检索,无需额外训练数据即可快速适应新任务。

- 在ImageNet-1k零样本分类任务中,准确率较上一代模型提升2.2%。

- 多模态特征提取

- 为图像和文本提取高质量的多模态特征,支持下游任务如目标检测、语义分割等。

- 高效模型架构

- 设计了轻量级的模型变体(如MobileCLIP2-B和MobileCLIP2-S4),在保持高性能的同时,显著降低计算复杂度和推理延迟。

- 低延迟与低内存占用

- 模型变体MobileCLIP2-S4在iPhone 12 Pro Max上的延迟约为DFN ViT-L/14的40%,参数量仅为SigLIP-SO400M/14的一半。

优缺点

优点

- 性能卓越:在零样本分类和检索任务中表现优异,支持多模态特征提取。

- 轻量高效:模型参数规模小,推理延迟低,适合端侧部署。

- 开源生态完善:提供预训练权重和数据生成代码,支持开发者直接部署和基准测试。

缺点

- 特定场景优化不足:在复杂场景(如遮挡、光照变化)下的性能仍有提升空间。

- 合成数据依赖:部分性能提升依赖于合成字幕数据,可能影响模型在真实场景中的泛化能力。

如何使用

- 环境配置

- 支持PyTorch框架,提供4-bit AWQ量化技术以降低显存占用。

- 输入指令

- 通过自然语言描述需求(如“根据文本描述检索相关图像”),或上传图像文件并指定任务(如“生成图像描述性文本”)。

- 生成与调优

- 支持微调与优化,在多样且高质量的图像-文本数据集上进一步提升模型在特定任务上的表现。

框架技术原理

- 多模态强化训练

- 通过优化CLIP教师模型集成和图文生成器教师模型的训练,提升模型对图像和文本的联合理解能力。

- 对比知识蒸馏

- 从大型教师模型中提取关键信息,传递给小型学生模型,实现模型性能与效率的平衡。

- 合成文本生成

- 利用改进的图文生成器生成高质量的合成文本,丰富训练数据,提升模型对文本多样性的理解和生成能力。

创新点

- 更强的CLIP教师模型

- 用DFN预训练的CLIP模型替换先前的集成,提升教师监督模型的性能。

- 更高质量的合成标题生成器

- 通过两阶段协议(初始再训练+后续微调)优化字幕生成教师模型,生成具有增强语义质量和多样性的合成标题。

- 高效的模型架构

- 设计了5阶段图像编码器结构,参数分布更均匀,能更有效地扩展到更高的图像分辨率。

评估标准

- 零样本分类准确率

- 在ImageNet-1k等基准数据集上评估模型的分类性能。

- 检索精度

- 衡量模型根据文本描述检索相关图像的能力。

- 推理延迟与内存占用

- 在移动设备上评估模型的推理速度和资源消耗。

- 下游任务性能

- 在视觉语言模型评估、密集预测任务等下游任务中评估模型的表现。

应用领域

- 移动应用

- 增强现实应用、个人助理、实时照片分类等,使手机能在本地完成数据处理,无需将数据发送到云端。

- 边缘计算

- 适合带宽和处理能力有限的边缘计算环境,如无人机、机器人和远程传感器等设备,可利用模型执行视觉识别任务,实现实时决策。

- 物联网设备

- 可集成到物联网(IoT)设备中,如安全摄像头或智能家居助手,使这些系统能执行本地视觉识别,具有隐私保护、低延迟和在互联网连接不稳定环境中运行的优势。

- 图像与文本处理

- 作为特征提取器,为图像和文本提取高质量的多模态特征,支持下游任务如扩散模型(如Stable Diffusion)和多模态大语言模型(如LLaVA)。

项目地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...