11月27日·NeurIPS 2025奖项揭晓,Qwen与Faster R-CNN脱颖而出

11月27日·周四 AI工具和资源推荐

AI智库导航-aiguide.cc为您提供最新的AI新闻资讯和最新的AI工具推荐,在这里你可以获得用于营销的AI聊天机器人、AI在商业管理中的应用、用于数据分析的AI工具、机器学习模型、面向企业的AI解决方案、AI在商业客户服务中的应用、AI和自动化工具等。

NeurIPS 2025奖项揭晓,Qwen与Faster R-CNN脱颖而出

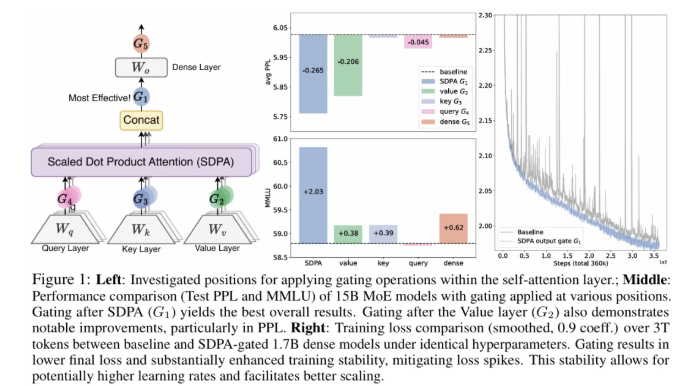

人工智能顶会NeurIPS 2025公布了其备受瞩目的奖项,其中包括最佳论文奖和时间检验奖。今年的最佳论文奖由四篇论文共同获得,涵盖了扩散模型理论、自监督强化学习、大语言模型中的注意力机制等多个前沿方向。其中,Qwen团队的研究成果《Gated Attention for Large Language Models: Non-linearity, Sparsity, and Attention-Sink-Free》因其在大语言模型注意力机制方面的创新性贡献而脱颖而出。该研究首次揭秘了注意力门控对大模型性能和训练的影响,并已应用于Qwen3-Next模型,显著提升了模型的性能与鲁棒性。此外,任少卿、何恺明等人的《Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks》因其在计算机视觉领域的深远影响获得了时间检验奖。NeurIPS 2025共收到21575份有效投稿,最终接收5290篇,整体录用率为24.52%。来源:微信公众号【机器之心】

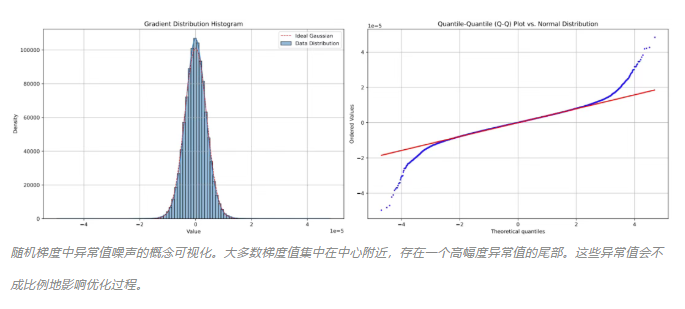

华为诺亚开源ROOT优化器,破解大模型训练难题

在大语言模型(LLM)优化领域,Adam和Muon一直是两种主流的优化方法。Adam以其稳定性著称,但在面对十亿级参数的混合精度训练时,常因数值不稳定性而受限;Muon则以其高效性闻名,但对异常值噪声极为敏感,鲁棒性不足。华为诺亚方舟实验室最新推出的ROOT(Robust Orthogonalized OpTimizer)优化器,成功解决了这一“既要又要”的两难困境。ROOT通过自适应的正交化系数和软阈值机制,不仅修复了Muon在不同矩阵维度上的精度问题,还为梯度噪声装上了“减震器”。实验表明,ROOT在收敛速度和稳定性上均优于现有方法,为大模型训练提供了一种全新的优化范式。ROOT的开源,有望开启一个新的优化器时代,推动大模型训练技术的发展。来源:微信公众号【机器之心】

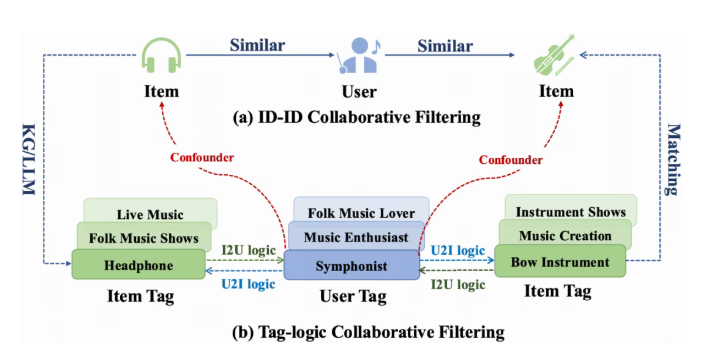

快手团队提出TagCF框架,让推荐系统真正“懂你”

推荐系统在日常生活中扮演着重要角色,但传统的推荐系统往往侧重于内容的理解,而忽视了对用户的深入理解。快手消费策略算法团队联合快手基础大模型与应用部及武汉大学,提出了TagCF框架,旨在让推荐系统不仅“会猜”,更能“懂你”。TagCF通过引入用户角色(user role)和兴趣点(item topic)的概念,构建了一个以用户理解为核心的推荐系统方法论。该框架包含三个主要模块:基于MLLM的视频内容理解中台、基于LLM的行为逻辑图探索中台和赋能下游推荐系统的增强模块。TagCF不仅能够有效提升推荐的准确率和多样性,还能显式地建模用户的信息茧房并进行突破。相关研究成果已被NeurIPS 2025接收,并已全面开源,为学术界和工业界提供了一种新的推荐系统解决方案。来源:微信公众号【机器之心】

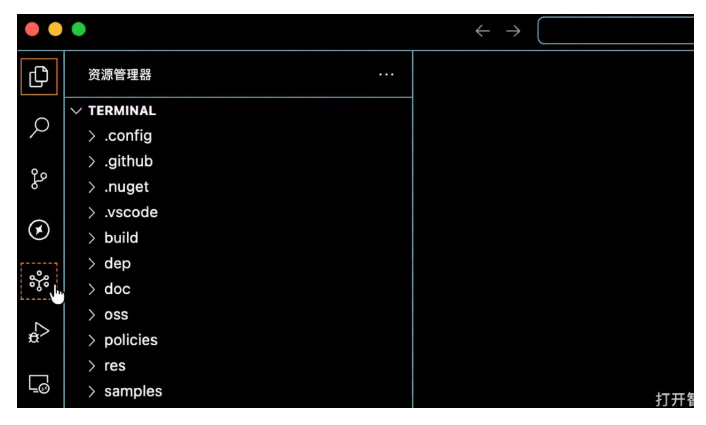

国产AI编程工具Qoder,让代码项目管理轻松高效

国产AI编程工具Qoder以其强大的功能和高性价比,正在改变程序员的工作方式。Qoder能够快速生成项目Wiki,帮助开发者快速理解复杂的代码项目。例如,在处理包含近10000个代码文件的项目时,Qoder可以在短时间内生成详细的项目文档,极大地提高了开发效率。Qoder不仅支持IDE、CLI和JetBrains插件等多种形态,还具备强大的代码理解和生成能力。其最新版本在模型性能、覆盖范围和性价比上均达到了行业领先水平。Qoder的创始人叔同强调,该工具专注于“真实软件”研发,旨在帮助开发者更好地理解和管理复杂的代码项目。Qoder的出现,不仅为开发者提供了强大的工具支持,也为AI编程领域树立了新的标杆。来源:微信公众号【量子位】

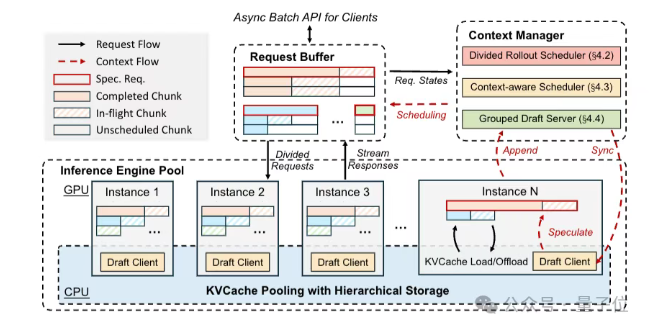

月之暗面加速强化学习训练,效率大幅提升

月之暗面加速强化学习训练,效率大幅提升文,提出了一种新的脉冲神经网络架构Max-Former。该研究发现,SNN性能不佳的根源在于脉冲神经元的低通滤波特性,导致高频信息的丢失。Max-Former通过在Patch Embedding中引入额外的Max-Pool和用深度卷积替代早期阶段的自注意力,有效补偿了这种频率偏置。在多项基准测试中,Max-Former不仅大幅提升了性能,还降低了超过30%的能量消耗。这一成果为类脑模型的优化提供了新的方向,推动了SNN在实际应用中的发展。来源:微信公众号【量子位】